2018年,五大热门关键词领跑存储市场 原创

年末将至,各大行业市场逐步进行盘点期。对于企业级存储行业来说,2017年是充满神奇色彩的一年,也是丰收的一年。这一年,业内知名企业东芝出售旗下芯片业务、西部数据收购初创公司Tegile、Dell EMC大力投入全闪存存储、HPE收购超融合厂商SimpliVity、NetApp推出基于SolidFire的超融合系统……一系列事件着实让存储圈热门一番。

展望2018年,企业产生的数据趋势并没有放缓迹象,大数据、物联网和分析市场的崛起持续促使数据继续增长,而这一激增也推动了其底层基础设施的发展。

事实上,数据存储技术的快速增长也是IT基础设施变革的最大因素,根据Interop ITX和InformationWeek 2018基础设施的研究证明,有50%的受访者认为如今企业对数据存储的需求已经远远超过了整合云服务的需求。

ESG高级分析师Scott Sinclair在接受采访时表示,目前数据已接近临界点,随着我们进一步步入数据经济,在未来一年中,企业为了实现数据战略目标,将在数据中心投资更多存储硬件,在云中存储更多数据,并继续研究新兴存储技术。而在2018年,有五大热门关键词将继续领跑企业级存储市场。

全闪存

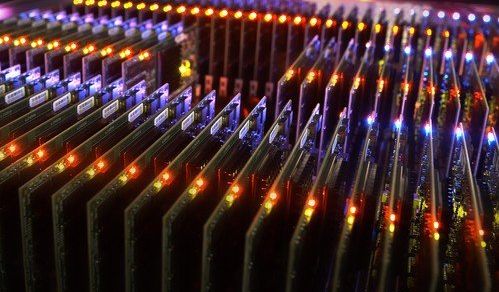

近几年,存储介质突飞猛进,高速、容量、性能也在快速提升,全闪存作为最热门的存储介质之一,在数据爆炸增长的今天变得尤为重要,同时也为存储架构和存储协议的发展带来了全新变革。

其实全闪存也并不是什么新出现的技术,业内戴尔EMC、IBM、NetApp、华为等厂商一直在做,只是之前因为成本的原因限制了全闪存的普及。随着全闪存技术的不断提升和价格的逐渐走低,这个市场有望进入快速增长期。据悉,在未来一年中,各大厂商会继续发力全闪存市场,在性能、IOPS等技术上继续优化,为用户提供更强大、更简单的解决方案,以加速数字化转型。

超融合

超融合(Hyper Converge Infrastructure,HCI)是近几来IT界广受关注的话题之一,也成为众多厂商主要发力的方向,市场竞争尤为激烈。据Interop ITX的研究证明,有65%的受访者表示他们正在使用、计划使用或寻求超融合基础设施,而20%表示他们并不感兴趣。

纵观如今的超融合市场,最早推广这个概念的是Nutanix,起步的核心技术是分布式存储,只是在部署架构上融入了创新元素,采用融合的形式,这种形式也进一步推动了分布式存储的市场落地。目前中国的超融合市场玩家众多,除了戴尔、EMC、华为、联想、Nutanix这些一线国际大厂之外,还有浪潮、曙光以及众多初创企业。不过,市场目前还是属于初期阶段,竞争还是比较激烈的。

软件定义存储

随着软件定义数据中心、软件定义网络、软件定义存储纷纷推出市场,"软件定义"技术已全面爆发。据IDC预测,2017年至2021年,全球软件定义存储市场年复合增长率将达到13.5%,2021年营收达到约162亿美元。

软件定义存储,顾名思义主要是通过借助软件实现虚拟化,配置和重复数据删除等功能,并通过自动化对存储网络加速,其主要意义是实现用户可扩展性和灵活性。

Hadoop/Spark

自大数据兴起以来,更强的计算机及更成熟的大数据平台工具使企业掌握挖掘数据价值的技巧。目前国内已经广泛应用于制造、金融、电信、医疗以及能源领域,这些领域每天都有数以亿计的数据产生,对于大数据资产的存储、挖掘、分析等流程都有一定的要求。

Hadoop是由Doug Cutting于2005年发起的项目,采用开源软件框架对超大数据集进行分布式存储技术及分布式处理。换句话说,设计这一产品的目的在于缩减处理大数据集的时间及成本。Spark是近年来新兴的一个分布式大数据处理引擎,采用了类Hadoop MapReduce的通用的并行计算框架,而不同于MapReduce的是输出和结果可以保存在内存中,性能更好,因此能更好地适用于数据挖掘与机器学习等应用,一度被认为有望取代Hadoop。其实,这两者协作要大于竞争。

云存储

随着信息技术的飞速发展,云技术日趋成熟,通过云技术将信息资源进行存储共享被越来越多现代企业广泛应用,包括备份和恢复、归档等。

追其根源,其实是Dropbox公司首席执行官Drew Houston在2007年在忘记带USB存储设备且不知道放在哪里的时候,当时萌生了创建个人和小型企业云存储的想法,而如今,几乎每个人都寻求到了属于自己的云存储产品。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

Salesforce推出AI能力框架助力企业数字化转型

大众汽车牵手高通打造智能网联座舱体验

Ruby 4.0.0发布:引入ZJIT编译器和Ruby Box隔离技术

Meta签约三家核能公司为AI数据中心提供6.6吉瓦电力

大多数开发者不信任AI生成代码却不检查

大规模数据中心安全防护中人员因素的关键作用

HPE OneView严重漏洞遭野外攻击利用

安联保险与Anthropic达成全球合作加速负责任AI应用

智能硬件助力Apple Home:Flic物理按钮控制解决方案

CES硬件创新展示与CIO升级决策之间的平衡

谷歌警告:为大语言模型制作碎片化内容将损害搜索排名

CES 2026聚焦"物理AI",机器人技术成最大亮点

Wasabi推出Fire高性能存储服务挑战云巨头

VAST AI OS进驻Azure,构建全球AI运营数据平台

Vast Data与CoreWeave的11.7亿美元合作协议释放重要信号

Backblaze云存储收入强劲增长,备份业务持续停滞

IDC报告,深信服在2025年上半年位居中国超融合市场、中国全栈超融合市场第一

Word新增云端自动保存功能,文档创建即刻备份

日立Vantara将VSP One块存储扩展至Azure云平台

Backblaze硬盘统计显示20TB级驱动器表现优异

日立Vantara将VSP One SDS扩展至谷歌云平台

Google 在封锁 Nextcloud Files 应用后逆转决定