NetApp游庆洪:SolidFire为无精力管理存储产品的用户而备 原创

在科技圈,收购是一件平常的不能再平常的事情。在每年重大并购事件中,总会有一些企业的并购案成为各大媒体争相报道的头条。而NetApp就是其中之一。

在过去的一年中,NetApp完成了对SolidFire的收购,加速了下一代数据中心的发展。转眼间,SolidFire加入NetApp大家庭已有一周年的时间。回首这一年中,NetApp已经取得了很多令人欣喜的成就。接下来就是NetApp SolidFire全力奋战的时候了。

我们知道,NetApp在全闪存领域已经有了比较完善的存储阵列产品,即AFF、EF,而对于此次的并购,NetApp下一代数据中心及联盟合作伙伴副总裁Tim Pitcher认为,SolidFire的加入将强化NetApp超融合业务发展,同时也帮助企业客户发展并打造下一代的数据中心。

NetApp下一代数据中心及联盟合作伙伴副总裁Tim Pitcher

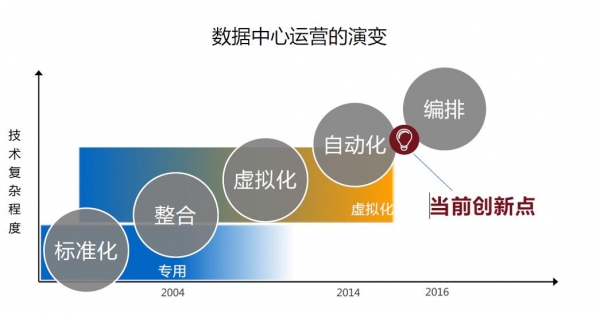

纵观当前数据中心,全新的运营模式也在悄然兴起,逐渐走向虚拟化、自动化,现在已然到了一个非常重要的转折点。当下不少客户希望能够充分利用下一代数据中心和云计算的能力。在Tim 看来,随着数据中心技术从虚拟化的环境演变到高度自动化,并且可以完全编排、完全协调的数据中心环境,使得广大客户可以在自己的IT环境中更加灵活。这也是在整个计算历史上,自从PC发明以来的又一次大变革和创新。

可以看出,传统的数据中心对于IT的采购、部署和消费方式已经发生了变化。变革已成为新常态。无论是云计算、私有云、混合云、第三平台等,虽然表述方法不同,但其实都是讲下一代数据中心。

针对云计算市场应用需求,NetApp SolidFire应运而生。我们知道,NetApp已经成为一家提供数据管理服务的厂商,其ONTAP软件、Data Fabric的愿景以及前面所提到的AFF、EF两个系列全闪存阵列奠定了在存储市场的地位。而SolidFire此前是一家独立运行的公司,主要使命和任务是打造下一代的数据中心,让用户能够以服务的方式来购买和使用SolidFire。此次SolidFire加入NetApp,进一步为实现下一代数据中心争得了话语权。

Tim介绍道,无论是私有云还是公有云环境中,我们可以租用计算、技术能力,但必须将数据掌握在自己手中,在今天这样一个数字化世界当中,数据的管理能力是企业成功的关键所在。正在基于此,所以SolidFire是较为理想的下一代数据中心存储平台,是打造下一代数据中心的利器。同样鉴于这样的背景,NetApp收购了SolidFire。

那么,什么样的客户适合用SolidFire产品?NetApp大中华区技术总监游庆洪给了一个非常有趣且精彩的回答,"SolidFire存储产品的设计是为那些不喜欢存储的用户或者说不希望花更多精力去管理存储的用户而准备的。"

据游总介绍,SolidFire具备五大特征,即,自动化管理、横向扩展、性能可靠、全局效率和数据保证。其中,在超融合的基础架构环境当中,数据中心的可扩展性是SolidFire的主要优势。

除此之外,游总还解释了SolidFire的TCO(总拥有成本)。业界都知道全闪存相比传统的机械磁盘成本高出很多,"在成本上,主要取决于客户采购和使用数据中心的方式。对于传统数据中心而言,数据中心的部署和使用主要方式仍然以一种资本支出的方式;但对于下一代数据中心的成本,我们的出发点是支持应用程序的数量,也就是说不同类型的应用程序能够在同一个环境当中得到支持,在下一代数据中心当中,经济效益考虑的出发点和传统数据中心是有很大不同的。"

小结:

NetApp SolidFire的结合,使得SolidFire能够充分利用NetApp的渠道、规模以及设计、市场资源。同时,收购SolidFire,也最终使NetApp完成了全闪存阵列产品组合的进一步完善,利用SolidFire来满足下一代全新数据中心的需求。

好文章,需要你的鼓励

让AI看图功能瘦身90%:希腊塞萨洛尼基大学发现图像修复“中奖彩票“神经网络

希腊塞萨洛尼基大学研究团队开发出MIR-L算法,通过"彩票假说"发现大型图像修复网络中的关键子网络。该算法采用迭代剪枝策略,将网络参数减少90%的同时保持甚至提升修复性能。MIR-L能同时处理去雨、去雾、降噪等多种图片问题,为资源受限设备的实时图像处理提供了高效解决方案,具有重要的实用价值和环保意义。

人工智能使用大揭秘:OpenRouter公司百万亿规模数据分析报告

这项由OpenRouter公司团队和Andreessen Horowitz(a16z)投资机构联合开展的研究,于2025年12月发表。

卡内基梅隆大学提出DistCA:让AI训练告别“木桶效应“的神奇技术

卡内基梅隆大学团队提出DistCA技术,通过分离AI模型中的注意力计算解决长文本训练负载不平衡问题。该技术将计算密集的注意力任务独立调度到专门服务器,配合乒乓执行机制隐藏通信开销,在512个GPU的大规模实验中实现35%的训练加速,为高效长文本AI模型训练提供了新方案。

NVIDIA Nemotron 3 系列开放模型: 击穿AI“工程墙”开启“Agentic AI”的“Linux时刻”

W.AWARDS金网奖2026未来商业计划领航秀峰会收官

人工智能使用大揭秘:OpenRouter公司百万亿规模数据分析报告

智能化与全球化并进,IBM中国下一个40年思考

通用汽车推出原生Apple Music应用并支持空间音频

GMV推进卫星导航技术助力自动驾驶运输与物流发展

英伟达考虑增产H200芯片满足中国市场激增需求

IBM推出开源智能体CUGA 任务完成率超五成

OpenAI支持的生物技术公司Chai Discovery获1.3亿美元B轮融资

八问智能时代:西云数据的八个答案

塑造2026年的八大智能手机趋势

AI架构师荣获《时代》杂志年度人物称号