NetApp迎接AI时代,更新旗下存储软硬件

NetApp宣布推出新的AI与网络安全硬件、软件以及合作伙伴系统与功能。

其中包括高端全闪存FAS(AFF)A系列阵列、ONTAP软件、StoargeGRID硬件、Cyber Vault不可变快照、采用新A系列阵列的AIPod、与联想合作且面向英伟达OVX系统的AIPod以及BlueXP分层功能。

NetApp高级副总裁兼企业存储总经理Sandeep Singh在一份提前准备的声明中表示,“无论是关键任务应用还是利用企业以推动AI,数据基础设施对于企业客户的意义都越来越重要。NetApp提供广泛且统一的数据存储产品组合(从本地到公有云),因此成为寻求稳健性以应对最严苛工作负载的企业客户的首选解决方案。”

Sing还提到,“全新AFF A系列系统的推出,证明我们仍坚定不移地致力于提供业界最强大、智能且安全的企业级存储产品。”

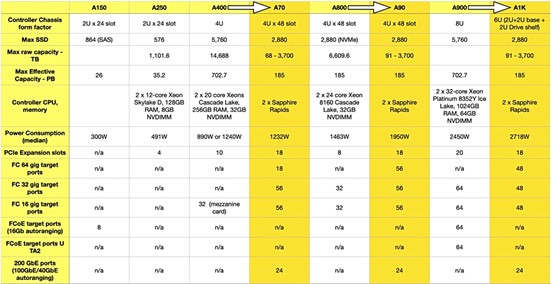

结合当前背景,当下NetApp公司的A系列阵容包括A150、A250、A400、A800以及A900;数字越大代表系统越强,其应用范围更大、控制器速度更快、容量也更为可观。

新的A系列系统的性能达到现有A系列产品的2倍,可提供4000万次IOPS与1 TBps吞吐量。这些产品可用于加速AI、数据库、EDA及VMware工作负载,同时支持块、文件及对象数据。

NetApp A系列产品,从左至右分别为A70、A1K与A90。

A系列新增三款产品:A70、A90与A1K(注意,并非A1000),用以更新家族中的中高端方案。而且这些均为新增选项,意味着真正的家族主力A400、A800与A900将继续保持市场销售。其中A70属于A400的升级版,A90是A800的升级版,现有A900则升级为A1K。A70与A90采用相同的4RU x 48驱动器插槽机箱与68 TB至3.7 PB的容量范围。

A70与A90更接近存储设备,搭载集成控制器与驱动器架;而A1K采用模块化设计,拥有独立的2RU控制器及2RU x 24插槽存储驱动器机箱。

下表所示,为新旧机型之间的对比:

新系统的重大飞跃,体现在搭载的Sapphire Rapids这、控制器处理器(第四代至强SP)上。其拥有英特尔QAT(快速辅助技术),能够为CPU分担压缩/解压及加密/解密类负载,以便在硬件当中完成这些工作又不占用CPU运算周期。

NetApp公司街道口营销副总裁Jeff Baxter在一份简报中告诉我们,“新型号将为我们的中端及高端系统注入新的能量。与同一家族中的部分高端系统相比,新产品在性能和存储效率方面均迎来显著改进。”

他解释称,新系统的性能可达原有系统的两倍。这里提到的倍增关系,代表的是A70与A400比较、A90与A800比较、A1K与A900比较。NetApp公司指出,在同样的比较双方之间,新系统的每IOPS成本降低了50%、单位吞吐量成本降低了55%,每有效TB成本降低了35%,且单元存储密度成本降低了45%。

QAT之所以“提高了存储密度”,是因为其上的重复数据删除与压缩等存储效率操作现在可以持续运行,因此有效存储容量比以往更高。新型号可保证维持4:1的存储容量效率。

Baxter还解释道,“在此前的系统中,我们采用可变压缩级别,即所谓热度敏感存储效率。我们应用到内联重复数据删除及其他因素,同时引入了一些内联压缩。而随着数据热度下降,我们会进行后期处理,对这部分数据应用额外的压缩。在新系统中,我们还凭借英特尔处理器用于分担部分操作的QAT技术,得以维持最高级别的内联压缩水平。也就是说整个系统上的所有数据都将拥有更高的压缩比率,实现了我们原有系统上无法对高热度数据实现的高压缩率。”

新系统需要配合ONTAP v9.15.1或者更高版本。

AIPod

NetApp的AIPod交钥匙产品,是将A系列阵列同英伟达DGX H100 GPU相结合并面向AI训练与推理工作,具体涵盖A70、A90与A1K。这些AIPod均基于英伟达BasePOD设计方案。

联想已经推出一款全新的“GenAI-in-a-box”一体式生成AI交钥匙系统,将AIPod同配备英伟达L40S GPU的联合服务器相结合。其根据英伟达OVX架构规范进行了验证,专门为生成式AI的微调、推理、检索增强生成(RAG)、定制化聊天机器人部署、copilot辅助以及其他生成式AI用例所构建。

但对于同样采用A系列技术的纯块ASA全闪存SAN阵列,NetApp此次没有发布任何最新公告。

好文章,需要你的鼓励

苹果2026年六大产品发布前瞻

苹果计划在2026年推出多款重磅新品,包括配备miniLED面板和A19 Pro芯片的27英寸外接显示器、搭载homeOS系统的7英寸智能家居控制设备、首次采用OLED屏幕的全新MacBook Pro、具备7.8英寸内屏的iPhone Fold折叠手机、售价699美元起的入门级MacBook,以及升级OLED显示技术的iPad mini。

新加坡国大与Lovart AI强强联手,让任何人都能一键拆解PSD文件:AI设计师的革命性工具问世

新加坡国立大学联合Lovart AI开发的OmniPSD系统,首次实现了AI驱动的双向PSD文件处理能力。该系统能够将扁平图像自动分解为可编辑的图层结构,同时支持从文字描述直接生成分层设计文件。基于扩散变换器架构和创新的RGBA-VAE技术,OmniPSD在20万真实设计样本上训练,实现了专业级的透明度处理和图层分解效果,为设计行业的数字化转型提供了强大工具。

OpenAI招聘新任安全准备主管应对AI潜在危害

OpenAI正在招聘新的安全准备主管,负责预测其AI模型的潜在危害和滥用方式,以指导公司安全策略。这一职位出现在ChatGPT因对用户心理健康影响而面临多起诉讼的背景下。CEO阿尔特曼承认模型对心理健康的影响是2025年预见的挑战之一。该职位年薪55.5万美元加股权,将领导OpenAI准备框架的技术策略。

ByteDance Seed提出端到端自动驾驶新突破:首次实现理解、生成、规划的完美融合

ByteDance Seed团队提出UniUGP统一框架,首次将自动驾驶的理解、生成、规划三大能力完美融合。通过混合专家架构和四阶段训练策略,该系统在场景理解、轨迹规划和视频生成等任务上均超越现有先进模型,为自动驾驶技术发展开辟了新路径,预示着更智能可靠的无人驾驶未来。