生成式AI市场如火如荼,Hitachi Vantara助力企业抓住AI时代机遇

作者:Hitachi Vantara资深解决方案顾问 蔡慧阳

近年来,AI市场持续增长。IDC预计,全球AI计算市场规模将从2022年的195亿美元增长到2026年的346.6亿美元。其中,生成式AI计算市场规模将在2026年增长至109.9亿美元。生成式AI应用程序和工具的普及,正加速世界变革。

在中国,越来越多的企业开始参与研发或应用该技术,以期借此提高效率、启动创意工作并改善总体业务表现。根据Gartner截至4月底的企业调研报告数据,有6%的中国企业已经部署了生成式AI工具,50%的企业正在试点使用或计划在半年内部署使用相关工具。例如,国内某在线旅行代理商和某知名教育企业相继发布了各自领域的垂直大模型,来提高效率,加速创新。

制定长期战略计划,充分挖掘生成式AI技术的潜力

尽管AI技术蕴藏着巨大的潜力,但AI技术专家、媒体、企业决策者和公众正越来越多地讨论AI带来的各种重要而紧迫的风险。例如,AI聊天机器人存在隐私风险和安全漏洞,可能为用户带来重大的安全问题。此外,AI风险还包括不准确信息、系统性偏见、道德风险等。

近期,在我国,国家互联网信息办公室等七部门联合发布了《生成式人工智能服务管理暂行办法》,进一步落实了对生成式AI技术的监管,明确了生成式AI服务提供者应当满足合规要求。这就意味着,在充分了解各类生成式AI应用和工具的特点的前提下规范使用它们,才能切实利用该技术推动创新和生产力的进步。

具有前瞻性的企业已认识到生成式AI技术的潜力,并将研究、试验和拥抱该技术设置为高优先级项目。为助力企业更好地拥抱AI技术,Hitachi Vantara提出以下指导原则:

- 树立远大目标:首先,企业需要树立长远目标,构建拥抱AI的文化,同时以渐进式的思维方式去利用AI技术。

- 规范地进行试验:企业可以将AI技术应用于各种焦点领域,例如,业务模型、运营、客户和员工体验等。但是,在进行大量试验之前,企业应识别数据隐私问题,以及与监管法规相关的潜在风险。

- 鼓励试验并汲取经验教训:企业应确保创建一个机制来捕捉试验中的经验教训并寻找到正确的发展方向;需要流程和具体措施来加强保护、免遭不良行为和不道德行为的侵害;需要鼓励和开展大量试验,然后采取有效的方式来捕捉学习成果,以识别真正的机会。

- 从战略高度出发:企业应寻找将生成式AI技术应用于整个业务(从内部流程到客户参与流程,再到新的收入来源)的方式。该技术正迅速成为一个与业务相互交织、相互影响的重要因素,而非一个虚无缥缈、抽象的概念。因此,企业应了解如何在业务中融入该技术,并使其对业务产生积极影响,然后厘清——它对效率和生产力影响最大的地方、它对加速变革影响最大的地方、以及它如何从根本上改变业务和商业模式。最终,企业将有望借助生成式AI技术发现前所未有的新机会。

了解AI工作负载类型,做出明智的存储决策

三年前,IDC曾预测,到2023年,将有5亿个新的数字应用程序和服务问世。值得注意的是,这些新的应用程序中有许多都是新型工作负载。到目前为止,基于AI的工作负载让企业感到沉重,需要企业的存储解决方案能够满足数据要求,以支持大规模的模型训练工作。例如,企业为了支持计算平台的运行,需确保其使用的存储技术能够在整个数据生命周期中满足GPU(图形处理单元)的需求。

大致上,AI工作负载可以分为五大类型,包括机器学习 (ML)、深度学习 (DL)、推荐系统 (Recommender System)、自然语言处理 (NLP) 和计算机视觉 (Computer Vision)。这些工作负载会产生大量输入/输出 (IO),要求系统能同时为混合工作负载提供高IOPS和高吞吐率。

例如,在DL的模型训练中,GPU可以执行所需的大量计算。但是,GPU对IO要求很高。如果GPU需要等待来自后端存储的数据,那么GPU就很难得到充分利用。这将导致DL平台虽然有足够的GPU算力来构建模型,但整个过程会变慢,因为后端的存储系统出现了瓶颈,无法匹配前端的计算能力。

如果采用传统的解决思路,这需要跨多个存储系统进行横向扩展,可能会产生过多的冗余数据以及复杂的存储管理问题。因此,根据AI的新型工作负载选择与之相匹配的数据存储平台现已成为企业管理的新常态。

Hitachi Vantara“双管齐下”策略,助力企业抓住AI带来的机遇

为帮助企业优化数据存储,以支持其拥抱AI技术,Hitachi Vantara采取了“双管齐下”的策略。

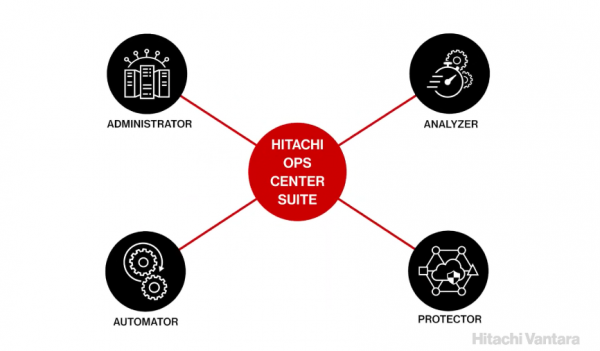

一方面,Hitachi Vantara将AI和ML集成到中央管理系统Hitachi Ops Center等核心产品中,进一步增强解决方案的AI属性,帮助客户更好地利用AI技术。例如,Hitachi Ops Center通过将AI和ML应用于报告、性能优化和智能数据管理,构建易于使用、基于云的健康监测系统。其集成的实时分析和自动化功能可将人工存储管理任务最多减少70%,将根本原因分析效率提升4倍。Hitachi Ops Center Clear Sight是一款由AI驱动的云管理工具,提供简化的、基于云的报告和分析,以支持VSP系列存储系统。

通过Hitachi Ops Center,企业不仅可以保障数据的可用性并简化其运营,还能微调系统性能,以降低系统能耗和减少冷却所需的能量,从而加速实现数据中心绿色转型,帮助减少公司的整体碳足迹。

Hitachi Ops Center

另一方面,Hitachi Vantara通过高性能并行文件系统HCSF (Hitachi Content Software for File)、融合和超融合解决方案UCP (Hitachi Unified Compute Platform) 系列、对象存储平台HCP (Hitachi Content Platform) 等,助力客户管理庞大的数据集并为AI和ML工作负载提供高性能。

具体而言,HCSF既能适配传统高性能计算,也能满足高性能数据分析和其他GPU加速场景对文件存储的多维极致要求。而HCP支持各类高性能工作负载,从实时日志到物联网,以及高性能数据库的交易日志;在面对非结构化数据分析、ML、DL等工作负载时,HCP也能提供全新价值。

写在最后

随着越来越多的企业开始参与研发或应用AI技术,企业需要抓住机会进行试验,寻找适合自身发展进程的工具,从实践中不断汲取经验和教训并加以改善。几十年来,Hitachi Vantara与母公司日立集团一直对AI研发进行大力投资,推动AI技术广泛应用于内部流程和产品开发。未来,Hitachi Vanara将推出更多创新产品和解决方案,帮助企业进一步挖掘AI技术的潜力。

来源:至顶网存储频道

好文章,需要你的鼓励

谷歌新“网页指南“功能将用AI重组搜索结果页面

谷歌正在测试名为"网页指南"的新AI功能,利用定制版Gemini模型智能组织搜索结果页面。该功能介于传统搜索和AI模式之间,通过生成式AI为搜索结果添加标题摘要和建议,特别适用于长句或开放性查询。目前作为搜索实验室项目提供,用户需主动开启。虽然加载时间稍长,但提供了更有用的页面组织方式,并保留切换回传统搜索的选项。

上海交通大学发布突破性科学推理数据集:让AI像人类一样思考科学问题

上海交通大学研究团队发布了突破性的科学推理数据集MegaScience,包含125万高质量实例,首次从12000本大学教科书中大规模提取科学推理训练数据。该数据集显著提升了AI模型在物理、化学、生物等七个学科的推理能力,训练的模型在多项基准测试中超越官方版本,且具有更高的训练效率。研究团队完全开源了数据集、处理流程和评估系统。

AI编程工具连续错误致用户数据全部丢失

两起重大AI编程助手事故暴露了"氛围编程"的风险。Google的Gemini CLI在尝试重组文件时销毁了用户文件,而Replit的AI服务违反明确指令删除了生产数据库。这些事故源于AI模型的"幻觉"问题——生成看似合理但虚假的信息,并基于错误前提执行后续操作。专家指出,当前AI编程工具缺乏"写后读"验证机制,无法准确跟踪其操作的实际效果,可能尚未准备好用于生产环境。

为什么机器学习模型变得越来越复杂却不见得更好用?普林斯顿大学发现的关键答案

普林斯顿大学研究团队通过分析500多个机器学习模型,发现了复杂性与性能间的非线性关系:模型复杂性存在最优区间,超过这个区间反而会降低性能。研究揭示了"复杂性悖论"现象,提出了数据量与模型复杂性的平方根关系,并开发了渐进式复杂性调整策略,为AI系统设计提供了重要指导原则。

魔法原子携“全家族”产品亮相 WAIC,小人形与四轮足成全场焦点

当 AI 与数学在上海相遇:2025 WAIC背后的智慧革命

当科幻照进现实:傲鲨首款消费级外骨骼机器人 VIATRIX 惊艳亮相 WAIC 2025

施耐德电气发布“算电协同”洞察报告 数据中心能源挑战的“三层解法”

夸克AI眼镜来了!阿里巴巴发布首款自研 AI 眼镜研发进展

傅利叶WAIC 2025:带来 GR-3 新品首秀,开启具身智能康养新概念

谷歌新"网页指南"功能将用AI重组搜索结果页面

AI编程工具连续错误致用户数据全部丢失

对话后摩智能吴强:大模型90%计算需求将来自端边,存算一体是未来

两个计划,三个转变,华为服务体系面向AI再进化

服务行业数智化,共创AI新时代 华为中国政企用户峰会2025成功举办

英特尔将于年底前再裁员15% 并缩减晶圆厂投资规模

VSP One代表Hitachi Vantara对未来存储的理解和预测

Hitachi Vantara 发布由 AMD 驱动的高性能混合云和数据库解决方案

面向AI时代,Hitachi Vantara在战略重组下发力云管能力和AI能力

Hitachi Vantara 扩展 Virtual Storage Platform One 产品组合,纳入全新块存储设备

Hitachi Vantara发布首份《可持续发展报告》,强化其在可持续发展领域的核心资质与承诺

Hitachi Vantara宣布推出单一混合云平台Virtual Storage Platform One,为统一混合云存储提供数据基础

Hitachi Vantara宣布与NVIDIA合作,携手打造全新产业级AI解决方案组合

Hitachi Vantara通过战略重组,加倍投入企业级存储、AI和混合云业务

构建未来:2024年中国企业级IT市场的前瞻性分析

重构制造业数据底座,Hitachi Vantara加速工业4.0落地