普通硬盘可能比闪存驱动器更环保

研究机构Futurum最近支持发表的一篇研究论文认为,普通硬盘可能比闪存驱动器更加环保。这篇论文指出,最主要的碳排放实际发生在设备制造期间,而闪存驱动器的碳排放实际比普通硬盘更多。

在这份题为《SSD真比HDD更具可持续性吗?》(https://futurumgroup.com/insights/are-ssds-really-more-sustainable-than-hdds/)的研究报告中,Futurum分析师Mitch Lewis宣称,“SSD中所使用闪存设备的制造过程涉及能源高度密集的工艺。与具有相同容量的硬盘驱动器(HDD)相比,闪存驱动器的能源成本高出约8倍。”

他还引用了最近在HotCarbon 2022大会上发表的一项研究,题为《SSD的肮脏秘密:本体碳成本》(https://www.youtube.com/watch?v=-0tzoSEL8iA)。这项研究由威斯康星大学麦迪逊分校计算机科学教授Swamit Tannu和加拿大不列颠哥伦比亚大学计算机科学助理教授Prashant J Nair共同完成。

该研究声称,“制造1 GB闪存须排放0.16千克二氧化碳,这已经在系统的总碳排放中占据很大一部分……闪存与DRAM制造中心使用的也大多不是可再生电力,其旺盛的能源需求往往只能用碳密集型的发电形式予以满足。”也就是说,这0.16千克二氧化碳就是SSD的本体碳成本。

尽管物体体积更大,但“与SSD相比,HDD的本体碳成本至少要低一个数量级。”这是因为HDD制造流程中的半导体密集度远低于SSD,而且消耗的电力也比半导体制造更低。此外,“大多数半导体制造厂使用的电力来自燃烧和燃气发电厂”,而非可再生能源。

对SSD与HDD环保程度的判决当然不仅限于制造耗电量,“还必须考虑到存储架构中的具体碳成本。”

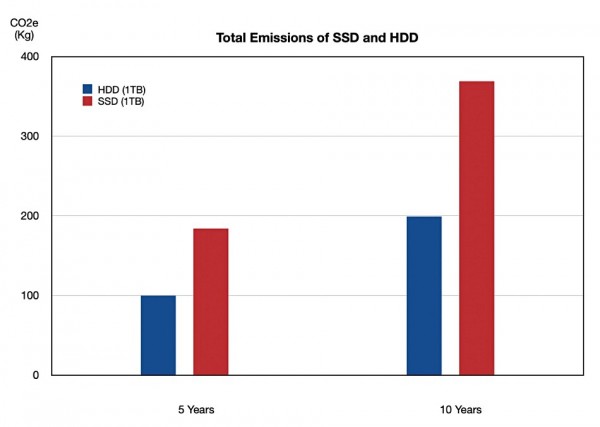

该研究评估并比较了HDD与SSD的全生命周期碳排放量(按5年和10年两种使用周期计算),具体如下表所示:

其中的CO2e即为总体碳排放成本(单位为千克)。我们绘制了HDD和SSD的全生命周期排放数据(最右侧两列),下图为可视化转换后的形式:

根据这项研究,HDD在制造和使用寿命期间对应的总碳排放也比SSD更少,因此对于自然环境更为友好。

另外需要注意的是:

- 研究中假设HDD平均功耗为4.2瓦,SSD平均功耗为1.3瓦。

- 全运行寿命(OPEX)CO2e数字使用美国EPA规定的总能源消耗排放因子——按照2019年的数据,为0.7千克/千瓦时。

- 这里的CAPEX,指制造过程中的本体碳成本。

- 10年计算周期中包含升级资本支出部分,因为研究假设SSD和HDD的使用寿命均为5年。

Lewis写道,“人们普遍认为SSD的可持续性比HDD更好,因为其无需依赖机械活动部件、所以能效更高。这种能效论点在供应商营销中被大量使用,特别是那些销售全闪存存储系统的供应商。”

但本次研究改变了这一切。“这是个相当令人惊讶的结果。绝大多数供应商宣称SSD比HDD更具可持续性,但从此次报告来看事实似乎并非如此。”

Lewis表示,作者可能没有考虑到“HDD和SSD的技术更新周期已经分开……HDD的更新周期通常为4到5年……但(提供较长保修期的供应商)已经帮助IT部门将设备的使用周期延长到了10年。”

按照这个假设来计算,那么SSD使用10年的碳成本为209.2千克(CO2e)。这个数字与HDD的水平更加趋近,但仍比HDD要高。

由于SSD的容量(存储密度)增速比HDD更快,“这种密度差异可能驱使IT部门更多选择SSD以节约物理占用空间,由此带来的碳排放贡献将弥补HDD与SSD之间的排放量差异。”

“尽管如此,SSD与HDD在可持续性方面的区别,确实比很多闪存存储供应商宣传中得经近似得多。”但在未来,“以密度更高的设备显著削减物理空间占用量,应该有助于改善数据中心的总碳排放量。”也就是说,SSD应该会表现出一定的可持续性优势。

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。

稚晖君发布全球最小全身力控人形机器人,上纬启元开启个人机器人时代

2026年软件定价大洗牌:IT领导者必须知道的关键变化

Linux 在 2026 年将势不可挡,但一个开源传奇可能难以为继

CES 2026趋势展望:全球最大科技展五大热门话题预测

人工智能时代为何编程技能比以往更重要

AI颠覆云优先战略:混合计算成为唯一出路

谷歌发布JAX-Privacy 1.0:大规模差分隐私机器学习工具库

谷歌量子AI发布新型优化算法DQI:量子计算优化领域的重大突破

缓解电动汽车里程焦虑:简单AI模型如何预测充电桩可用性

Titans + MIRAS:让AI拥有长期记忆能力

Gemini为STOC 2026大会理论计算机科学家提供自动化反馈

夸克AI眼镜持续升级:首次OTA,支持89种语言翻译