IBM 又出黑科技,使 AI 极简高效

新时代企业需要敏捷性、多样性和可扩展性来确保竞争力

根据麦肯锡咨询,超过 70% 的顶级CEO表示,提升企业整体敏捷性、缩短上市时间有助于提升其市场竞争力,而这些也是他们的当务之急。

当下,企业希望比自己的同业更加敏捷,同样也希望通过AI技术获得更好的洞察力。我们聆听到三种客户心声:

- 希望应用和数据能够根据市场需求动态进行调整和变化

- 希望能够随处构建多样化工具和数据,能够更好地获得洞察力

- 希望应用和数据能够动态地扩展,实现最高性能,同时保持安全合规

企业需要具备使其能够在任何地方开展工作的敏捷性:这意味着能够使用支持不同开发工具的云环境,能够进行动态扩展来满足客户需求,同时能够更精细地控制成本。容器应用开发平台可为企业提供在新时代确保竞争力和成功所需的全部敏捷性、多样性和可扩展性。

企业对于数据的关注点已经从容器转变到应用

然而,面向容器化和混合云的转型并非易事。Gartner《2020 年影响基础架构和运维的十大趋势》报告显示:安全、混合云和容器是完成数据转型的基础。58% 的企业认为网络安全保护是一个非常重要的优先事项,50% 的企业用户是在数据中心或者是在云端之外创建和处理的,71% 以上的企业认为需要一致的方式,在本地基础架构和公有云中来部署云原生应用,50% 企业已经部署了容器。

今天,容器应用更加注重数据,有超过一半的企业认为基于容器构建的有状态应用,容器的持久数据保护已经变得非常普遍。企业对于数据的关注点已经从容器技术的本身转变到了对应用的关注。5年前,企业更关注的是支持容器的存储,即如何利用已经投资在数据中心的块存储、对象存储或者文件存储来支持容器化的应用。从2018年至今,越来越多的企业关注的是容器原生存储的技术,即能否够通过统一的容器管理和调度平台来进行存储的管理。随着时间的推移,越来越多的企业在思考,面向存储的服务,应用如何可以更好地去感知,而不是每次都需要进行大量的调度,调用运维管理人员来管理存储服务。

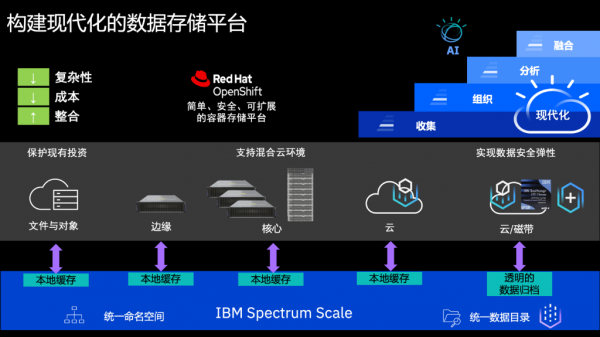

企业在构建一个混合云和人工智能的数据基础的时候,无论来自于边缘、核心的数据中心,还是混合的云端,都需要专门为人工智能优化而且为各种各样的应用提供一个单一的数据存储库。

构建面向应用(而非容器)的基础架构,包括必要的存储底层,例如不可变性与加密、同步多协议访问、高性能存储缓存、归档到磁带/云以及数据优化等。在此基础上,还需要针对 HA/DR、数据保护、容量和性能管理、发现和编排、安全和迁移,优化面向混合云的存储服务。企业需要构建一个坚实的数据基础,打通存储底层、存储服务和应用运行的管理。

容器原生的 IBM Spectrum Fusion 应运而生

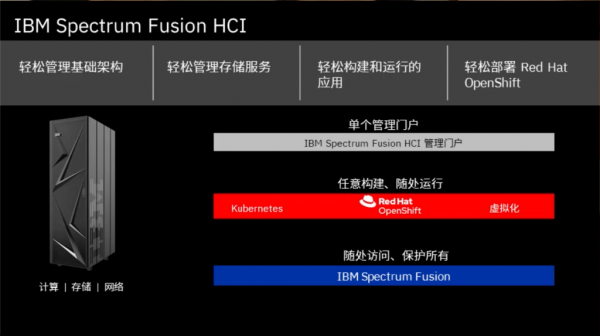

IBM Spectrum Fusion是业界第一个面向 OpenShift 混合云容器的原生数据平台,计划于 2021 年下半年上市,其第一个版本采用超融合基础架构 (HCI) ,将计算、存储和网络整合为单一解决方案。配备 Red Hat OpenShift,使企业能够支持虚拟机和容器环境,并为云端、边缘和容器化数据中心提供软件定义存储。

该平台专为需要全局混合云数据访问和企业存储服务的企业而设计,满足任务关键数据的严苛要求,其功能包括:

- 全局数据访问:创建混合云灵活性,同时通过从核心到边缘再到公有云的流畅数据和全局访问消除数据孤岛。

- OpenShift 基础,企业级全局数据服务:通过单个 YB 级可扩展的数据基础来保护和优化您的数据。

- 简化 OpenShift 部署:综合性的计算、网络和软件定义存储平台,提供集成的管理界面和监控工具。

Spectrum Fusion提供单一的管理门户,从而简化管理。企业可以任意构建,随处运行容器化的应用和服务,同时随时随地访问、保护数据。该平台面向应用和人工智能,企业可以轻松管理基础架构(存储、计算、网络),轻松管理存储的服务、轻松构建和运行应用、轻松部署 Red Hat OpenShift 容器平台,快速敏捷地完成一系列的工作,我们称之为“交钥匙”工程。

软硬一体,专为高性能 AI 和混合云打造的下一代存储

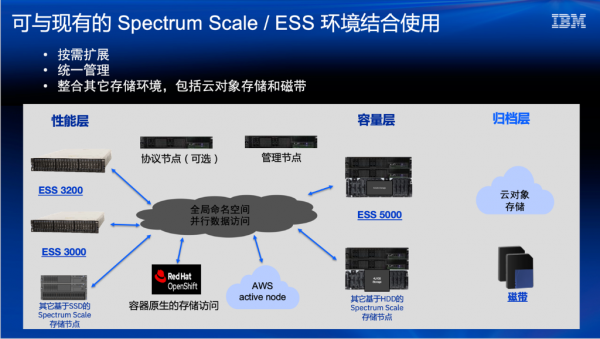

IBM Elastic Storage Ssystem (ESS) 是一款以现代化方式实施的软件定义存储,它结合了IBM Spectrum Scale 软件,基于 IBM POWER 处理器的I/O 密集型服务器以及强大的双端口存储机柜。IBM Spectrum Scale并行文件系统是 IBM ESS的核心,可随需扩展系统吞吐量,同时提供单个命名空间,有助于消除数据孤岛、简化存储管理并提供高性能。新发布的 ESS 3200 堪比 AI 时代的数据加速器:

- 业界领先的数据访问性能 - 两倍于上一代 ESS 3000

- 单个模块高达 80GB/s

- 无论是边缘、数据中心还是云端,可线性扩展到 TB/s 级的性能和 YB 级的容量

从外观上来看,ESS 3200和上一代的 ESS 3000几乎是相同的,同样在一个 2U的空间里面,可支持最多 8 个 InfiniBand HDR-200 或 Ethernet-100 端口,实现了高吞吐量和低延迟;可以为每个 2U 节点提供最多 367TB 的存储容量,支持12-24个NVMe的高速存储模块,同时提供了两个Active的双控制器。和上一代的3000相比,3200的最大的一个改进就是都全面了支持了 PCIe 4.0,无论是控制器里面的芯片,还是外部的存储模块。

此外,IBM ESS 5000 也做了更新,支持的密度比之前高出了 10%,总存储容量达到 15.2PB。所有 ESS 系统现在还具备了简化的容器化部署功能,并借助最新版本的 Red Hat Ansible 实现了自动化。

升级到 ESS 3200可以保护您的现有投资,帮助您构成一个统一的、整合的数据湖。您可以在单个命名空间中整合 ESS 3000、3200、5000 及IBM Spectrum Scale SDS 节点,全局可访问容量高达 8YB!

Spectrum Scale/COS 增强功能不容错过

伴随着 ESS 3200新品发布,我们还发布了 Spectrum Scale 5.1.1 GPUDirect 存储技术预览,让 NVIDIA 开发者能够实现 GPU 内存与存储之间的直接内存访问 (DMA),同时减少延迟并增加带宽。

Spectrum Scale 在过去数年当中,一直和 NVIDIA 有着非常紧密的合作,无论是基于NVIDIA提供的GPU卡,还是它的 Work Station、DGX 的服务器平台、SuperPOD 集群的平台,IBM Spectrum Scale都有非常完善的参考架构。

目前全球的最大的基于NVIDIA的GPU的系统,曾经位列世界第一和第二的超级计算机 Summit和Sierra,都采用了ESS作为数据存储平台。在2018、2019年NIVIDIA推出的每一套的SuperPOD的后面支持的存储也用到基于 SSD 的 ESS。

此外,针对云对象存储 Cloud Object Storage 的用户,还发布了一个新的适用于所有的机柜的存储模块型号 —— Slicestor 92,可帮助客户实现相当于之前 4 倍的密度,无需额外的空间来部署超深机架。这有助于客户降低运营开支,满足不同物理数据中心条件的用户来实现一个更高容量、更高存储密度的一个扩展。

结合新发布的ESS 3200、ESS 5000 或者对象存储的新功能,用户可以把现有的一些投资:不同地点、不同架构、不同类型的存储,通过 Spectrum Scale按照应用的需求组合成一个现代化的数据存储平台,满足数据在收集、组织、分析等阶段所需的访问便捷性、容量、性能、单位容量成本等需求。通过和 Red Hat OpenShift 集成,所有这些能力都可以同时运行在数据中心,也可以运行在混合云环境,从而帮助用户真正降低复杂性、降低成本,同时通过提升整合度,提升数据使用效率,获得更高的数据价值。

简化数据管理,提升存储价值,加速 AI研发

地平线,一家AI 领域的独角兽公司,在AI模型训练中所累积的数据量超过数十PB,且每年以若干PB的增量继续高速增长,这些数据分散在多中心、多云环境里。起初,地平线使用基于开源GlusterFS、Ceph、以及HDFS所构建的数据基础架构,面临着竖井林立,存取性能下降,数据调度困难,管理复杂、数据存放成本高等难题,因此亟需改造和升级,以满足业务发展。

基于IBM Spectrum Scale,地平线构建了高性能海量数据分布式存储架构,统一数据平台,消除竖井,更好地利用资源,让业务迭代更加快速。具体而言:

第一,统一数据平台,提升开发效率。利用Spectrum Scale 在多云之间形成统一的全局命名空间,将不同数据访问接口的数据方便地接入进来统一管理,消除竖井,实现高效开发迭代和系统管理。

第二,数据随需调度,快速响应需求。Spectrum Scale 让数据得以统一调度,数据可以自动透明地在多云间自由流动,大大节省了人工成本、降低了误操作的风险,访问速度达到毫秒级,加速训练任务日程。

第三,运维自动完成,提升数据安全。Spectrum Scale 自带管理功能,提供简单易用的图形界面、操作简便,原有的很多需要人工干预的操作变为自动完成,在降低管理难度的同时,提升了数据安全性。

最后,数据自动分层,降低存储成本。依托Spectrum Scale 统一管理磁盘和磁带,实现多样的扩容方式和数据自动分层,把冷数据如访问量不高的大文件自动地归档到磁带系统中,形成低成本的长期存储池,且磁带数据实时随机读取,冷数据存储降低了大约 80% 的成本,同时满足合规需求。

“依托于Spectrum Scale 统一管理磁盘和磁带,透明地把数据从磁盘迁移到磁带,也可以从磁带回迁回来,这一过程完全不需要我们干预,也无需应用进行任何访问方式的改变。一方面,通过灵活的冷热分层策略,地平线每年可以节省数千万的存储成本;另一方面,高效的分布式数据存储管理,也使得上层的数据管理中台与前台业务无需关心存储本身,而更加专注于业务系统的研发与优化。” 地平线的 VP水冰先生说道。

值得一提的是,基于Spectrum Scale存储,地平线利用端侧软件产品的优势,开发了一套高效、规模化、安全可控的数据驱动闭环迭代系统,打通了端云链路,赋能合作伙伴实现从数据筛选、采集标注、模型训练优化、仿真评测,到模型OTA部署,端到端的数据迭代闭环,帮助合作伙伴充分挖掘利用数据价值,实现智能驾驶软件自动化迭代,加速产品用户体验的提升。

获取更多相关资料请访问>>> IBM IT基础架构专区

来源:至顶网存储频道

好文章,需要你的鼓励

让AI记住房间每个角落:悉尼大学团队如何让视频生成拥有“空间记忆“

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

西班牙病毒如何将谷歌带到马拉加

33年后,贝尔纳多·金特罗决定寻找改变他人生的那个人——创造马拉加病毒的匿名程序员。这个相对无害的病毒激发了金特罗对网络安全的热情,促使他创立了VirusTotal公司,该公司于2012年被谷歌收购。这次收购将谷歌的欧洲网络安全中心带到了马拉加,使这座西班牙城市转变为科技中心。通过深入研究病毒代码和媒体寻人,金特罗最终发现病毒创造者是已故的安东尼奥·恩里克·阿斯托尔加。

马里兰大学突破性发现:AI推理过程终于有了“身体检查“——ThinkARM框架揭开大型语言模型思维奥秘

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。

工业和信息化部人形机器人与具身智能标准化技术委员会成立大会暨第一次全体委员会议召开

生命科学计算测试专委会正式成立,BioProfile框架引领行业标准建设

超智算完成北京核心智算中心资产收购,加速构筑“3+X”全国算力网络新格局

走出“参数崇拜”:联想用“一体多端”重塑“人的尺度”

从“单点突破”到“一体多端”:拆解天禧AI 3.5进化背后三年的进化哲学

openGauss Summit 2025在京召开,加速行业智能化变革,共建繁荣数据库生态

2025联想天禧AI生态伙伴大会:天禧AI一体多端,与开发者共建个人AI生态

西班牙病毒如何将谷歌带到马拉加

LangChain核心库曝出严重漏洞,AI智能体机密信息面临泄露风险

Mill如何与亚马逊和全食超市达成合作协议

TechCrunch创业大赛中的9家顶尖生物技术初创公司

2025年印度科技领域十大重要发展

从多站点到多活,XEOS 对象数据容灾能力再提升

XSKY SDS 6.4 重磅更新:NFS 性能飙升 3 倍,对象多站点等 10 多项功能强势升级

XSKY星辰天合 SDS V6.3 版本发布:持续强化非结构化存储和管理能力

IBM宣布对数据存储产品重大改革 合并Red Hat OpenShift和IBM Ceph

冲刺中国超融合市场第一 浪潮的底气和实力

SDS也能实现高端存储性能指标,华瑞指数云重磅发布下一代软件定义存储产品

分布式+闪存成为新热点,TaoCloud宣布新一轮亿元级融资

深度解读十四五软件规划中的“软件定义”和SDS

Nutanix投资者日主题:除了HCI,我们还有更大的野心

IBM 又出黑科技,使 AI 极简高效