2018年,五大热门关键词领跑存储市场 原创

年末将至,各大行业市场逐步进行盘点期。对于企业级存储行业来说,2017年是充满神奇色彩的一年,也是丰收的一年。这一年,业内知名企业东芝出售旗下芯片业务、西部数据收购初创公司Tegile、Dell EMC大力投入全闪存存储、HPE收购超融合厂商SimpliVity、NetApp推出基于SolidFire的超融合系统……一系列事件着实让存储圈热门一番。

展望2018年,企业产生的数据趋势并没有放缓迹象,大数据、物联网和分析市场的崛起持续促使数据继续增长,而这一激增也推动了其底层基础设施的发展。

事实上,数据存储技术的快速增长也是IT基础设施变革的最大因素,根据Interop ITX和InformationWeek 2018基础设施的研究证明,有50%的受访者认为如今企业对数据存储的需求已经远远超过了整合云服务的需求。

ESG高级分析师Scott Sinclair在接受采访时表示,目前数据已接近临界点,随着我们进一步步入数据经济,在未来一年中,企业为了实现数据战略目标,将在数据中心投资更多存储硬件,在云中存储更多数据,并继续研究新兴存储技术。而在2018年,有五大热门关键词将继续领跑企业级存储市场。

全闪存

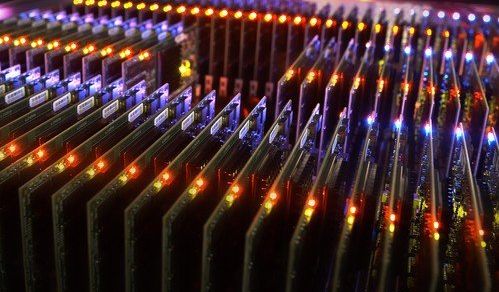

近几年,存储介质突飞猛进,高速、容量、性能也在快速提升,全闪存作为最热门的存储介质之一,在数据爆炸增长的今天变得尤为重要,同时也为存储架构和存储协议的发展带来了全新变革。

其实全闪存也并不是什么新出现的技术,业内戴尔EMC、IBM、NetApp、华为等厂商一直在做,只是之前因为成本的原因限制了全闪存的普及。随着全闪存技术的不断提升和价格的逐渐走低,这个市场有望进入快速增长期。据悉,在未来一年中,各大厂商会继续发力全闪存市场,在性能、IOPS等技术上继续优化,为用户提供更强大、更简单的解决方案,以加速数字化转型。

超融合

超融合(Hyper Converge Infrastructure,HCI)是近几来IT界广受关注的话题之一,也成为众多厂商主要发力的方向,市场竞争尤为激烈。据Interop ITX的研究证明,有65%的受访者表示他们正在使用、计划使用或寻求超融合基础设施,而20%表示他们并不感兴趣。

纵观如今的超融合市场,最早推广这个概念的是Nutanix,起步的核心技术是分布式存储,只是在部署架构上融入了创新元素,采用融合的形式,这种形式也进一步推动了分布式存储的市场落地。目前中国的超融合市场玩家众多,除了戴尔、EMC、华为、联想、Nutanix这些一线国际大厂之外,还有浪潮、曙光以及众多初创企业。不过,市场目前还是属于初期阶段,竞争还是比较激烈的。

软件定义存储

随着软件定义数据中心、软件定义网络、软件定义存储纷纷推出市场,"软件定义"技术已全面爆发。据IDC预测,2017年至2021年,全球软件定义存储市场年复合增长率将达到13.5%,2021年营收达到约162亿美元。

软件定义存储,顾名思义主要是通过借助软件实现虚拟化,配置和重复数据删除等功能,并通过自动化对存储网络加速,其主要意义是实现用户可扩展性和灵活性。

Hadoop/Spark

自大数据兴起以来,更强的计算机及更成熟的大数据平台工具使企业掌握挖掘数据价值的技巧。目前国内已经广泛应用于制造、金融、电信、医疗以及能源领域,这些领域每天都有数以亿计的数据产生,对于大数据资产的存储、挖掘、分析等流程都有一定的要求。

Hadoop是由Doug Cutting于2005年发起的项目,采用开源软件框架对超大数据集进行分布式存储技术及分布式处理。换句话说,设计这一产品的目的在于缩减处理大数据集的时间及成本。Spark是近年来新兴的一个分布式大数据处理引擎,采用了类Hadoop MapReduce的通用的并行计算框架,而不同于MapReduce的是输出和结果可以保存在内存中,性能更好,因此能更好地适用于数据挖掘与机器学习等应用,一度被认为有望取代Hadoop。其实,这两者协作要大于竞争。

云存储

随着信息技术的飞速发展,云技术日趋成熟,通过云技术将信息资源进行存储共享被越来越多现代企业广泛应用,包括备份和恢复、归档等。

追其根源,其实是Dropbox公司首席执行官Drew Houston在2007年在忘记带USB存储设备且不知道放在哪里的时候,当时萌生了创建个人和小型企业云存储的想法,而如今,几乎每个人都寻求到了属于自己的云存储产品。

好文章,需要你的鼓励

人工智能落地“最后一公里”,戴尔工作站助力AI应用提速

英特尔携手戴尔以及零克云,通过打造“工作站-AI PC-云端”的协同生态,大幅缩短AI部署流程,助力企业快速实现从想法验证到规模化落地。

意大利ISTI研究院推出Patch-ioner:一个神奇的零样本图像描述框架,让电脑像人一样描述任何图像区域

意大利ISTI研究院推出Patch-ioner零样本图像描述框架,突破传统局限实现任意区域精确描述。系统将图像拆分为小块,通过智能组合生成从单块到整图的统一描述,无需区域标注数据。创新引入轨迹描述任务,用户可用鼠标画线获得对应区域描述。在四大评测任务中全面超越现有方法,为人机交互开辟新模式。

阿联酋MBZUAI发布PAN世界模型,AI仿真技术迎来突破

阿联酋阿布扎比人工智能大学发布全新PAN世界模型,超越传统大语言模型局限。该模型具备通用性、交互性和长期一致性,能深度理解几何和物理规律,通过"物理推理"学习真实世界材料行为。PAN采用生成潜在预测架构,可模拟数千个因果一致步骤,支持分支操作模拟多种可能未来。预计12月初公开发布,有望为机器人、自动驾驶等领域提供低成本合成数据生成。

MIT团队重磅发现:不配对的多模态数据也能让AI变得更聪明

MIT研究团队发现,AI系统无需严格配对的多模态数据也能显著提升性能。他们开发的UML框架通过参数共享让AI从图像、文本、音频等不同类型数据中学习,即使这些数据间没有直接对应关系。实验显示这种方法在图像分类、音频识别等任务上都超越了单模态系统,并能自发发展出跨模态理解能力,为未来AI应用开辟了新路径。

人工智能落地“最后一公里”,戴尔工作站助力AI应用提速

《2025 中国企业级 AI 实践调研分析年度报告》:深度剖析与价值洞察

Gartner:在中国构建AI软件工程技能的三大举措

阿联酋MBZUAI发布PAN世界模型,AI仿真技术迎来突破

Nvidia和Google支持的AI代码编辑器Cursor获23亿美元融资

Anthropic披露首例Claude模型参与的AI网络间谍活动

Cadence首款系统芯粒架构成功流片,助力物理AI发展加速

百度发布定制AI加速器响应国产芯片需求

VasEdge试用火热招募,降本增效机遇来袭

Infinidat InfiniBox G4系列升级重塑高端企业存储格局

Avalonia为微软MAUI跨平台应用方案带来Linux和浏览器支持

谷歌DeepMind发布SIMA 2智能体:游戏世界中学习迈向AGI之路