浪潮云海大数据平台产品能力评测斩获佳绩 原创

近日,在工信部指导下的数据中心联盟公布的2017大数据产品评测结果中,浪潮云海Insight大数据平台以优异的成绩通过了基础能力测试和性能测试两部分评测,其中三项性能指标排名第一。

大数据产品能力评测由工信部指导下的数据中心联盟组织,并委托中国信息通信研究院实施测试,是国内起步最早、覆盖最广、技术水平最高、影响最大的大数据评测体系,圈定了国内大数据基础平台厂商第一梯队,成为政府和行业用户评价和选购大数据产品的权威参考。

在此次基础能力测试中,云海Insight大数据平台满足全部32个必测项和12个可选项的测试要求,涵盖了Hadoop和Spark生态体系中的绝大部分组件和功能;

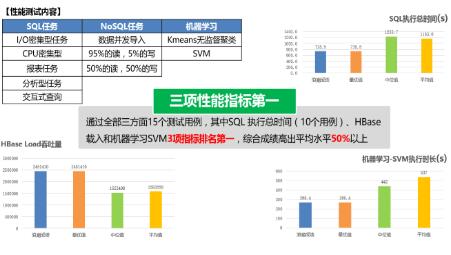

在性能测试中,云海Insight大数据平台通过全部15个测试用例指标验证,其中SQL执行总时间(10个用例)、HBase载入、机器学习SVM算法三项性能指标排名第一。

此次评测标准升级到了2.0版本,测试难度加大,基础能力测试用例达到44项;性能测试SQL负载测试数据规模从10TB扩展到30TB,NoSQL测试数据规模达到20亿条,机器学习最大负载数据规模达到1TB。

云海Insight打造全栈式企业级大数据平台

云海Insight大数据平台是浪潮着力打造的一款企业级大数据平台产品,包含Hadoop和Spark生态中的20多个主要技术组件,研发过程中始终秉承开放共享的技术发展策略,遵循国际开源技术标准。同时,云海Insight从客户业务的需求出发,着力于产品功能的完备性、运维的便捷性、系统的安全性、集群的扩展性、操作的易用性和性能的高效性,为政企客户打造成熟稳定的企业级规模化大数据平台。

目前,云海Insight实现了一站式管理运维,运维效率提升30%;提供统一的数据操作控制台,实现了可视化数据操作、全栈式任务管理和图形化流程编排,开发效率提升20%;SQL兼容性99%,全部通过TPC-DS标准SQL测试;各项性能指标持续提升,多次在第三方评测和客户测试中拔得头筹;提供向导式、高性能的机器学习工具,内置丰富算法模型,大大降低行业客户在机器学习领域的技术门槛;实现基于认证、授权、加密、审计四位一体的安全策略,保障数据资源和计算资源的安全隔离和灵活共享。

多年来,浪潮面向行业为客户提供云计算和大数据整体解决方案,积淀了丰富的经验。凭借成熟的大数据技术平台和扎实的行业实战能力,浪潮云海大数据平台成功在政府、电信、金融、公安、气象、卫生、教育等行业实现落地,运用大数据技术为客户提供业务价值。

加大技术投入,浪潮大数据竞争力持续提升

浪潮积极融入并回馈国际开源社区,多位技术人员在Apache社区的Spark、Kudu、Hue、HBase等多个项目中成为了代码贡献者。凭借领先的大数据发展理念和"技术-专利-标准"梯次攀登的创新战略,2016年浪潮申请云计算、大数据专利450项,居国内首位,在《2017中国大数据发展报告》中被评为技术创新度唯一满分的企业。

2017年,浪潮大数据竞争能力持续提升。今年3月,在由国家信息中心、南海大数据应用研究院发布的《2017中国大数据发展报告》中,浪潮被评为十大最具影响力大数据企业前三甲;同月,在2017中国IT市场年会中,浪潮获得"2016-2017中国大数据市场综合实力第一"殊荣;7月,浪潮正式加入Apache国际开源社区,以支持更多的浪潮大数据技术人员成为社区开源项目的贡献者。

2017年,中国唯一"大数据流通与交易技术国家工程实验室" 落户浪潮,围绕数据流通进行大数据相关体系建设、标准统一、核心技术研发和生态构建;浪潮宣布参建国家首个"教育大数据应用技术国家工程实验室",致力建设国内领先、国际一流的教育大数据理论研究、工程化实验、教育管理服务和专门人才培养一体化平台。

同时,依托大数据技术和产品,浪潮天元大数据平台积累了50PB高价值的互联网数据,具备20000+采集节点、500TB的日处理能力;成功助力全国27个省市政府建立大数据平台,实现了数据的共享共用,为众多政府、企业用户提供专业的大数据服务。

"进入大数据时代,稳扎稳打的技术实力和行业根基将让浪潮领先半步。通过联合上下游合作伙伴,浪潮致力于构建开放融合的大数据生态,为客户提供云计算大数据整体解决方案。" 浪潮集团副总裁张晖表示。未来,浪潮将继续通过更具竞争力的大数据产品、丰厚的行业沉淀,助力更多客户在云计算大数据时代下转型升级。

好文章,需要你的鼓励

谷歌深度思维团队如何让机器学会像生物学家一样发现新药物

谷歌深度思维团队开发出名为MolGen的AI系统,能够像经验丰富的化学家一样自主设计全新药物分子。该系统通过学习1000万种化合物数据,在阿尔茨海默病等疾病的药物设计中表现出色,实际合成测试成功率达90%,远超传统方法。这项技术有望将药物研发周期从10-15年缩短至5-8年,成本降低一半,为患者更快获得新药治疗带来希望。

Google力推手机AI功能引发关注

继苹果和其他厂商之后,Google正在加大力度推广其在智能手机上的人工智能功能。该公司试图通过展示AI在移动设备上的实用性和创新性来吸引消费者关注,希望说服用户相信手机AI功能的价值。Google面临的挑战是如何让消费者真正体验到AI带来的便利,并将这些技术优势转化为市场竞争力。

哈佛和微软联手打造AI“预言家“:仅凭声音就能预测健康状况,准确率竟达92%

哈佛医学院和微软公司合作开发了一个能够"听声识病"的AI系统,仅通过分析语音就能预测健康状况,准确率高达92%。该系统基于深度学习技术,能够捕捉声音中与疾病相关的微妙变化,并具备跨语言诊断能力。研究团队已开发出智能手机应用原型,用户只需完成简单语音任务即可获得健康评估,为个性化健康管理开辟了新途径。

“4个9”韧性的背后,西云数据以技术与运营加速企业数字化创新

Google力推手机AI功能引发关注

Meta发布AI翻译功能,支持脸书和Instagram内容实时转换

HPE发布Nvidia Blackwell驱动的AI服务器,抢占AI市场需求

ISACA推出AI安全管理高级认证项目

谷歌推出智能体SOC系统提升安全事件响应速度

Lumen升级400GB数据中心连接基础设施助力AI发展

AI和流媒体推动,2030年面临"网络危机"

Pine64停产Pro手机转向RISC-V业务

日立Vantara将VSP One块存储扩展至Azure云平台

Finchetto光学数据包交换机:光无法存储的技术挑战与突破

Python开发者调查显示增长强劲,但基金会资金面临困境