智能虚拟化,让浪潮智能存储G2实现数据透明流动 原创

企业纷纷启动数字化转型,"数据智能化"已经成为企业的常态需求。这一趋势下,浪潮推出了智能存储G2平台,从介质层、设备层、协议层和应用层进行了大量技术创新,实现了智能的感知、智能的技术架构、智能的适配调度,助力企业构建智能IT基础设施。

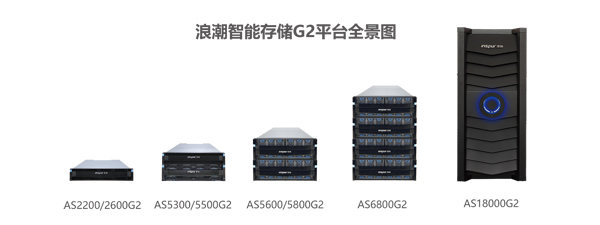

浪潮智能存储G2平台

浪潮G2在存储虚拟化上的"三板斧"

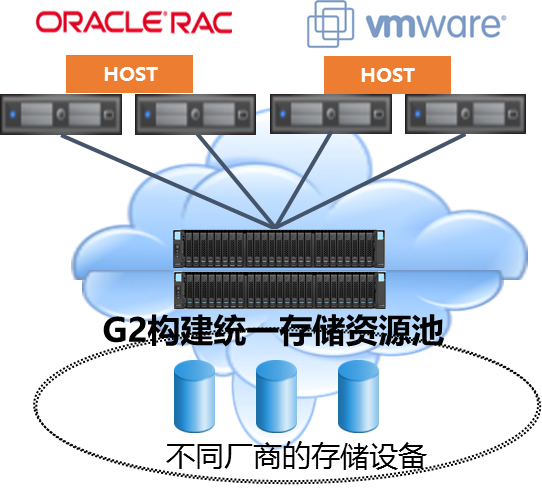

在数据出现爆炸式增长、数据中心存储环境越来越复杂的今天,存储虚拟化功能可以帮助企业实现异构环境的整合,消除不用类型存储资源之间的差异,并能够减轻IT管理者的管理成本。浪潮G2的存储虚拟化技术并不是简单停留在建立统一虚拟化资源池上,而是具备了独具优势的"三板斧":

第一板斧:逻辑上统一管理,物理上自由布局

浪潮智能存储G2平台的虚拟化技术可将数据存放的物理位置与逻辑管理权限分离,带来的好处显而易见。"浪潮存储产品部产品经理杨涛表示:"存储设备可保持原来在机房的布局不变,安装在配电、通风、机架空间等因素比较合适的地方,甚至根据业务需求可以跨房间、跨楼层部署;但在管理方面,管理员只需要对着一个管理平台,所有存储设备尽在眼前,管理效果事半功倍。"

浪潮中端智能存储AS5000G2系列

第二板斧:老爷车上路,变废为宝

现在很多企业都经历了信息化建设初期,或多或少积累了一些存储的"家底"。这些老存储设备大多服役多年,性能上跟不上新存储设备,高级功能也比较少。久而久之,这些老存储成了企业信息化的鸡肋:继续用,性能跟不上、容易出状况;直接舍弃换新,IT成本太高。

所以,通过存储虚拟化功能实现对老存储的整合、充分发挥老存储的性能,对于降低企业的信息化成本至关重要。浪潮智能存储G2在全系列产品中都提供了存储虚拟化功能,实际运行中可整合95%以上的异构SAN存储设备,这一点毫无疑问领先业界同档次产品。

存储虚拟化可接管不同厂商的存储设备

第三板斧:数据透明流动,业务在线升级

"互联网+"的趋势下,企业的应用数量和数据容量大幅增长,扩容势在必行。由于许多应用程序逻辑上都是相互关联的,所以一旦需要扩容或升级,通常多个应用或数据库很可能不得不同时中断服务。对于企业级数据平台或是公有或私有云服务提供商来说,服务中断可能带来巨大的经济以及品牌损失。

"数据在线、业务连续是一个经久不衰的话题",杨涛表示。"无论是在公有云、私有云还是混合云,无论是在过去、现在还是未来,存储服务不中断都仍然是最重要、最基础的企业级IT服务,这个服务不容有失,不容有错,否则一定会造成大范围的严重后果。"

存储服务中断很大一部分原因在于存储升级:要进行存储升级,就需要将数据从原来的存储迁移到新的存储,这个过程中往往需要中断数据服务。为了避免存储升级带来的存储服务中断,浪潮智能存储G2平台可通过虚拟化技术,对不同存储设备中的企业数据提供统一的透明数据迁移服务。

由于浪潮智能存储G2平台位于在服务器和其他厂商的存储设备之间,应用程序的读写都经过G2。所以,当未来购置新阵列时,可连到G2并利用G2的虚拟化技术实现数据在线迁移。最终,可将老旧设备的数据迁移到新的存储设备,待两台设备的数据100%同步后,应用即可平滑切换到新设备上,这整个过程对业务是零感知的、无损的。

G2,存储高级功能不断升级

存储虚拟化技术只是浪潮智能存储G2平台的众多高级功能之一,整体来看。G2由一套涉及感知、架构、管理的智能体系,包括硬件、软件、算法以及多服务模型的高效协同。G2平台集成了超过1000个软硬件传感器,具备100多个持续优化的核心算法,提供了智能管理、资源调度等十几个服务模型,提供了满足数字化转型需要的智能存储。

从2015年发布AS18000,到2016年的全固态存储HF5000和整机柜软件定义存储AS13000-Rack,再到2017年最新发布的新一代智能存储G2平台,浪潮构建了涵盖统一存储、全固态存储和软件定义存储的存储高端技术和产品布局,实现了存储产品线的完整化和结构化。

浪潮存储在高端技术上的不断创新、产品布局上的不断完善,推动浪潮智慧计算战略在数据存储领域不断创新和突破。浪潮存储,和浪潮的服务器、网络、云产品、大数据等协同发力。在未来整个IT产业里浪潮会提供更为丰富的、端到端的IT基础架构整体方案。

好文章,需要你的鼓励

AI智能体漏洞挖掘成本骤降,Anthropic呼吁AI防御

Anthropic发布SCONE-bench智能合约漏洞利用基准测试,评估AI代理发现和利用区块链智能合约缺陷的能力。研究显示Claude Opus 4.5等模型可从漏洞中获得460万美元收益。测试2849个合约仅需3476美元成本,发现两个零日漏洞并创造3694美元利润。研究表明AI代理利用安全漏洞的能力快速提升,每1.3个月翻倍增长,强调需要主动采用AI防御技术应对AI攻击威胁。

NVIDIA联手多所高校推出SpaceTools:AI机器人有了“火眼金睛“和“妙手回春“

NVIDIA联合多所高校开发的SpaceTools系统通过双重交互强化学习方法,让AI学会协调使用多种视觉工具进行复杂空间推理。该系统在空间理解基准测试中达到最先进性能,并在真实机器人操作中实现86%成功率,代表了AI从单一功能向工具协调专家的重要转变,为未来更智能实用的AI助手奠定基础。

Spotify年度盘点2025首次推出多人互动功能“盘点派对“

Spotify年度总结功能回归,在去年AI播客功能遭遇批评后,今年重新专注于用户数据深度分析。新版本引入近十项新功能,包括首个实时多人互动体验"Wrapped Party",最多可邀请9位好友比较听歌数据。此外还新增热门歌曲播放次数显示、互动歌曲测验、听歌年龄分析和听歌俱乐部等功能,让年度总结更具互动性和个性化体验。

机器人学会“三思而后行“:中科院团队让AI机器人告别行动失误

这项研究解决了现代智能机器人面临的"行动不稳定"问题,开发出名为TACO的决策优化系统。该系统让机器人在执行任务前生成多个候选方案,然后通过伪计数估计器选择最可靠的行动,就像为机器人配备智能顾问。实验显示,真实环境中机器人成功率平均提升16%,且系统可即插即用无需重新训练,为机器人智能化发展提供了新思路。

联想全面激活世界杯官方技术合作伙伴身份,天禧AI足球智能体重磅上线

AI测试成数智化合规必选项,驱动企业高质量发展

AI智能体漏洞挖掘成本骤降,Anthropic呼吁AI防御

Spotify年度盘点2025首次推出多人互动功能"盘点派对"

英国SAP用户因商业套件重启授权迷局感到困惑

AWS发布Graviton5定制CPU,为云工作负载带来强劲性能

美光放弃Crucial品牌:告别消费级存储市场

手机里的NPU越来越强,为什么AI体验还在原地踏步?

如何使用现有基础设施让数据做好AI准备

IT领导者快问快答:思科光网络公司首席数字信息官Craig Williams分享AI转型经验

Anthropic CEO警告AI行业泡沫化,批评"YOLO"式投资

雅虎利用AI实时总结橄榄球比赛精彩内容