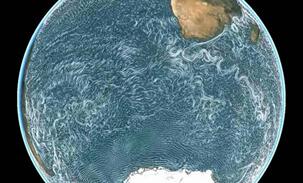

啥样的超级计算机能给海洋做“CT”?

近日,国际高分辨率海洋与气候预测研讨会在青岛海洋国家实验室)顺利举行。浪潮海洋领域高性能计算应用专家受邀参会并做了《E级超算高分辨率海洋模式的优化策略》的报告,现场得到NCAR在内的国内外专家高度关注及好评。海洋国家实验室是目前唯一正式获批试点运行的国家实验室,其超级计算机由浪潮设计构建,峰值性能超千万亿次,是我国海洋领域最快超级计算机,并正在规划升级到百亿亿次E级超算。高分辨率海洋与气候预测可以较精细的探测海洋潮汐、海浪等情况,相当于给海洋做"CT",可以帮助人类了解神秘海洋。

海洋国家实验室于2013年获得科技部正式批复,由国家部委、山东省、青岛市共同建设,定位于围绕国家海洋发展战略,开展基础研究和前沿技术研究,依托青岛、服务全国、面向世界建设国际一流的综合性海洋科技研究中心和开放式协同创新平台。为更好的推进各项海洋研究任务的开展,海洋国家实验室启动了高性能科学计算与系统仿真、海洋药物筛选、海洋科考船队等大型平台和海上试验场等大型设施建设。

海洋国家实验室

高分辨海洋与气候预报对计算力的需求

高分辨率的海洋预报可以为海洋安全、海上活动、防灾减灾等提供更加科学的决策依据。同时也对超级计算的能力构成巨大挑战。目前,海洋气候分析模式大多数是在百公里级以上。高分辨海洋预报模拟会让预测的准确性大幅度提升,预测的结果将更加细致,但相对的计算量也会增加数百乃至上千倍。

清华大学地球系统科学系教授林岩銮表示,在海洋与气候预测领域,提高水平分辨率能解决非常多目前到达瓶颈的问题。推动海气耦合系统模式发展,建立模型的过程中,需要对每个海洋网格增强像素化,这样才能更好的解析中小尺度的气候变化过程。但是水平分辨率提高后,计算量级的增长也非常快,海洋国家实验室的千万亿次超算系统对提高观测水平,应对气候灾害,提升减灾防灾能力具有十分重要的现实意义。

给海洋做"CT"的超算长啥样?

高速均衡设计理念:浪潮为海洋国家实验室设计构建的超级计算机遵循均衡设计的理念,具有"四个高": 高计算性能、高速存储、高速互联、高效水冷。计算上采用浪潮超高密度刀片服务器I8000,8U空间内容纳20个双路计算节点,是业界最高密度的刀片服务器;采用了最先进的100Gb OPA高速网络技术;存储方面选用高效稳定的高速并行存储系统,按需扩展,实测总带宽超过40GB/s;制冷选择业界先进的LCP液冷技术,系统整体PUE低于1.4。

先进高速网络技术:海洋国家实验室超算是中国首套大规模Intel Omni-Path 高速网络的集群。浪潮是Intel在中国最重要的HPC合作伙伴,双方深度合作为采用100Gbps网络的大规模超算构建优化提供了标杆示范。

高效率管理调度:海洋国家实验室超算是一个多用户,多应用,多领域的平台,在其上运行的软件多达近百款,其中很多都是用户自研的应用。浪潮提供了智能的集群管理软件Cluster Engine,依靠浪潮的研发实力,支持为用户进行定制化开发,适配用户的应用,构建了一个易用、高效、稳定的超算平台。

领先应用调优服务:浪潮在高性能计算领域拥有深厚积累,拥有一支专业的高性能应用研究分析团队,通过浪潮独有的天眼应用特征分析软件,为海洋国家实验室提供了应用调优服务,使用户的应用运行效率达到最优,得到了用户的高度好评。

目前,浪潮已经积累了十余个行业的三百余款软件的应用特征,建立了六十余款典型应用基准算例库,能够提供定制化解决方案和专业的应用调优服务。浪潮还拥有国内唯一具备CPU/GPU/MIC的专业软件开发/调优/培训/咨询团队,并且分别与NVIDIA、Intel成立了联合实验室,在GPU/MIC应用开发移植调优方面具有深厚的功力。

未来,高性能科学计算与系统仿真平台将围绕国家海洋科技创新发展的重大应用需求,全面将国家互联网+、国家大数据、国家人工智能2.0等重大战略计划融合到海洋领域中,而海洋国家实验室所布局的海洋动力与气候、海洋药物与生物制药等学科,都对E级超算具有强烈的学科自身计算需求和学科之间的重大协同计算需求。为此,海洋国家实验室还将与浪潮共同推进共同规划建设E级超级计算机的建设,全力打造海洋领域的国产化超算大科学装置。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元

SC25超级计算大会:AMD、英伟达、戴尔发布下一代超算产品

TACC的Horizon超算存储架构:VAST Data等四家公司打造顶级数据存储方案

Alembic Technologies融资1.45亿美元并收购英伟达超算推进"因果AI"技术

美国能源部联手Nvidia、AMD与Oracle打造四台强大AI超级计算机

美国能源部与英伟达合作建造7台超级计算机,包括史上最大系统

橡树岭国家实验室Discovery超算获得DAOS存储选项

英国挥舞7.5亿英镑超算合同吸引厂商竞标

新加坡国立大学超级计算机Hopper进入全球前500强

VAST Data凭借Doudna超算项目成功进军高性能计算领域

英国政府重申对爱丁堡超级计算机计划的承诺,拨款750百万英镑