刚刚融了3个亿的蚁视CES会出什么大招?

2015年倒计时的时候爆出蚁视融资3亿人民币,成为2015年资本寒冬最后的一针兴奋剂。元旦假期刚刚过去,2016年第一场盛会就是1月6-9日在美国拉斯维加举行的国际消费电子展(CES)了,游戏和虚拟现实区位于南馆(South Hall)大厅层的S2区域,这里将会是16年虚拟现实最新技术的集中展示区,Oculus(26002)、Virtuix(26015) 等国外厂商以及国内的ANTVR蚁视(26413) 将集中展示最新VR科技。作为CES连续邀请参加的国内虚拟现实领军企业,又刚刚完成巨额融资,蚁视此次要展示的内容让人非常好奇。

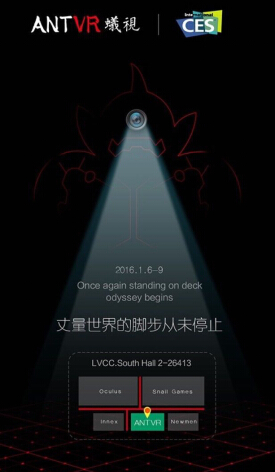

此前业内一直传闻蚁视即将对外发布二代头盔。然而从蚁视已对外发出的CES邀请函“丈量世界的脚步从未停止”来看,图中并没有头盔等产品的露出,反而有一个怪兽,怪兽头部有一个明显的摄像头、地上有网格状红点。

这应该与蚁视之前曾经发布过的位置追踪技术有关。在2015年6月洛杉矶E3游戏展,蚁视对外展示自主研发的虚拟现实头盔位置追踪技术——全息甲板(HoloDeck),体验了多个可以在里面自由行走的场景。这种技术带来的好处,就是将游戏与现实场景融合,玩家在游戏中走、跑、起跳、下蹲等各种动作,都可以完全追踪,更加有沉浸感,更加真实,实现真正的移动式完全沉浸的游戏体验,位置跟踪技术可以缓解目前虚拟现实引发的不适感问题。本次CES最受关注的HTC Vive和Oculus Rift CV1两款虚拟现实头盔都会配有位置追踪设备。HTC Vive是通过墙上的两颗激光传感器识别佩戴者佩戴的机身上的位置追踪传感器从而获得位置和方向信息;Oculus Rift CV1用外部位置追踪摄像头识别佩戴者机身上的红外灯。而蚁视的位置追踪技术与HTC、Oculus的方案完全不同,是在机身上放置红外摄像头,对地面上铺有特殊的标志点进行捕捉,这样的方式可以让位置追踪的范围无限扩展。体验效果到底哪家强呢,值得期待。

如果此次蚁视真的在CES对外展示其二代头盔,二代头盔极有可能增加位置跟踪的功能。除此之外二代头盔还会有哪些新特性?16年几家国外厂商的VR设备都将进入消费者版,CES作为16年的首次盛会相信各家也都会使出杀手锏,以蚁视一贯以来特立独行独立研发的做派来看,此次CES展示的硬件还是非常值得期待的。

除此之外,蚁视积极搭建游戏内容生态并发布相关网游手游,笔者猜测蚁视可能会展示一些相关游戏内容,据传蚁视在国内也在开发占地面积2000平米的鬼屋VR体验馆,可以实现同步位置跟踪效果,此次会不会对外展示具有位置跟踪功能的鬼屋游戏?

除了PC端虚拟现实设备,蚁视移动端VR产品会不会一起亮相呢,VR一体机?VR眼镜盒子?会不会推出最新的VR游戏?刚刚融资3亿的蚁视在巨额资本的推动下是否能在国际舞台上展示惊艳世界的黑科技?这一切都将在1月6日CES现场揭晓。

好文章,需要你的鼓励

iOS 18新增游戏应用正式上线,专为iPhone游戏体验而生

苹果在iOS 26中推出全新游戏应用,为iPhone、iPad和Mac用户提供个性化的游戏中心。该应用包含五个主要版块:主页展示最近游戏和推荐内容,Arcade专区提供超过200款无广告游戏,好友功能显示Game Center动态并支持游戏挑战,资料库可浏览已安装游戏并提供筛选选项,搜索功能支持按类别浏览。iOS 26.2版本还增加了游戏手柄导航支持,为游戏玩家提供更便捷的操作体验。

上海AI实验室让机器人“睁眼看世界“:用视觉身份提示技术让机械臂学会多角度观察

上海AI实验室联合团队开发RoboVIP系统,通过视觉身份提示技术解决机器人训练数据稀缺问题。该系统能生成多视角、时间连贯的机器人操作视频,利用夹爪状态信号精确识别交互物体,构建百万级视觉身份数据库。实验显示,RoboVIP显著提升机器人在复杂环境中的操作成功率,为机器人智能化发展提供重要技术突破。

Sleepbuds制造商Ozlo如何构建睡眠数据平台

睡眠耳塞制造商Ozlo正将其产品转型为数据平台。公司与冥想应用Calm建立合作,利用SDK分享睡眠传感器数据,帮助内容创作者了解用户真实反馈。Ozlo计划推出AI睡眠助手、耳鸣治疗订阅服务和床边音箱等新产品,并收购了脑电图技术公司Segotia,预计2027年推出脑电监测产品进军医疗设备市场,目前正在进行B轮融资。

英伟达团队突破AI训练瓶颈:让机器人同时学会多种技能不再“顾此失彼“

英伟达研究团队提出GDPO方法,解决AI多目标训练中的"奖励信号坍缩"问题。该方法通过分别评估各技能再综合考量,避免了传统GRPO方法简单相加导致的信息丢失。在工具调用、数学推理、代码编程三大场景测试中,GDPO均显著优于传统方法,准确率提升最高达6.3%,且训练过程更稳定。该技术已开源并支持主流AI框架。

iOS 18新增游戏应用正式上线,专为iPhone游戏体验而生

Sleepbuds制造商Ozlo如何构建睡眠数据平台

CES 2026推出AI伴侣机器人Emily

苹果2026年将发布四款新iPhone机型预览

AGI-Next峰会全记录解读:Kimi、Qwen、智谱、腾讯同台,2026年有新范式是共识,中国引领AI概率最低预测2成

Anthropic推出医疗健康功能助力患者理解病历记录

Google推出通用商务协议,推动智能体购物自动化

核电初创公司携小型反应堆回归,面临重大挑战

谷歌针对部分医疗查询移除AI概览功能

Motional采用AI优先策略重启无人驾驶出租车计划

新年存储升级:三星SSD优惠最高减免100美元

OpenAI与软银联手投资10亿美元,助力星门项目能源伙伴发展

达索系统在CES 2026上展示AI驱动的医疗创新, 重塑精准、可预测与个性化医疗

黄仁勋CES 2026记者会:Vera Rubin解析、Groq交易、中国市场,以及当好CEO的两个条件

黄仁勋CES完整实录:英伟达打破规则,Rubin平台芯片六连发,结尾彩蛋似成龙电影

PTC 携手兰博基尼亮相 CES 2026

AWS亮相CES公布将AI引入汽车领域的合作成果

BOE(京东方)前沿技术亮相CES 2025 “HERO”计划描绘多场景智慧新蓝图

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

中国厂商攻占CES:AI仍是C位,出海成为必备

CES:让AI繁花似锦

CES 2024 | 除了生成式AI,CES 2024还有这些值得关注的好产品