借助大模型能力,晓多科技智能客服的效率与服务双提升

随着大模型技术的快速发展与广泛应用,智能客服迎来了前所未有的发展机遇。晓多科技凭借认知智能 SaaS 领域的深厚积累与跨行业实践经验,正积极探索大模型在智能客服领域的无限可能。

晓多科技智能客服广泛应用于电商、电信、政务、教育等多领域,覆盖全国50多城。面对复杂销售场景,晓多科技注意到智能客服在岗前、岗中均有性能提升的需求。利用大模型的强上下文理解能力、总结能力和自然语言多轮对话的特性,帮助客服完成从浏览推荐到下单付款的购物全生命周期旅程。

为此,晓多科技不仅自研“晓模型 XPT”,还携手火山引擎,依托豆包大模型,进一步提升“AI 训练场”与“全渠道智能知识库”的智能化,全面升级智能客服能力。

成都晓多科技有限公司成立于 2014 年,是以智能对话为核心的认知智能 SaaS 产品和行业数智化解决方案服务商。

图片及内容来源于晓多科技官网

更强模型、更低价格、更易落地,豆包大模型助力智能客服场景强化

火山引擎为晓多科技提供了由字节跳动研发的豆包大模型,在智能客服的岗前、岗中等环节,应用大模型能力为服务质量提效。

01

更高 TPM、RPM 支持,

AI 训练场从容应对高并发

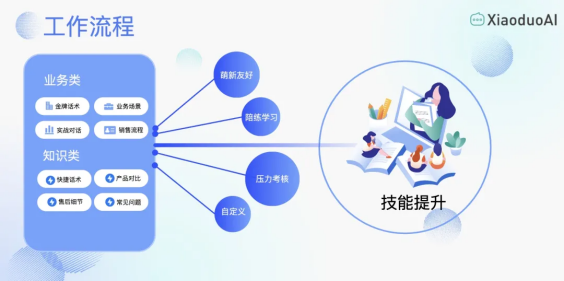

客服需应对多样用户需求,岗前培训关键在于培养快速洞悉客户诉求的能力,这是保障服务质量的基石。晓多科技推出的 AI 训练平台,精准复刻业务场景,利用大模型模拟多角色、多需求用户交互,促使人工客服通过密集训练提升应答效率与精准度,强化服务能力。然而,此系统对模型的并发处理能力及推理速度提出了严苛要求。

覆盖多种销售培训方案

火山引擎为晓多科技提供的豆包大模型由字节跳动自主研发,经过字节跳动内部50+业务场景实践验证,千亿级日 tokens 持续打磨,具有更强性能,初始支持 TPM 较之前提升6倍、初始支持 RPM 提升2000倍,为高并发状态下的业务稳定性提供了有力保障。同时,豆包大模型的角色扮演能力,也以更符合中文习惯和买家的说话方式,赢得了晓多科技的认可。

豆包大模型以技术驱动的极致性价比,助力晓多科技以更低的价格对智能客服进行训练,对智能客服进行持续打磨。

02

更精准用户需求洞察,

将全渠道智能知识库能力最大化

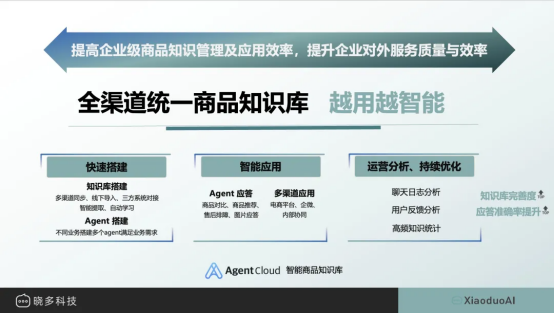

岗中阶段,精准洞察并满足用户需求,是对智能客服能力的终极试炼。而传统机器人将产品信息配置成表格后读取的做法不仅调用时间长,多个售卖渠道配置表也须分别维护,成本极高。晓多科技推出的“多策”全渠道智能知识库,依托大模型,一键部署,全面覆盖,以智能化、自动化手段显著提升客服效率。

全渠道统一商品知识库

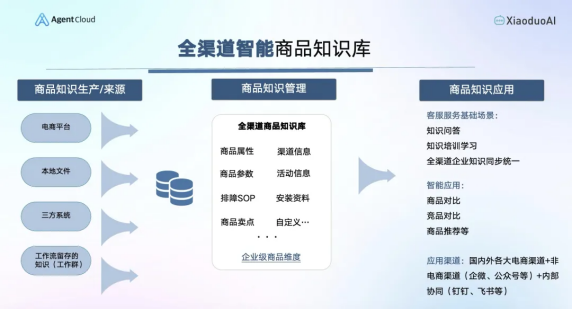

豆包大模型经深度优化,具有更强的分析能力,无缝连接知识库与用户,构建高效沟通桥梁。客服转述用户的提问后,豆包大模型通过分析和精准理解,将问题转化为知识库查询可用的关键字,以便能快速检索到相关内容。随后,基于对用户需求的深刻理解,豆包大模型可在众多内容中将用户最为关心的部分以高亮显示,进行重点呈现,并支持多个不同产品之间的对比。通过两次“转译”让用户以口语化的自然语言提出需求,既收获对核心需求的精准回复,节约对话时间的同时,还提高了用户的满意度和下单率。

03

专业团队支持,

让大模型更易落地

大模型从部署到应用,需要经历一系列优化与精调,在此过程中专业的服务支持将起到事半功倍的效果。火山引擎团队携手晓多科技,通过 PE 优化、精准模型选型、前置高并发保障等措施,清除应用障碍,加速大模型落地进程。

全渠道智能商品知识库

提示词(prompt)设计是提升大模型输出的关键。火山引擎行业团队与晓多科技紧密合作,采用标签化替代自然语言、设定结构化输出模板、创新实践示例、任务定制最优参数等策略,深度优化提示词,显著提升大模型输出的质量和稳定性。特别是在豆包通用模型 Doubao-pro-32k 版本中,针对超 5k 字的文本场景,有效解决了应答延迟问题,实现了用户体验的全面升级。

培训周期更短、客服能力更强,大模型加持下获得效率服务双升级

在火山引擎提供的豆包大模型帮助下,晓多科技的“AI 训练场”场景获得了更高的并发保障,同时成本也优化了50倍以上,实现了效率成本双提升。通过使用豆包大模型能力强化的“AI 训练场”,晓多科技不仅将客服培训周期缩短了50%以上,还通过更多元化的顾客模拟,训练出能力超越常规培训的客服团队,推动销售转化率上升了3%-5%。

目前,晓多科技在智能客服岗前、岗中等场景中实现智能化提升,为其业务的全面升级和开拓全新商业模式打下了坚实的基础。

火山引擎作为字节跳动旗下的云服务平台,致力于成为客户数字化转型和智能化升级的有力伙伴。未来,双方希望进一步将大模型能力应用于智能客服的更多场景,让消费者享受到更为便捷与智能化的客服体验。

来源:业界供稿

好文章,需要你的鼓励

戴姆勒卡车运用图数据库技术梳理IT架构获运营红利

戴姆勒卡车在2021年从奔驰集团分离时,面临1500多个IT系统需要拆分的复杂挑战。公司采用Neo4j图数据库技术,结合ExtraHop网络遥测数据,构建了应用系统依赖关系的动态图谱。该方案成功识别隐藏依赖关系,用3.5年完成分离,应用数量减少40%。图技术不仅解决了分离难题,还为公司提供了全面的IT可观测性平台,结合大语言模型实现智能运维,能快速诊断故障原因并识别安全风险。

ETH苏黎世突破性WUSH技术:让AI大模型压缩实现接近零损失的革命性方案

瑞士ETH苏黎世联邦理工学院等机构联合开发的WUSH技术,首次从数学理论层面推导出AI大模型量化压缩的最优解。该技术能根据数据特征自适应调整压缩策略,相比传统方法减少60-70%的压缩损失,实现接近零损失的模型压缩,为大模型在普通设备上的高效部署开辟了新路径。

SwitchBot推出AI录音器AI MindClip,打造个人记忆第二大脑

SwitchBot在CES展会上发布AI MindClip音频记录器,这款重18克的夹式设备可记录日常对话和工作会议,支持超过100种语言。设备能将语音转换为摘要、待办事项和个人音频记忆数据库,用户可搜索和检索之前可能遗忘的讨论内容。AI驱动的总结、任务创建和信息回忆功能需要订阅云服务才能使用,但具体价格和发布时间尚未公布。

机器人终于能读懂你的手势了!弗吉尼亚大学团队让机器人变身“人类动作翻译官“

弗吉尼亚大学团队创建了Refer360数据集,这是首个大规模记录真实环境中人机多模态交互的数据库,涵盖室内外场景,包含1400万交互样本。同时开发的MuRes智能模块能让机器人像人类一样理解语言、手势和眼神的组合信息,显著提升了现有AI模型的理解准确度,为未来智能机器人的广泛应用奠定了重要基础。

SwitchBot推出AI录音器AI MindClip,打造个人记忆第二大脑

Plaud推出新款AI可穿戴设备,有望取代Otter.ai

Instagram负责人:你的眼睛已经不能分辨什么是真实的了

派拓网络安全官:智能体将成2026年最大内部威胁

Subtle发布搭载降噪模型的无线耳机

Xreal发布新款AR眼镜和电源集线器,革新工作娱乐体验

纳瓦尔Flow 2扫地机器人问世:配备AI识别技术能找到丢失物品

7个家庭AI技巧让智能聊天机器人相形见绌

Mac成为企业环境中最可持续设备的原因调查显示

首次独居必备的10款实用智能设备推荐

OpenAI重组团队开发语音AI硬件产品,2026年推出新模型

AI重塑工作格局:Mercor如何连接人才与智能体训练

英特尔至强6加持下的火山引擎,要降低大模型的应用门槛

字节全新发布豆包AI视频模型 - 再见了Sora,你的时代过去了。

齐聚厦门,共探AI“模”力 2024火山引擎AI创新巡展8月15日见

广汽集团与火山引擎签署战略合作协议

火山引擎联合RollingAI、InfoQ共同发布《生成式 AI 商业落地白皮书》

豆包大模型日均tokens使用量超5,000亿,火山引擎全栈AI服务升级助企业加速AI转型

2024火山引擎AI创新巡展:五城联动,解锁AI落地新密码

携手火山引擎,三星Galaxy Z系列手机为用户带来AI新体验

借助大模型能力,晓多科技智能客服的效率与服务双提升

火山引擎多重优势,助力企业出海抓住 AI 新机遇