HDC 2024大会展示具身智能人形机器人新突破

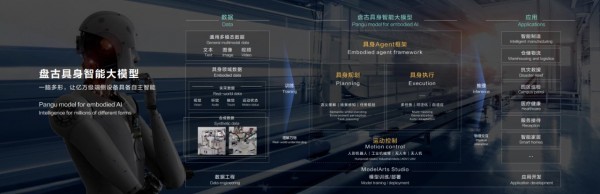

在6月21日举行的华为开发者大会(HDC 2024)上,华为云正式推出了盘古具身智能大模型,会上,搭载盘古能力的人形机器人也同步亮相。盘古大模型能够让机器人完成10步以上的复杂任务规划,并且在任务执行中实现多场景泛化和多任务处理。同时盘古大模型还能生成机器人需要的训练视频,让机器人更快地学习各种复杂场景。

大模型的多模态能力以及思维能力的快速提升,使机器人能够模拟人类常识进行逻辑推理,并在现实环境中高效精准地执行任务,从而有效解决了复杂环境感知与物理空间认知的难题。通过集成多场景泛化和多任务处理能力,盘古模型赋予机器人前所未有的适应性和灵活性,无论是面对工业环境还是家庭生活场景,都能游刃有余。

会上,乐聚人形机器人夸父通过识别物品、问答互动、击掌、递水等互动演示,直观展示了双方基于盘古大模型的合作成果。通过模仿学习策略,华为云与乐聚公司显著提升了人形机器人的双臂操作能力,实现了软硬件层面的协同优化,不仅增强了机器人综合性能,还克服了小样本数据训练的局限性,推动了泛化操作能力的边界。

张平安在大会上表示,除了人形机器人,盘古具身智能大模型还可以赋能多种形态的工业机器人和服务机器人,让它们帮助人类去从事危险和繁重的工作。

“正如大家所期望的,让AI机器人帮助我们去洗衣、做饭、扫地,让我们有更多的时间去看书,写诗,作画。”张平安表示。

来源:业界供稿

好文章,需要你的鼓励

麻省理工学院发现LLM“幻觉“新根源:注意力机制竟然会自相矛盾

麻省理工学院研究团队发现大语言模型"幻觉"现象的新根源:注意力机制存在固有缺陷。研究通过理论分析和实验证明,即使在理想条件下,注意力机制在处理多步推理任务时也会出现系统性错误。这一发现挑战了仅通过扩大模型规模就能解决所有问题的观点,为未来AI架构发展指明新方向,提醒用户在复杂推理任务中谨慎使用AI工具。

Google力推手机AI功能引发关注

继苹果和其他厂商之后,Google正在加大力度推广其在智能手机上的人工智能功能。该公司试图通过展示AI在移动设备上的实用性和创新性来吸引消费者关注,希望说服用户相信手机AI功能的价值。Google面临的挑战是如何让消费者真正体验到AI带来的便利,并将这些技术优势转化为市场竞争力。

中科院团队构建史上最大多模态AI对齐数据集:让机器真正读懂人类偏好的秘密武器

中科院自动化所等机构联合发布MM-RLHF研究,构建了史上最大的多模态AI对齐数据集,包含12万个精细人工标注样本。研究提出批评式奖励模型和动态奖励缩放算法,显著提升多模态AI的安全性和对话能力,为构建真正符合人类价值观的AI系统提供了突破性解决方案。

“4个9”韧性的背后,西云数据以技术与运营加速企业数字化创新

Google力推手机AI功能引发关注

Meta发布AI翻译功能,支持脸书和Instagram内容实时转换

HPE发布Nvidia Blackwell驱动的AI服务器,抢占AI市场需求

ISACA推出AI安全管理高级认证项目

谷歌推出智能体SOC系统提升安全事件响应速度

Lumen升级400GB数据中心连接基础设施助力AI发展

AI和流媒体推动,2030年面临"网络危机"

Pine64停产Pro手机转向RISC-V业务

日立Vantara将VSP One块存储扩展至Azure云平台

Finchetto光学数据包交换机:光无法存储的技术挑战与突破

Python开发者调查显示增长强劲,但基金会资金面临困境