建立新秩序 HarmonyOS NEXT星盾安全架构打造真正原生安全

2024年6月21日,HDC.2024华为开发者大会在东莞篮球中心拉开帷幕,在主题演讲中,通过华为终端BG首席执行官何刚的主题演讲了解到在日常用机场景中,恶意程序威胁依旧呈现逐年递增趋势,用户隐私泄漏的风险始终存在。因此华为全新自研的HarmonyOS NEXT星盾安全架构应运而生,依托强大的软硬协同能力和鸿蒙内核,构建了全新的安全体系和秩序,全流程保障应用生态纯净,让用户隐私安全体验迎来创新突破。

纵观HarmonyOS发展史,早在HarmonyOS 2问世时就首次面向用户推出纯净模式。随着HarmonyOS版本的更新,纯净模式也随之升级,面对应用恶意行为实施动态检测和管控。之后HarmonyOS 4推出应用管控中心,主动拦截应用恶意行为,降低风险。据官方统计,HarmonyOS日拦截恶意应用行为数从2022年的2亿次,到现在只需拦截700万次,应用获取用户隐私次数下降45%。然而HarmonyOS NEXT的革新安全技术,重新构建了操作系统的安全体系与秩序,基于软硬协同和鸿蒙内核的强大底座,给消费者提供了更加纯净的生态体验、可控的隐私保护和高安的数据保护,让用户无需担心病毒和恶意应用的骚扰。

应用安全管理机制革新,从来源到运行杜绝应用恶意行为

全新的HarmonyOS NEXT星盾安全架构从以前的纯净模式、应用管控中心等功能的管控,升级为从整个系统机制去治理。全新的应用市场拥有超过200种检测能力及数百名专家审核,不满足安全要求的代码和应用无法上架、安装,确保每一款应用都符合高标准要求,从源头确保应用纯净可靠,构建健康纯净的生态秩序。同时HarmonyOS NEXT还会全程守护应用的运行安全,若应用在运行过程中出现违规行为,则会禁止该应用运行,真正做到从应用来源到应用运行,从根源上杜绝恶意行为。

业界首创安全访问机制,用户按需授予系统数据

以往手机系统对于设备应用权限的获取,主要存在「应用权限申请不合理」以及「权限过度使用」两种情况,这也意味着用户的高铁行程、银行信息、快递单号等大量敏感隐私数据将在不知不觉中被应用访问并获取。而HarmonyOS NEXT以保护用户隐私为核心,重新审视应用权限获取的合理性,制定了严苛的隐私保护机制。

首先HarmonyOS NEXT全面梳理了所有系统授权,禁止开放通话记录、短信、电话、读取已安装应用列表等9类不合理权限,从根源上降低隐私泄漏的风险。

其次HarmonyOS NEXT推出业界首创安全访问机制,改变应用获取隐私数据的方式,让用户从管理「权限」到管理「数据」,按需授予系统数据。这样一来,当用户想要更换社交平台头像时,应用将无法再获取整个图库的访问权限,用户选择哪张照片,应用就得到哪张照片,将用户的隐私数据与应用之间受控隔离,全面守护用户隐私。

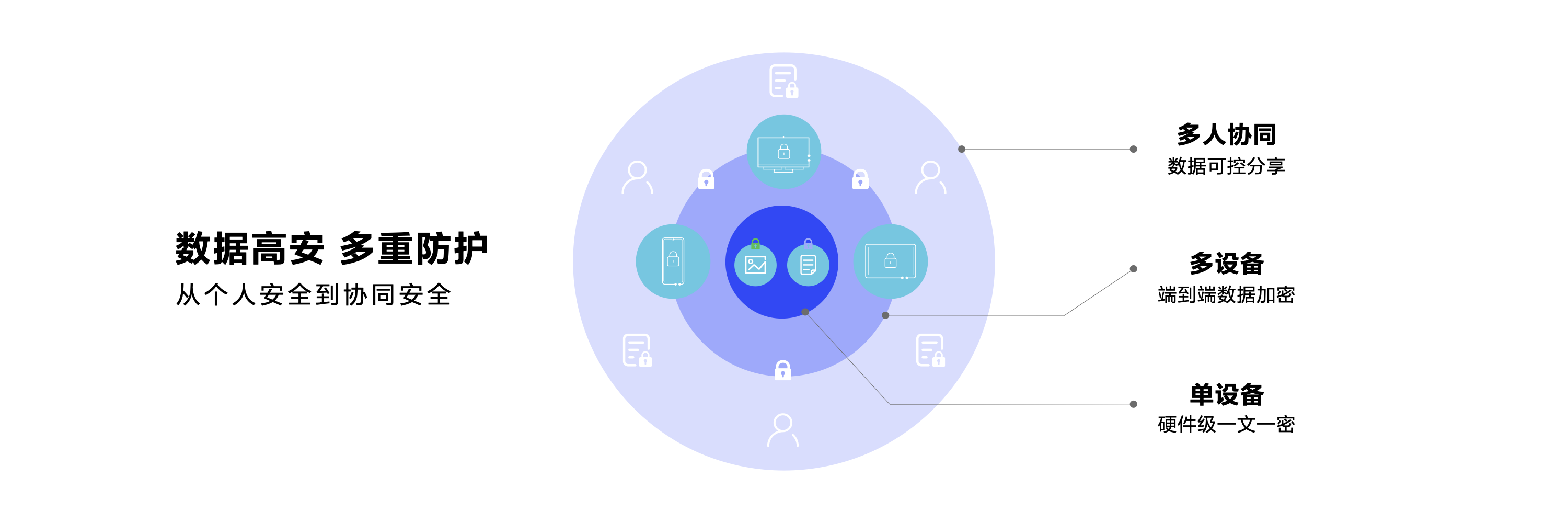

系统级文件加密分享机制,多人协同跨设备流转不惧泄密

守护个人隐私安全的同时,HarmonyOS NEXT在信息跨设备流转场景中也可获得系统级文件加密防护。用户通过手机或平板就可以对文件进行加密,分享出去后,只有授权的用户才能打开,不限应用,不限分享渠道,支持Word、PDF等多种文件类型,用户无需再为了保密而强调“不要转发”。

此次HarmonyOS NEXT星盾安全架构的问世,从根本上有效解决了生态作恶与隐私数据泄露的行业安全难题,真正做到全生命周期式保护用户隐私数据。同样也会保障开发者的合法权益,并为金融类生态安全业务伙伴保驾护航。在未来HarmonyOS NEXT星盾安全架构也将持续进化,为用户打造更安心、更舒心、更省心的HarmonyOS使用体验。

来源:业界供稿

好文章,需要你的鼓励

奥运级别的努力:首席信息官为2026年AI颠覆做准备

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify推出AI播放列表功能让用户掌控推荐算法

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。

为AI+而生,海辰储能发布全球首款锂钠协同AIDC全时长储能解决方案

长时储能开启智慧未来:海辰储能生态日全球首发三大新品

Arm 借助融合型 AI 数据中心,重塑计算格局

奥运级别的努力:首席信息官为2026年AI颠覆做准备

Spotify推出AI播放列表功能让用户掌控推荐算法

Adobe押注生成式AI获得回报,年度营收创历史新高

OpenAI与迪士尼达成十亿美元合作协议,米老鼠和漫威角色进入Sora

甲骨文150亿美元数据中心投资导致股价下跌

Spoor鸟类监测AI软件需求飞速增长

制药行业AI数据质量危机:垃圾进垃圾出的隐患

Harness获得2.4亿美元融资,估值达55亿美元,专注自动化AI编码后的开发流程

英伟达CEO黄仁勋独家专访:万亿美元押注AI工厂将成为新时代计算机

干货和福利都为你准备好了!HarmonyOS公开课报名持续至8月10日

华为游戏中心携网易等伙伴参展CJ,鸿蒙原生游戏成最大看点之一

与天才少年同框!HarmonyOS公开课将招募百名青年学子走进华为

华为阅读携手人民邮电出版社上架独家鸿蒙相关书籍,覆盖鸿蒙开发全流程

机会来了!HarmonyOS NEXT开发者Beta第二期来袭!

HarmonyOS NEXT助力未来:南昌航空大学周子萌的开发者之旅

HarmonyOS NEXT 赋能小红书,引领社交媒体平台全新沉浸式体验

高德地图携手HarmonyOS NEXT,打造智能出行极致用户体验

HarmonyOS NEXT赋能南方航空,打造民航出行的极简高效体验

建立新秩序 HarmonyOS NEXT星盾安全架构打造真正原生安全