宁畅“全栈全液”AI基础设施方案发布!

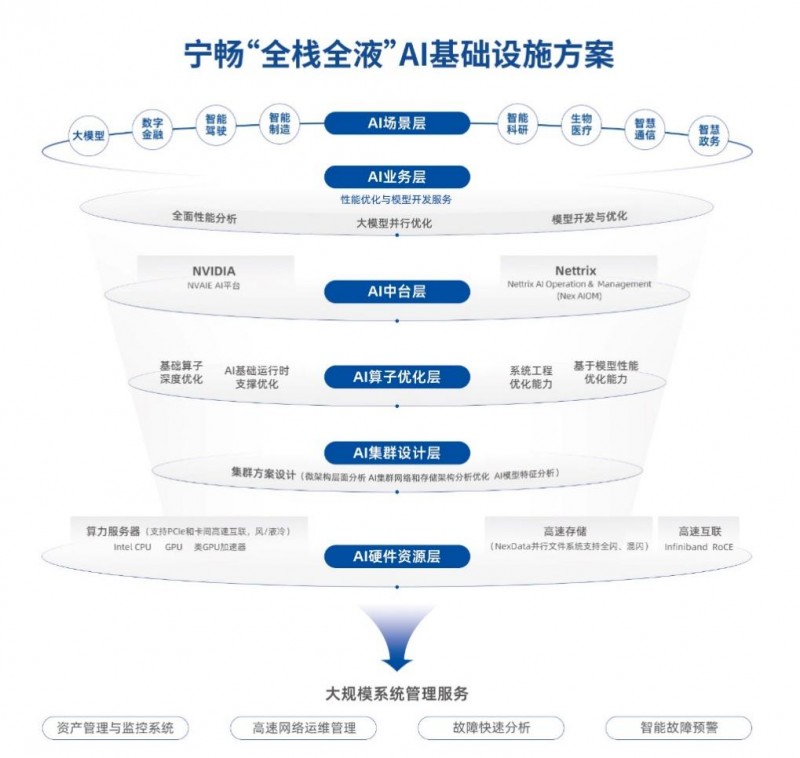

5月30日,在“全局智算”战略下,宁畅正式发布“全栈全液”AI基础设施方案,在业内首先实现了“全栈全液”的智算中心建设能力,助推智算中心发展迈入新阶段。

软硬兼备 + 全栈全液,重塑智算中心新形态

在以大模型为焦点的新一轮 AI竞赛中,算法协同优化、数据处理能力、以及与特定行业应用的融合度,都成为推动大模型实际落地的核心因素。

为此,宁畅构建了以底层硬件到顶层应用平台的全栈AI系统环境。软件层上以AI算子全栈优化能力,为AI 业务提供并行加速、性能分析、模型开发优化等服务支持,帮助用户极速推进AI应用开发及管理;硬件层上实现GPU服务器与GPU卡的灵活组合,散热方式上可选液冷、风冷或风液混合,实现性能与能效的绝佳平衡。宁畅近期推出的业内首个实现原生全液冷的通用机架服务器,从原生全液冷、大解耦、高能效三方面发力,助力数据中心实现了“全栈全液”新生态。

部署经验 + 先享后付,打造“性价比”天花板

如今,各行各业对于智能计算的需求呈指数式增长。宁畅“全栈全液”AI基础设施方案已为区域智算中心、互联网、车企、高校等各行各业的客户提供了服务。

从实际应用场景来看,宁畅“全栈全液”AI基础设施方案可支持大模型落地所需的计算、存储、网络、建设、管理、应用及液冷等全方位需求,能够为智算中心的构建、以及大模型落地过程中面临的问题,提供强有力的支持,打造企业/行业级智算中心标准方案。

随着算力成为稀缺资源,宁畅从客户角度出发,提供了“先享后付”的算力购买方案。目前,宁畅AI算力栈已开放免费试用,现已有50+用户预约试用。该算力栈是一个包括128台GPU服务器的千卡级别算力集群,标准化智算中心建设方案囊括了羽量级128、轻量级256、中量级512、重量级1024四个等级,实现全量级灵活扩展,给了用户极大选择空间。用户可在试用中尝试不同的业务组合、方案框架,以便找到“最优性价比”的智算中心建设方案。

智算中心是AI时代的“水电站”,在推动行业数字化转型、促进AI产业化落地的重要性不言而喻。宁畅将持续为客户和伙伴提供智算中心建设的新势能,共创更美好的AI未来。

来源:业界供稿

好文章,需要你的鼓励

AI新加坡联手阿里云推出东南亚大语言模型Sea-Lion v4

新加坡人工智能机构与阿里云发布全新大语言模型Qwen-Sea-Lion-v4,专门针对东南亚语言和文化特色进行优化。该模型结合阿里云Qwen3-32B基础模型和大量东南亚地区数据集,在东南亚语言模型评估榜单中位居开源模型首位。模型支持119种语言,能在32GB内存的消费级笔记本上运行,采用字节对编码技术更好处理非拉丁文字,并具备3.2万词元上下文长度,可执行文档级推理和摘要任务。

AI拒绝答题“考试“:CMU与亚马逊携手打造语言模型检测器,防止AI胡编乱造误导人类

这项由CMU与亚马逊AGI联合完成的研究揭示了当前AI系统的重大缺陷:即使最先进的模型也不知道何时该说"我不知道"。研究团队开发的RefusalBench评估系统通过176种语言操作技巧动态生成测试案例,发现顶级AI在多文档任务中的拒绝准确率低于50%。这项研究不仅提供了标准化测试工具,更为构建诚实可靠的AI系统指明了方向。

5个将在2026年改变任何企业的惊人智能体应用案例

AI智能体是下一代业务自动化工具,不仅能对话交流,还能执行复杂任务。与ChatGPT聊天机器人不同,它们可在最少人工干预下规划并完成工作。文章介绍了五个高影响力应用:自动化客户服务解决方案、销售CRM管理、合规自动化、招聘筛选与排程、市场情报报告。这些应用都具有重复性工作流程、依赖结构化数据、遵循可预测规则等特点,能够释放员工宝贵时间用于更有价值的工作。

人大联合腾讯重磅推出LaSeR:让AI学会自我评判的最后一招,竟然只需看一个词!

这项由中国人民大学联合腾讯开发的LaSeR技术,发现了AI在生成答案最后一刻会无意中透露对答案质量的评估。通过观察这个"最后一词效应",研究人员开发出了一种让AI高效进行自我评估的方法,在几乎不增加计算成本的情况下,大幅提升了AI的自我验证能力,为构建更可信的AI系统开辟了新路径。

AI新加坡联手阿里云推出东南亚大语言模型Sea-Lion v4

5个将在2026年改变任何企业的惊人智能体应用案例

嵌套学习:谷歌又一个Transformer级别的研究?AI学习就像做梦一样层层嵌套

国家数据局公布2025年“数据要素×”大赛获奖名单:蚂蚁数科获优秀奖

超1亿用户可随时唤醒千问,夸克发布最新AI浏览器

阿里云服务器部署速度跟不上AI需求,GPU配给优先大客户

ChatGPT推出AI购物助手 生成个性化买家指南功能

Google与英伟达AI芯片竞争升级,Meta寻求合作

Mercy Ships与Presidio、思科携手推动海上医疗数字化变革

日本芯片初创公司Rapidus计划建设1.4纳米芯片制造厂

长虹佳华荣膺微软年度最佳合作伙伴大奖,云智协同驱动中国企业全球化跃迁

Hitachi Vantara推出VSP One高端块存储,赋能AI与任务关键型工作负载新时代