大兆极存发布最新版超融合平台,协助ISV打造一站式解决方案

大兆极存(Bigtera)今日发布了全新版本的超融合基础架构(Hyper Converged Infrastructure; HCI)产品VirtualStor® ConvergerOne 1.3。VirtualStor ConvergerOne是一个整合运算、存储与网络资源的超融合平台,可提供弹性、敏捷的交付服务,有效突破传统三层式体系结构的资源扩展难、运维管理复杂等限制。最新版VirtualStor ConvergerOne 1.3多项强大新功能为独立软件开发商(ISV)提供更加安全、高效,且简单易用的运行平台,协助打造一站式解决方案,一次满足预算、人力、效能三大需求。

ISV运用超融合基础架构来开发软件已成为市场主流趋势。VirtualStor ConvergerOne 1.3可协助ISV立即部署AI或其他应用程序,使其能更专注在平台与应用层面的发展,此外,在不影响系统运作前提下,能按需扩展计算与存储资源能力。大兆极存正积极寻找更多优秀且具未来发展性的ISV,目前已与多家合作伙伴洽谈共推一站式解决方案,包括和AI业界拥有高知名度软件公司打造AI-Stack一站式解决方案,能降低中小企业跨入AI的门坎。

VirtualStor ConvergerOne 1.3无论在数据保护、虚拟机管理等方面,皆提供良好的运作机制,甚至可为超融合架构外部的前端系统提供NAS或SAN服务,便于企业汰除老旧存储设备,确保所有前端应用皆享有更高的I/O存取效能;另外还能整合AI平台,满足数据分析、图像处理等热门需求。除了ISV,有虚拟化、VDI、大数据分析等作业需求的企业,都适合部署VirtualStor ConvergerOne 1.3,借此打造极简、安全、高效的数字化基础架构。

新版的VirtualStor ConvergerOne 1.3拥有六大创新亮点:

■ 优异的效能表现:经由大兆极存以最小集群运行9个虚拟机进行实测,显示VirtualStor ConvergerOne的随机读取效能可达23万IOPS、随机写入效能可达8万IOPS,表现极为突出。

■ 提供批次复制功能:短短2~3秒内即能复制10个或20个以上虚拟机,且批次产生IP地址与网络名称、以避免虚拟机彼此冲突,可满足VDI、研发测试等多人同时应用的情境,同时藉由Linked Clone技术节省95%以上的复制空间。

■ 可将存储资源池提供予外部使用:大兆极存活用软件定义存储(SDS)技术,使得VirtualStor ConvergerOne 1.3的存储资源池不仅能为超融合架构环境内部的虚拟机所用,也可进一步为外部的前端系统提供NAS或SAN服务,让企业可顺道替换老旧存储系统。

■ 完整的系统保护:可透过集群方式,保障实体机、虚拟机与虚拟化存储的高可用性。假设某节点出状况,系统会立即将其承载的服务进行迁移,由相关虚拟机重新转向新节点来继续运作;支持节点自我修复功能,当节点硬件修复后要重新加入集群时,系统会自动执行数据同步与负载平衡配置,完成后将它加入集群,用户可选择是否将虚拟机迁移回来。

■ 支持虚拟机快照:藉由快照功能,备份当下虚拟机运行状态、以及内存里的数据,让用户日后能完整回复当时状态。执行虚拟机快照时,会将原虚拟机数据转为Read Only状态、无法再写入,并以COW(Copy-on-Write)方式产生新的数据块,因此即使此数据区块遭人为破坏(例如被勒索病毒加密),用户亦可切换回上次快照数据,确保营运服务持续运行。

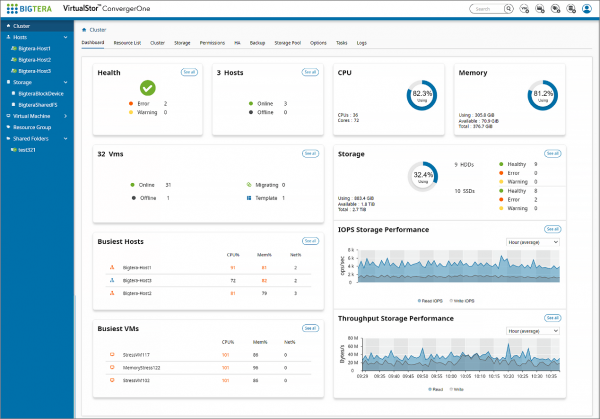

■ 简单易用:一般IT人员即可透过统一的Web UI接口执行系统管理与资源监控,完全不需要手动输入复杂命令或脚本;举凡新增与设定虚拟机或HA配置、共享文件夹、资源群组或存储池,乃至于利用图形接口监控集群、主机节点、存储池、虚拟机的资源管理与监控,都能轻松上手。

VirtualStor ConvergerOne 1.3主要特色如下:

- 软件定义的超融合基础架构,部署快速、管理简便

- 虚拟机资源生命周期管理,复制、备份、在线迁移、快照、回复等一应俱全

- 集群高可用(HA),保障虚拟机服务,存储服务,网络服务的业务连续性

- 内建可横向扩展的存储资源池,可提供虚拟机及外部应用使用与共享

- 单一网页管理接口,轻松管理与配置资源;图形化接口简化了状态和资源的监控

- REST API接口,满足DevOps、维运自动化与整合ISV业务软件的需求

- 以角色为基础(Role-based)的权限管理,适合企业内部权限控管

来源:至顶网存储频道

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。

稚晖君发布全球最小全身力控人形机器人,上纬启元开启个人机器人时代

2026年软件定价大洗牌:IT领导者必须知道的关键变化

Linux 在 2026 年将势不可挡,但一个开源传奇可能难以为继

CES 2026趋势展望:全球最大科技展五大热门话题预测

人工智能时代为何编程技能比以往更重要

AI颠覆云优先战略:混合计算成为唯一出路

谷歌发布JAX-Privacy 1.0:大规模差分隐私机器学习工具库

谷歌量子AI发布新型优化算法DQI:量子计算优化领域的重大突破

缓解电动汽车里程焦虑:简单AI模型如何预测充电桩可用性

Titans + MIRAS:让AI拥有长期记忆能力

Gemini为STOC 2026大会理论计算机科学家提供自动化反馈

夸克AI眼镜持续升级:首次OTA,支持89种语言翻译

五年16次迭代,云易捷超融合架构的进化与突破

Gartner 2024 年存储技术成熟度曲线发布,SDS不再是唯一变革性技术

IDC发布2023年中国整体超融合市场报告,深信服第一

超融合架构创新升级 开启企业应用现代化新篇章

面对瞬息万变的市场,Nutanix拿下创纪录营收

PowerFlex4.5:以不受约束的软件定义架构,实现不受限制的存储即服务能力

创新不息,更新无限 青云云易捷成就强大技术底座

Forrester发布超融合基础设施报告,VMware与Nutanix双雄并立

思科与Nutanix携手推出首款超融合产品,为合作伙伴提供更多机会

思科和Nutanix升级合作伙伴关系:带来的不仅仅是超融合基础设施