打破存储性能瓶颈,实现AI应用的腾飞 原创

经典的“木桶理论”告诉我们,决定桶能装多少水,是由最低的那块木板来决定的。

同样目前数据在整个IT系统中的运行过程,也有一个瓶颈一直存在,就是存储介质的性能。

互联网催生了海量应用,海量应用诞生了海量的不同种类的数据。要让多元的数据发挥价值,不仅需要更强的处理器,更快的网络还有最终数据存储的读写能力。

今天算力发展喜人,多元的数据,催生着多元的算力的出现,通用算力CPU、人工智能算力GPU、TPU、NPU等处理器的蓬勃发展,X86、ARM架构等算力的架构发展。

网络技术发展喜人,移动互联、视频、直播等对于海量的数据传输需求,催生了数据中心的网络带宽100G、400G端口的发展。华为早在2018年正式发布全新400G光网络商用解决方案,支撑运营商全业务场景的400G网络快速部署。

同样存储技术在性能方面的发展并不喜人,海量的数据催生了存储技术的发展,介质上从磁盘到NAND、3D NAND的固态盘,接口从SAS、SATA、PCIE、NVME传输协议的升级。但是我们看到存储在单位容量增长的速度,远远大于单位存储传输性能的速度。数据在存储介质和外界交换的传输速度成为整个IT系统的瓶颈。

在积极突破存储瓶颈的方向上,目前提出有三种方法,一、直接采用全新的架构和技术重新定义存储技术。二、采用分布式存储,让数据分散传输来提升整个IT系统的效率。三、研发新的存储介质,包括原子存储技术和DNA存储技术。

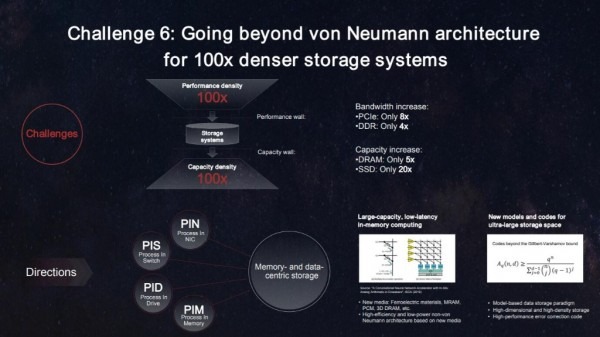

研发新的架构和技术。在不久前的2021华为全球分析师大会,华为发布了迈向智能世界2030的九大技术挑战与研究方向,其中就有针对IT架构中最后的挑战,存储性能提升给出了方向,包括构建提升存储性能百倍的新存储技术研究方向。

华为希望从突破冯诺依曼架构来提升存储能力。目前的IT架构基于冯诺依曼架构,数据在CPU、内存、存储介质之间移动,其中任何一个环境的性能差,都会对整个系统带来性能挑战。

我们看到CPU的性能一直在提升,内存的性能也在提升,网络的带宽也在提升,存储的容量也在提升,但是存储的性能却一直是瓶颈,包括当前的PCIE、NVME等存储接口的带宽速度远跟不上外部网络的性能增长。

华为的思路是要提升存储性能,需要突破冯诺依曼架构的限制,从以CPU为中心,转向以内存为中心、以数据为中心,从搬移数据转向搬移计算,打破性能墙。

还有一种方案提高数据存取的效率,当面临海量数据存取的时候,用最少的存取,实现最大的应用。这就是是分布式存储。

比如现在火热的IPFS就是一种比较火热的分布式存储系统,其核心概念是基于内容寻址、版本化、点对点的超媒体传输协议。也就是数据存取直接指向资源,并确保这些数据都是来自最近的资源。而不是先找到存放的存储介质,在调取介质里的数据。这样就大大减少了存储介质性能对于数据存取的影响。比如一个10TB的文件,可以打散分布在1000个边缘端的存储介质上。而且调用的时候,不需要下载到本地,直接调用1000个边缘端的存储性能。从而实现数据的高效利用。

第三就是新的存储介质,包括原子存储技术和DNA存储技术,如果能够真正研发出来,就能够实现存储性能的千倍以上的提升,当然目前是理论阶段,距离真正落地商业还有还长的距离。

来源:至顶网存储频道

好文章,需要你的鼓励

生成式AI是否增强左脑削弱右脑真相探究

近期有观点认为,大规模使用生成式AI和大语言模型会增强人类左脑的逻辑分析能力,同时削弱右脑的创造力,导致人类社会逐渐成为左脑主导的群体。但研究表明,左右脑功能分工理论缺乏科学依据,大脑两半球在创造性和逻辑性任务中都会协同工作。此外,AI不仅能辅助逻辑思维,同样可用于诗歌创作、图像生成等创意任务。

圣母大学团队发明AI科学助手:让计算机也能像科学家一样搞发明创造

这项由圣母大学和IBM研究院联合开展的研究,开发出了名为DeepEvolve的AI科学助手系统,能够像人类科学家一样进行深度文献研究并将创新想法转化为可执行的算法程序。该系统突破了传统AI要么只能改进算法但缺乏创新、要么只能提出想法但无法实现的局限,在化学、生物学、数学等九个科学领域的测试中都实现了显著的算法性能提升,为AI辅助科学发现开辟了新的道路。

微软推出 Elevate 计划助力阿联酋AI雄心

微软全球AI巡展在迪拜举行,宣布启动Microsoft Elevate UAE项目,计划为超过25万名学生和教育工作者以及5.5万名联邦政府员工提供AI技能培训。该项目是微软152亿美元投资计划的一部分,旨在加强AI基础设施建设,培养本地人才能力。微软还将与G42和JAHIZ平台合作,为联邦公务员提供技术培训,支持阿联酋成为AI领域的区域和全球领导者。

卡内基梅隆大学重大发现:代码到底为什么能让AI变聪明?

卡内基梅隆大学研究团队通过3331次大规模实验,系统揭示了代码训练如何提升AI推理能力。研究发现,代码的结构特性比语义内容更重要,适当的抽象形式(如伪代码)可以达到与原始代码相同的效果。不同编程语言产生差异化影响:低抽象语言有利于数学推理,Python更适合自然语言任务。这些发现为AI训练数据的科学化设计提供了重要指导。

微软推出 Elevate 计划助力阿联酋AI雄心

数据中心巨头斥资数十亿布局太阳能发电

华为Mate 70 Air发布:又一iPhone Air竞争者登场

思科升级企业网络架构应对AI时代需求

蚂蚁集团乌镇峰会获多个重要奖项,AI技术实现多产业落地

蚂蚁数科Agentar入选互联网之光博览会十大首发成果

创新驱动 全栈赋能 戴尔科技集团亮相第八届中国国际进口博览会

谷歌地图接入Gemini AI 打造全知智能助手

微软构建虚假市场测试AI智能体,结果暴露意外缺陷

数据中心安全检查清单:5大核心类别消除运营风险

微软商店推出16款应用同时安装新功能

Perplexity展示如何在老旧GPU和AWS网络上高效运行大型AI模型