存储网络未来革新第一步,看华为NoF+如何“支招”

4月14日,在日本东京2021 Interop大展中,华为下一代高性能跨数据中心存储网络(以下简称NoF+方案)在“云计算基础设施”组斩获银奖 。

日本东京2021 Interop大展华为NoF+方案颁奖现场

日本东京Interop大展作为日本规模最大,行业影响力最强的ICT展会,业界顶级的科技公司每年都会在Interop上展示最领先的解决方案,此次华为以NoF+方案参与角逐,凭借方案的先进性、独特性以及精彩的现场演示,获得了主办方评委的一致肯定与青睐。那么,华为下一代高性能存储网络NoF+何以成为面向未来的存储网络建设方向、支撑数据中心发展?首先,从存储与网络两者的关系与发展中我们可一探究竟。

新技术引爆存储产业迭代,创新存储网络呼之欲出

近年来全闪存阵列逐步取代了以往机械硬盘的存储设备, NVMe协议的诞生大幅释放闪存性能潜力。同时其他介质、架构等存储新技术的广泛应用也成为驱动存储飞速发展的引擎。而为了让数据中心更好的承载业务发展,存储对数据中心里密切配合的“好搭档”——网络也提出了新的诉求。

智能时代新技术、新应用层出不穷,数据呈现爆发式增长,对业务时实时性要求逐步提高,首先就是更加要求高性能下的稳定性,存储作为数据中心底座,为了减少存储抖动放大对业务的影响,越是在高业务负荷承载的情况下越要保持稳定;其次在疫情时代,更多线下业务转型线上,数据流动性极大增强,这时就需要考虑如何能够满足大规模建设问题,未来必然需要扩展性更强大、产业可持续发展的网络;最后还要保障在大规模扩展建设情况的易用性,以便很好的解决业务扩张带来的挑战。

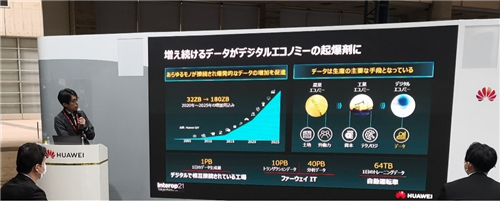

日本东京2021 Interop大展华为NoF+方案宣讲现场

历史上出现过很多诸如iSCSI、FCoE等改造技术,实质上却并未颠覆专用网络的形态,存储产业迅速发展,能解决这些新诉求、更适合智能时代的创新存储网络呼之欲出。

变革序幕拉开,新以太技术支撑数据中心发展

网络产业其实也为了满足数据中心存储的诉求做过很多尝试,业界基本形成一个共识:在未来建设大规模通用型数据中心时,用以太网承载存储网络是必然趋势。

首先以太网络产业更加健壮和开放,产业的可持续发展能力需求是不变的真理。同时更多厂家的参与也带来了技术的快速发展,以太网络目前仍然可以满足“摩尔定律”的演进能力,性能短期内快速翻倍;其次华为创新的以太网络架构已提供了更加强大的扩展性保障。而这也催生NVMe over Fabrics(NoF),成为业界趋势。

从NoF到NoF+,华为如何引领下一代存储网络变革

华为发布NoF+方案,与当下业界的标准NoF(NVMe over Fabrics)方案有何不同呢?

基于当下业界主流标准NoF,华为依靠在网络和存储领域的深厚积累,进一步从可靠性、性能和易用性这三点都进行提升,基于智能无损网络数据面向存储场景提出了NoF+解决方案。将数据中心存储网络进一步推向更广阔的发展空间。

日本东京2021 Interop大展华为NoF+方案展台现场

首先是在可靠性上的增强,保障业务系统可靠是存储的根基,比如存储的秒级切换功能就是可靠性的关键保障之一,标准以太缺乏故障主动发现和通知能力,华为NoF+实现了从事后被动响应到主动通知、提前识别拥塞和故障,当一个节点出现故障,业务会以亚秒级响应速度切换,在高性能运行的前提下,也能维持系统的稳定可靠。

其次是在性能上的增强,华为NoF+方案改变了传统以太静态水线方式,对网络预测性能力进行专项优化,通过样本计算,针对特定场景,通过算法进行精准的控制,从而实现预判业务对网络的诉求,提前做出优化,实现高吞吐带宽,进一步提升性能。

最后华为的存储与网络产品强强联合,打造了“即插即用”的方案,实现了一键式扩容,自动化管理,增强了在未来建设时的易用性。

华为NoF+基于智能无损网络和存储的智能“传-算-智-存-管”,实现了数据在数据中心端到端调优,加快了数据传输速率以及网络传输中的误码率,提升了系统可靠性,在核心业务场景使用中堪称“神来之笔”。

目前,华为NoF+是业界唯一集合零丢包的以太网,大带宽、低时延、易维护,开放兼容,利于存储、网络、计算三种资源融会贯通,实现数据的实时共享。并且华为NoF+方案已经同某些大型金融、运营商企业都进行了联合创新实践,为数据基础设施领域建设打开新格局。存储网络创新变革迈出万里长征第一步,面向未来,在我们持续投入的基础上也期待更多各行各业伙伴的加入。

来源:至顶网存储频道

好文章,需要你的鼓励

AGI-Next峰会全记录解读:Kimi、Qwen、智谱、腾讯同台,2026年有新范式是共识,中国引领AI概率最低预测2成

中国AI的一个挑战是:美国算力规模大1-2个数量级,且大量投入下一代Research,中国公司光交付就占据了绝大部分资源。

上海AI实验室让机器人“睁眼看世界“:用视觉身份提示技术让机械臂学会多角度观察

上海AI实验室联合团队开发RoboVIP系统,通过视觉身份提示技术解决机器人训练数据稀缺问题。该系统能生成多视角、时间连贯的机器人操作视频,利用夹爪状态信号精确识别交互物体,构建百万级视觉身份数据库。实验显示,RoboVIP显著提升机器人在复杂环境中的操作成功率,为机器人智能化发展提供重要技术突破。

Anthropic推出医疗健康功能助力患者理解病历记录

人工智能开发商Anthropic为其旗舰聊天机器人Claude推出新的医疗健康功能,用户现在可以与服务共享医疗记录以更好地了解自己的健康状况。Claude可以连接官方医疗记录和苹果健康等健身应用,进行更个性化的健康对话。新功能现已向美国的Claude Pro和Max订阅用户开放。公司强调该工具不用于诊断或治疗建议,而是帮助用户理解复杂医疗报告,为医患沟通做准备,并承诺严格保护用户隐私数据。

英伟达团队突破AI训练瓶颈:让机器人同时学会多种技能不再“顾此失彼“

英伟达研究团队提出GDPO方法,解决AI多目标训练中的"奖励信号坍缩"问题。该方法通过分别评估各技能再综合考量,避免了传统GRPO方法简单相加导致的信息丢失。在工具调用、数学推理、代码编程三大场景测试中,GDPO均显著优于传统方法,准确率提升最高达6.3%,且训练过程更稳定。该技术已开源并支持主流AI框架。

iOS 18新增游戏应用正式上线,专为iPhone游戏体验而生

Sleepbuds制造商Ozlo如何构建睡眠数据平台

CES 2026推出AI伴侣机器人Emily

苹果2026年将发布四款新iPhone机型预览

AGI-Next峰会全记录解读:Kimi、Qwen、智谱、腾讯同台,2026年有新范式是共识,中国引领AI概率最低预测2成

Anthropic推出医疗健康功能助力患者理解病历记录

Google推出通用商务协议,推动智能体购物自动化

核电初创公司携小型反应堆回归,面临重大挑战

谷歌针对部分医疗查询移除AI概览功能

Motional采用AI优先策略重启无人驾驶出租车计划

新年存储升级:三星SSD优惠最高减免100美元

OpenAI与软银联手投资10亿美元,助力星门项目能源伙伴发展