完美的AI存储方案在哪里:Facebook TRINO加上Netflix Iceberg

在解决规模化数据分析问题方面,很少有人在能力上可以与超大规模基础设施运营商相抗衡。也正因为如此,当初由Facebook(现在的Meta Platforms)和Netflix开发的技术组合,才很可能最终成为支持AI训练及其他应用“智能湖仓”的完美方案。

毫不奇怪,任何在构建高性能全闪存存储阵列、或者常用于HPC模拟/建模类应用的并行文件系统方面拥有从业经验的人都很清楚,这些设备正是存储大量数据、支撑AI神经网络训练的最佳选择。

而各大云巨头——特别是亚马逊云科技、微软Azure以及Google Cloud——都拥有自己的对象和文件存储系统,也在呼吁更多人选择它们来存储用于AI训练的原始数据;另外还有Snowflake,作为以SQL接口为主要卖点的云数据仓库宠儿,他们也在AI训练领域的存储市场上占据了一定的业务份额。

但必须强调的是,这些方案都不以开放见长,在本质上也不具备混合属性。具体来讲,它们与大家过去四十年间采购过的任何其他存储类型一样,都有着极强的专有性。我们并不是要反对专有技术,但其确实会限制自由度;而且跟开源工具相比,专有工具的易用性几乎总是跟成本直接挂钩。

总而言之,使用者必须付出代价。

最好的答案可能是构建大量闪存阵列,或者是从Pure Storage、Vast Data、戴尔科技或者其他OEM厂商处采购,再使用Trino及Iceberg组合进行加载。这两者都属于开源项目,也都能被加载至任何云环境的闪存实例之上。

Trino之前曾被称为PrestoSQL,是Facebook Presto项目的几个分支之一,项目最早可以追溯至2012年。Presto是一套本机分布式SQL引擎,旨在直接访问Hadoop分布式文件系统(HDFS)中存储的数据,顺应的正好是MapReduce数据分析时代风靡一时的“大数据”概念。Presto由Java语言编写而成,属于Hive SQL到MapReduce转换器的替代方案,并于2008年由Facebook推向开源,负责为存储在HDFS中的非结构化数据提供SQL查询功能。当初开放Presto时,Facebook表示其速度相当于Hive的10到15倍,这对任何需要将SQL引入HDFS的用户来说都不啻为一种福音。

PrestoDB的优点,在于它不仅不依赖于HDFS,甚至不依赖于任何特定的数据库、数据存储或者文件系统。它实际上只是一个SQL抽象层,可以指向任何内容并用于查询任何内容——也就是一个面向多种互不兼容的数据源的联合层。围绕PrestoDB也曾出现过不少利益争斗,最终只留下两家试图推动PrestoDB商业化的公司:其一是Ahana,其二则是Starburst。

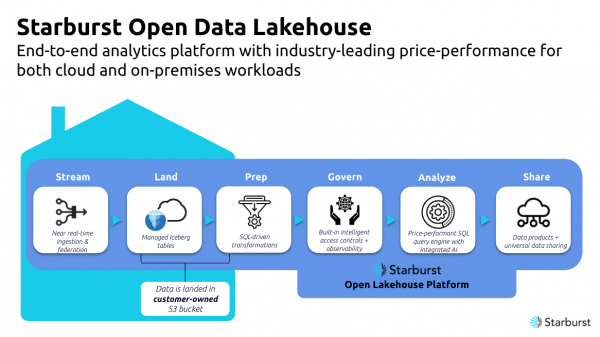

Ahana在几年间自行探索,推动了联合数据库的相关尝试,并最终于2023年4月被IBM收购。Starburst公司的联合创始团队中有多位来自Facebook Presto项目组的成员,这家公司也已经通过四轮风险融资筹得4.14亿美元。其产品主要针对Snowflake用户,经常暗示这部分消费者支出太多、得到的却太少,而且是将自主权拱手交给了他人的数据仓库。Starburst方面曾在采访中公开表示,其目标是“实现无需数据仓库的数据分析”,也就是直接查询数据所在位置、将结果纳入缓存。这样对于匹配这套系统的应用程序来说,缓存本身就相当于一套SQL数据库。

这不禁让我们想到Iceberg与Trino之间的爱恨纠葛,特别是随着AI客户努力为AI训练数据寻求更好的存储和访问方案,Starburst将这二者相结合推出的商业级技术成果已经获得了市场的良好认可。

Iceberg出自影视流媒体巨头Netflix之手,目的是取代Hive、Presto和Spark中内置的特殊表布局。在2017年初诞生之时,Iceberg希望提供统一的表格式,以保证与其他数据分析工具顺畅对接。就在Netflix公布后不久,该项目就通过Apache软件基金会完成了开源。现如今,Adobe、Airbnb、苹果、花旗银行、第一资本、Expedia、谷歌、LinkedIn、Lyft、Netflix、Pinterest以及Strpie等知名企业都在使用Iceberg。有趣的是,Iceberg的立足重点在于提供一种表文件格式,能够在不借助Hive、Presto及Spark等查询层的前提下直接使用SQL进行查询。

然而事实证明,Iceberg还能够对存储在HDFS或S3中的对象集合以及/或者以Parquet、Avro或Orc格式存储的文件集合进行抽象,这也使其成为Presto这类SQL查询引擎的理想伴侣。Iceberg将各种可通过SQL直接查询的数据制成逻辑表,且拥有关系数据库的ACID属性;另一边,Presto只是一套查询引擎,并不具备自己的原生存储格式。但如果大家希望构建较为传统的数据仓库,那么Trino加Iceberg的组合也相当不错。

最近,我们一直在询问很多存储供应商,应该使用什么样的存储来支撑AI训练类应用。针对这个问题,他们给出了不同的答案——首先是相当热门的向量数据库与图数据库,此外还有常见于超大规模应用的Parquet与Avro文件存储。在我们看来,对于拥有数千甚至几万个数据库表、用于支撑成百上千种应用软件的企业客户来说,一个能够在联合数据库上运行的高级SQL驱动接口无疑非常重要。这才是真正符合企业级AI训练应用的解决方案。另外我们还认为,客户需要较低级别的访问来提高速度和性能——可能类似于Parquet。使用SQL从来源处提取数据会产生性能损失,而优点就是简单易用。

Starburst公司首席执行官Justin Borgman在采访中表示,“我们Starburst也正是秉承着这样的理念,希望将Trino与Iceberg合并起来。我们希望以此为基础明确自身在AI领域所扮演的角色,希望成为访问层、希望为客户提供模型训练所必需的数据。模型的质量直接取决于相应的训练数据。我们发现,特别是在企业客户群体当中,大家更希望利用自有数据开展模型训练。从他们的角度出发,ChatGPT只是个噱头——他们必须使用自己拥有的专有数据来训练模型,而这些数据往往处于大型数据湖或者纷繁复杂的数据源当中。而我们可以访问这一切,所以能够帮助他们获取推进AI项目所需要的数据资源。”

其中另有一项诀窍,就是必须谨慎选择训练数据。企业客户既需要充足的训练数据,又不必尝试从每个关系数据源中提取全部数据以基于特定任务训练AI模型。Borgman表示,在这种情况下,使用SQL接口进行数据过滤实际上效果拔群。

此外,事实也证明Iceberg已经成为众多企业的首选格式。也就是说如果大家希望保留数据以供后续快速AI训练,则可以使用Trino提取数据并将结果存储成Iceberg表的形式。

为此,Starbrust正在打造自己的Icehouse发行版,尝试将Trino(实际是其商业版本,名为Galaxy)与Iceberg结合起来,并直接由Starburst对这套组合提供支持。Galaxy是一套完整的数据智能湖仓实现,其中包含Warp Speed索引与缓存层,外加其他新增安全与性能设计。

有趣的是:就连Snowflake自己也开始在其云数据仓库当中支持Iceberg,基本理由也大致相同。但此举可能会产生意想不到的后果。

Borgman解释道,“Snowflake实际上已经开始关注Iceberg,并表示将提供查询这种外部表的能力。而我们看到的变化过程大致是这样的:他们的现有客户基本上都希望能转向Icerberg,想要用这种方式摆脱供应商锁定。我们当然乐见其成,因为这意味着他们将拥有更多新的分析选项,也给我们的产品推广带来了新的机会。”

Borgman还提到,使用Trino加Iceberg构建数据智能湖仓的成本,只相当于使用Snowflake的十分之一到二分之一。

对于希望在Iceberg中获得商业级支持的客户,Netflix Iceberg项目的缔造者Ryan Blue和Dan Weeks专门创办了一家名叫Tabular的公司。这家公司目前拥有几十名员工,专注于数据摄取、表维护和基于角色的访问控制等Iceberg功能。相比之下,拥有500多名员工的Starburst明显体量更大,业务范围也同样涵盖SQL引擎以及Iceberg。

未来,Starburst也许会收购Tabular以整合这波技术合并努力。但只要Blue和Weeks还能依靠销售包含技术支持的Iceberg版本自给自足,就没有理由接受这样的收购要约。而且如果有两家公司同时为Iceberg提供支持,项目的风险也将被摊薄。没准Tabular还会尝试在其Iceberg发行版之上提供Trino支持层,那样AI训练领域的存储生态将会更加丰富多彩。

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。

稚晖君发布全球最小全身力控人形机器人,上纬启元开启个人机器人时代

2026年软件定价大洗牌:IT领导者必须知道的关键变化

Linux 在 2026 年将势不可挡,但一个开源传奇可能难以为继

CES 2026趋势展望:全球最大科技展五大热门话题预测

人工智能时代为何编程技能比以往更重要

AI颠覆云优先战略:混合计算成为唯一出路

谷歌发布JAX-Privacy 1.0:大规模差分隐私机器学习工具库

谷歌量子AI发布新型优化算法DQI:量子计算优化领域的重大突破

缓解电动汽车里程焦虑:简单AI模型如何预测充电桩可用性

Titans + MIRAS:让AI拥有长期记忆能力

Gemini为STOC 2026大会理论计算机科学家提供自动化反馈

夸克AI眼镜持续升级:首次OTA,支持89种语言翻译