Stable Video Diffusion作为生成式视频工具,应用前景待观望! 原创

AI生成视频正在热烈的研究和应用中,文生视频、图像生视频带来的新鲜感和动态感,受到大家广泛关注。通过生成式AI视频工具,你说一段描述,自动生成相应的视频。你还可以选择一张图片,也能实现将静止图像转化为动态视频,让文字和图片瞬间活起来。

今天来介绍一款Stability AI 发布的基于人工智能的视频生成工具Stable Video Diffusion,它可以根据用户提供的文本描述或图片,自动生成高质量的视频内容。

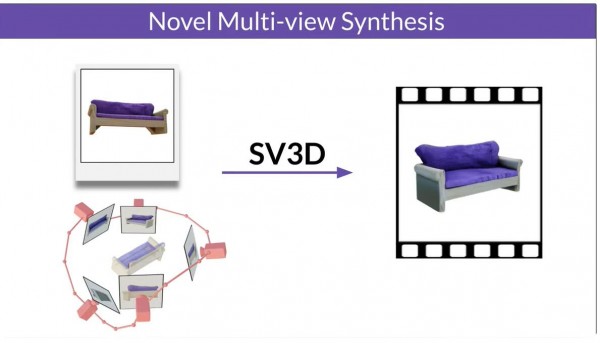

Stable Video Diffusion 是 Stability AI 发布的基于图像模型 Stable Diffusion 生成视频的基础模型。它是一个先进的生成式 AI 视频模型。Stable Video Diffusion 可以适应各种下游任务,包括从单一图像进行多视角合成和在多视角数据集上进行微调。Stable Video Diffusion 是 Stability AI 多样化开源模型系列的一部分,涵盖图像、语言、音频、3D和代码。

目前Stable Video Diffusion 的代码已在 Stability AI 的 GitHub 仓库中提供。运行模型所需的权重可以通过他们的 Hugging Face 页面访问。我们从技术原理、产品特点以及使用体验来说明一下Stable Video Diffusion的发展现状。

从技术原理上讲,Stable Video Diffusion提出了将潜在视频扩散模型扩展到大型数据集的稳定视频扩散模型,这是一种用于高分辨率、最先进的文本到视频和图像到视频生成的潜在视频扩散模型。通过插入时间层并在小型高质量视频数据集上对其进行微调,为2D图像合成训练的潜在扩散模型已转换为生成视频模型。基于该模型Stable Video Diffusion目前确定并评估了视频LDM成功训练的三个不同阶段:文本到图像预训练、视频预训练和高质量视频微调。

从产品特点看,除了文本到视频和图像到视频的生成,还支持多帧生成。Stable Video Diffusion提供了两种图像到视频的模型形式,支持14或25帧的视频生成,分辨率高达576 x 1024。用户可以根据自己的需求选择适合的帧率,从而决定视频的流畅度。高分辨率保证了视频的清晰度,让细节得以呈现。同时其提供的帧插值技术可以在帧数较少的情况下,使视频看起来更加平滑。Stable Video Diffusion还支持3D场景生成,目前该功能同时容纳了单个图像和轨道视图,允许沿着指定的相机路径创建3D视频。能够生成更具空间感的视频。Stable Video Diffusion提供了更精细的摄像机控制功能。通过LoRA控制摄像机,用户可以精确控制摄像机的位置和角度,从而实现更加精细的视频创作。

如何使用呢?首先访问Stable Video Diffusion的官方网站,下载本地一键整合包。按照安装向导的指示完成安装过程。安装完成后,打开本地一键整合包。在界面中选择“文本到视频”或“图像到视频”功能,根据您的需求进行选择。我们以图片转视频为例,选择一张静态图片作为输入。图片的质量高生成的视频视觉效果更好。然后设置视频参数包括视频的帧率、分辨率等参数。Stable Video Diffusion支持14或25帧的生成,分辨率为576 x 1024。点击“生成”按钮,等待一些时间生成视频。生成完成后,选择“导出”选项,将视频保存到您指定的文件夹中。生成时间各不相同,但在 V100 GPU 上通常约为 2 分钟。

使用体验来看,Stable Video Diffusion作为AI视频生成工具,其特点包括本地一键整合包的使用,简化了工具使用流程,提高了视频创作效率,其生成的视频也较为高质量。但是目前看也有局限性,首先从模型来看,视频扩散模型的采样速度通常很慢,并且对VRAM的要求很高。尽管潜在方法提供了效率优势,但一次生成多个关键帧在训练和推理过程中都是昂贵的。

其次长视频合成方面存在一些根本性的缺点,生成的视频相当短,不到四秒,无法实现完美的逼真度。还可能会生成没有运动的视频,或者相机平移速度非常慢。通常可能无法正确生成人脸和人物。对文本的理解也有缺憾。

来源:至顶网存储频道

好文章,需要你的鼓励

Queen‘s大学重磅研究:程序员的角色即将彻底改变,从码农到智能体指挥官

Queen's大学研究团队提出结构化智能体软件工程框架SASE,重新定义人机协作模式。该框架将程序员角色从代码编写者转变为AI团队指挥者,建立双向咨询机制和标准化文档系统,解决AI编程中的质量控制难题,为软件工程向智能化协作时代转型提供系统性解决方案。

苹果发布 iOS 26.0.1 系统更新,修复多项关键问题

苹果在iOS 26公开发布两周后推出首个修复更新iOS 26.0.1,建议所有用户安装。由于重大版本发布通常伴随漏洞,许多用户此前选择安装iOS 18.7。尽管iOS 26经过数月测试,但更大用户基数能发现更多问题。新版本与iPhone 17等新机型同期发布,测试范围此前受限。预计苹果将继续发布后续修复版本。

医疗AI的“显微镜革命“:西北工业大学团队发布首个超声影像专用智能助手EchoVLM

西北工业大学与中山大学合作开发了首个超声专用AI视觉语言模型EchoVLM,通过收集15家医院20万病例和147万超声图像,采用专家混合架构,实现了比通用AI模型准确率提升10分以上的突破。该系统能自动生成超声报告、进行诊断分析和回答专业问题,为医生提供智能辅助,推动医疗AI向专业化发展。

业界首款符合AEC-Q200标准额定电压高达1,000 VDC高压保险丝

数据中心的智算挑战,英特尔要如何应对?

下一代智能工厂怎么建?开放自动化给出“解题思路”

跟随西门子,在工博会感受沉浸式的工业AI体验

苹果发布 iOS 26.0.1 系统更新,修复多项关键问题

OpenAI将发布类似TikTok的社交应用,搭配Sora 2视频模型

微软推出Office智能体模式让用户"氛围办公"

AI助手现在能帮你创建高质量Word文档和Excel表格

高通新一代骁龙平台将推动智能体AI时代到来

SAPx阿里云,开启一条通往中国市场与全球化发展的全新路径

微软推出"氛围工作"模式,为Office套件加入AI智能体

OpenAI推出智能购物系统挑战谷歌亚马逊