韩国公司Panmnesia推出比RDAM快三倍的CXL内存池

韩国科技公司Panmnesia在2023年的Flash Memory Summit上展示了其集中式CXL内存系统。在一次现场演示中,该系统在运行Meta推荐应用程序时展示了比基于RDMA的系统快三倍以上的性能指标。

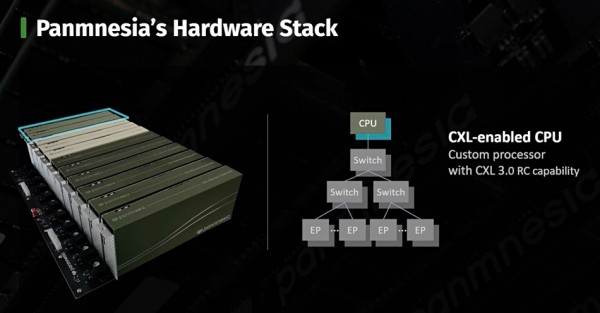

这项CXL技术是与位于大田的韩国科学技术研究院(KAIST)合作开发的。Panmnesia已经打造了一个包括CXL CPU、交换机和内存扩展器模块的全面CXL框架。该框架拥有基于DIMM的6TB容量的CXL内存。该公司的策略是将其CXL硬件和软件知识产权产品推向CXL系统开发商和制造商。

Panmnesia的首席执行官Myoungsoo Jung博士表示:“我们很高兴能在今年的Flash Memory Summit上介绍我们创新的多TB全系统CXL框架。通过我们的CXL IP,我们致力于开拓尖端解决方案,相信这将显著提升数据中心的内存和存储能力。”

这个演示系统的容量比同样在FMS 2023展示的基于2TB三星/MemVerge的池式内存系统大三倍。

Panmnesia硬件

Panmnesia框架系统机箱有两个CXL CPU模块(如上图所示)、三个颜色较浅的CXL交换机模块和六个1TB内存模块或CXL端点控制器,形成一个统一的DIMM池。

在软件方面,该系统运行在Linux上,由CXL硬件设备驱动程序、虚拟机子系统和CXL优化的用户应用程序组成。有趣的是,虚拟机软件组件在内存空间中创建了一个无CPU的NUMA节点。

Panmnesia软件

一个视频幻灯片展示了这个CXL框架系统在类似Meta推荐应用程序的电影推荐应用中的性能。 这再次与没有添加外部内存的服务器和基于RDMA的替代方案进行了比较。

Panmnesia 与RDMA的比较

视频从加载用户和项目数据(在张量初始化期间)开始,随后使用机器学习模型进行电影推荐。Panmnesia系统完成任务的速度 是RDMA系统的3.32倍。

Panmnesia系统的另一个好处是它的模块化;内存模块中的DIMM可以被替换,可以使用更大容量的DIMM来扩展内存容量,而不需要增加额外的内存模块。

好文章,需要你的鼓励

Lumen升级400GB数据中心连接基础设施助力AI发展

Lumen Technologies对美国网络的数据中心和云连接进行重大升级,在16个高连接城市的70多个第三方数据中心提供高达400Gbps以太网和IP服务。该光纤网络支持客户按需开通服务,几分钟内完成带宽配置,最高可扩展至400Gbps且按使用量付费。升级后的网络能够轻松连接数据中心和云接入点,扩展企业应用,并应对AI和数据密集型需求波动。

阿里巴巴突破AI说话人视频生成技术壁垒:首次实现动作自然度、唇同步准确性和视觉质量的完美平衡

阿里巴巴团队提出FantasyTalking2,通过创新的多专家协作框架TLPO解决音频驱动人像动画中动作自然度、唇同步和视觉质量的优化冲突问题。该方法构建智能评委Talking-Critic和41万样本数据集,训练三个专业模块分别优化不同维度,再通过时间步-层级自适应融合实现协调。实验显示全面超越现有技术,用户评价提升超12%。

AI和流媒体推动,2030年面临“网络危机“

RtBrick研究警告,运营商面临AI和流媒体服务带宽需求"压倒性"风险。调查显示87%运营商预期客户将要求更高宽带速度,但81%承认现有架构无法应对下一波AI和流媒体流量。84%反映客户期望已超越网络能力。尽管91%愿意投资分解式网络,95%计划五年内部署,但仅2%正在实施。主要障碍包括领导层缺乏决策支持、运营转型复杂性和专业技能短缺。

UC Berkeley团队突破AI内存瓶颈:让大模型推理快7倍的神奇方法

UC Berkeley团队提出XQUANT技术,通过存储输入激活X而非传统KV缓存来突破AI推理的内存瓶颈。该方法能将内存使用量减少至1/7.7,升级版XQUANT-CL更可实现12.5倍节省,同时几乎不影响模型性能。研究针对现代AI模型特点进行优化,为在有限硬件资源下运行更强大AI模型提供了新思路。

AI和流媒体推动,2030年面临"网络危机"

Pine64停产Pro手机转向RISC-V业务

日立Vantara将VSP One块存储扩展至Azure云平台

Finchetto光学数据包交换机:光无法存储的技术挑战与突破

Python开发者调查显示增长强劲,但基金会资金面临困境

多站点IT基础设施升级指南:告别VMware的替代方案

戴尔集成Elasticsearch与英伟达Blackwell GPU升级AI数据平台

Confluent Cloud为智能体提供实时数据流处理能力

数字化转型失败的6个警示信号

OpenAI CEO阿尔特曼承认当前处于AI泡沫期

英伟达发布全新小型开源模型Nemotron-Nano-9B-v2,支持推理开关控制

谷歌翻译将集成AI功能并增加游戏化学习模式

AMD Versal家族再添新成员 ——打破AI内存桎梏 支持CXL 3.1

AI网络背景下RDMA的Why,What & How

国际高性能计算和人工智能咨询委员会第11届亚太区RDMA编程竞赛结果揭晓

韩国公司Panmnesia推出比RDAM快三倍的CXL内存池

国际高性能计算和人工智能咨询委员会举办的第十届亚太区RDMA编程赛结果出炉

英特尔退出傲腾存储业务,传统金字塔架构不灵了?

搭载第四代自研神龙架构 阿里云发布RDMA增强型实例等多款新品

国际高性能计算与人工智能咨询委员会第9届亚太区RDMA编程竞赛圆满落幕

国际高性能计算与人工智能咨询委员会宣布举办第九届亚太区高级RDMA编程研讨会和竞赛

HPC-AI咨询委员会宣布启动第七届亚太区大学生RDMA编程挑战赛招募