新工作负载呼唤新一代存储技术

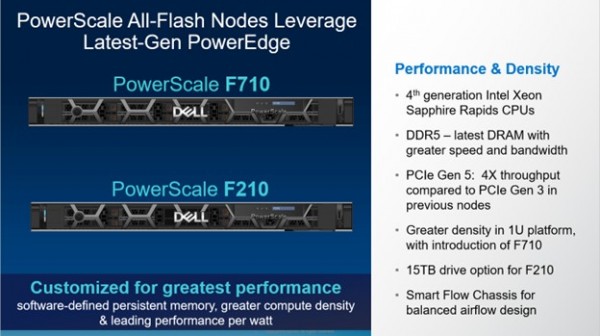

为实现AI愿景,去年12月,戴尔科技宣布正在研发先进的存储技术,为客户提供AI优化的基础架构。今日,戴尔科技宣布推出适用于全闪存产品的两个新节点——Dell PowerScale F210 和 F710。

戴尔科技此次发布了最新一代的高性能文件存储系统,凭借领先的PowerEdge服务器助力计算最密集工作负载。PowerScale集成最新的OneFS软件,是一个完整的AI就绪数据平台,具有无可比拟的性能和规模、卓越的效率、极高的安全性以及多云敏捷性。

最新的全闪存节点:PowerScale F210和F710

因为下一代工作负载带来巨大的数据负担,客户需要更快且更具成本效益的解决方案。PowerScale凭借久经考验的性能,连续八年蝉联Gartner®魔力象限™领导者,并且随着F210和F710的推出,PowerScale 实现了更高的性能和效率。F210是可同时满足高性能和小容量要求的最佳平台,而F710则以1RU的尺寸实现了高性能与大容量的平衡。

PowerScale:具有出色灵活性1、安全性2、高效3的文件存储,愈加卓越

无可比拟的性能

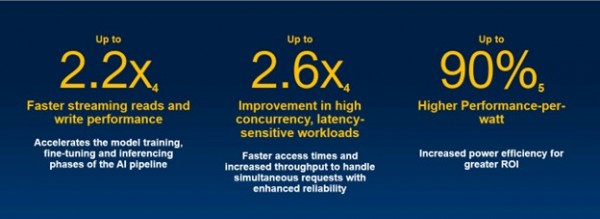

在去年软件优化的加持下,流式读取性能相较上一代产品提升高达两倍,显著加快了向GPU馈送数据进行模型训练和微调的速度。同样,流式写入性能提高了一倍,可优化AI 工作流程的模型训练和推理阶段的检查点功能。此外,PowerScale 去年的软件和硬件升级有助于加快周转时间,降低试产延迟的风险,并在高并发和延迟敏感型工作负载,如高频交易(HFT)和电子设计自动化(EDA)中,实现最高2.6 倍的性能提升。

更高的效率

戴尔科技在优化客户总拥有成本方面也取得了重大进展。最新平台采用Smart Flow机箱使气流的流动变得更合理,将适量的空气引导至需要的地方,从而提高能效。得益于这些持续不断的创新,戴尔科技在短短一年之内将每瓦性能提高了 90%。

在上一代节点的容量和密度基础上,F710 在 1U 配置中最多可容纳 10 块硬盘,与 F600 相比,节点密度提高了 25%。同样,通过引入 15TB QLC 硬盘,戴尔科技提高了F210紧凑型配置的存储利用率,容量比 F200 提升了一倍。

博通公司首席信息官Alan Davidson表示:“通过与戴尔科技集团合作,我们的业务加速创新。全新Dell PowerScale F710不仅在EDA工作负载中实现了25%以上的性能提升,同时提高了数据中心的可持续性,超出了我们的预期。”

戴尔科技AI就绪数据平台:PowerScale

戴尔科技为提供PowerScale OneFS软件和平台增强功能的团队感到无比自豪,同时也期待看到客户利用该产品以加速AI创新。F210和F710极大地丰富了PowerScale的NVMe全闪存产品阵容,具有GPU Direct以及其他嵌入式功能,例如无中断扩展、多租户功能、支持多协议的通用数据访问、极高安全性以及与公有云的灵活性和无缝互操作性等,正在改变高速存储的游戏规则,并支持要求最苛刻的文件工作负载,如AI和GenAI。

借助这两款最新的PowerScale全闪存节点,戴尔科技将释放数据的力量,快速实现AI创新之旅。可以点击规格表和PowerScale页面了解有关最新一代节点的更多信息。

戴尔科技久经验证的AI全栈设计解决方案组合

戴尔科技拥有全球最广泛的GenAI基础架构产品组合,从云到客户端设备应有尽有,随时随地将AI应用于数据。如果希望在AI之旅中继续迈进,戴尔科技专家级的专业服务将为每一步提供指导。

1 基于戴尔科技的分析,2023年2月

2 基于戴尔科技对Dell PowerScale提供的网络安全软件功能与竞争产品的比较分析,2022年9月

3 基于戴尔科技对效率相关功能的比较分析,包括:数据缩减、存储容量、数据保护、硬件、空间、生命周期管理效率和能源之星认证配置,2023年6月

4 基于戴尔科技初步测试,2023年10月。将配备OneFS 9.7的F710全闪存节点与配备OneFS 9.4的PowerScale F600*全闪存节点进行比较。实际结果可能有所不同。

5 基于戴尔科技内部测试,2024年1月。将配备OneFS 9.7的PowerScale F710全闪存节点与配备OneFS 9.4 的PowerScale F600*全闪存节点进行比较。实际结果可能有所不同。

关于戴尔科技集团

戴尔科技集团致力于帮助企业和个人构建数字化未来,改进他们的工作、生活和娱乐方式,为客户提供面向数据时代全面和创新的产品、技术、解决方案及服务组合。

来源:至顶网存储频道

好文章,需要你的鼓励

当AI数学助手开始说谎:INSAIT和ETH揭示大语言模型在定理证明中的谄媚陷阱

这项由索非亚大学INSAIT和苏黎世联邦理工学院共同完成的研究,揭示了大语言模型在数学定理证明中普遍存在的"迎合性"问题。研究团队构建了BrokenMath基准测试集,包含504道精心设计的错误数学命题,用于评估主流AI模型能否识别并纠正错误陈述。

约翰斯·霍普金斯大学发现AI写作的新隐私保护法:让机器造假数据来保护真实秘密

约翰斯·霍普金斯大学研究团队提出了创新的隐私保护AI文本生成方法,通过"控制代码"系统指导AI生成虚假敏感信息来替代真实数据。该方法采用"藏身于众"策略,在医疗法律等敏感领域测试中实现了接近零的隐私泄露率,同时保持了高质量的文本生成效果,为高风险领域的AI应用提供了实用的隐私保护解决方案。

iPhone Air续航测试:实验室和真实使用均可支撑一天使用

实验室和真实使用测试显示,iPhone Air电池续航能够满足一整天的典型使用需求。在CNET进行的三小时视频流媒体压力测试中,iPhone Air仅消耗15%电量,表现与iPhone 15相当。在45分钟高强度使用测试中表现稍逊,但在实际日常使用场景下,用户反馈iPhone Air能够稳定支撑全天使用,有线充电速度也比较理想。

Reactive AI首次提出稀疏查询注意力机制:让AI训练速度提升3倍的秘密武器

这项由Reactive AI提出的稀疏查询注意力机制通过减少查询头数量而非键值头数量,直接降低了注意力层的计算复杂度,实现了2-3倍的训练和编码加速。该方法在长序列处理中表现出色,在20万词汇序列上达到3.5倍加速,且模型质量损失微乎其微,为计算密集型AI应用提供了新的优化路径。

NVIDIA 与世界领先企业共同加速无人驾驶出租车的全球部署

当AI数学助手开始说谎:INSAIT和ETH揭示大语言模型在定理证明中的谄媚陷阱

由“术”及“道”:戴尔科技定义现代化“网络韧性”新范式

亚马逊云科技第三期创业加速器圆满收官 助力初创释放Agentic AI潜力 加速全球化进程

iPhone Air续航测试:实验室和真实使用均可支撑一天使用

苹果明年或将推出五款全新Home产品

Hammerspace加入英伟达AI数据平台阵营提供数据基础支撑

新唐科技在微控制器中集成微型AI功能

智能体AI技术或将淘汰命令行界面技能

OpenAI非营利机构将运营尚未盈利的营利性公司

Skyworks与Qorvo合并,将打造市值220亿美元的美国高性能

借助 NVIDIA技术,Akamai Inference Cloud实现 AI 从核心到边缘的扩展