鏖战双11 必看巨量引擎双11作战全景图

双11在即,早布局的商家,得先机。如何成为大促中的赢家?很多商家都已经开始谋划:

· 都在想种草,那种草如何更高效,甚至带动全域的销量攀升?

· 年年双11大促,电商都有行业爆款,我的爆款什么时候能出现?

· 大促流量争夺,新的流量蓝海到底在哪里?

鏖战双11,在抖音双11好物节的布局,必不可少。到底巨量引擎这次有哪些新玩法?话不多说,先收下这份最最最最最最全的双11作战全景图!

为了让商家“抢先解锁新增量”,巨量引擎率先发布了丰富的大促策略和激励政策:以“人群、货品、流量”三大营销势能,帮助商家在大促中找到更多增长可能。

势能1:人群做稳三波种草,全面促收

大促成交,主要集中在三个时间点爆发:10月中旬、10月下旬以及11月初到双11当天。集群效应明显的决策周期背后,是值得深入研究的消费者习惯。

巨量引擎根据用户需求变化,探索消费者最新驱动因素,结合商家经营目标,聚焦双11全周期,详细解读不同波段的客群消费路径,并推出“三波段种收策略”。

第一波:做好种收(10.9-10.19)“抢量CP”电商开屏 x IP + 深种链路“星推搜直”

要有交易,先要有交情,大促爆发前的种草蓄水成为斩获好感的重点动作。品牌商家可以在这一阶段加大曝光力度,借助爆品种草激活老客的同时拓展新客。

为此,巨量引擎双11推出“抢量CP”组合及“星推搜直”链路,助力商家极致种草。

“抢量CP”,包含“开屏”+“IP”两大类曝光利器。这种组合能够独占高价值人群,保障商家在双11前期拥有绝对优势的曝光,提前吸引用户目光。

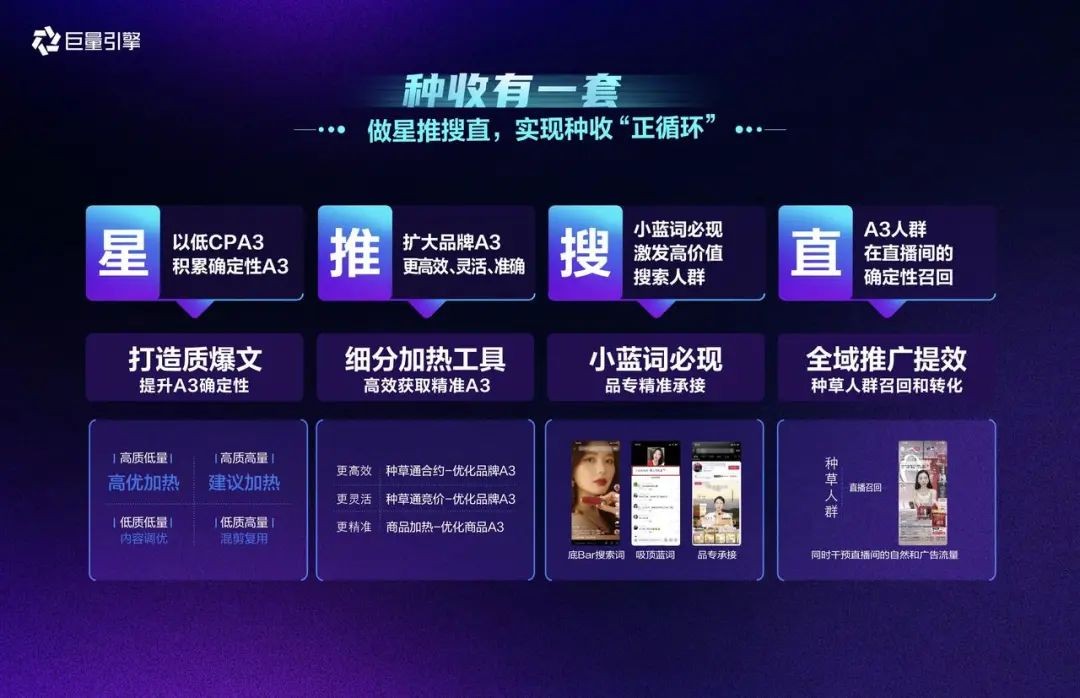

除此之外,巨量引擎首推的“星推搜直”种收链路,提供了种收一体的产品链路解决方案:

「星推搜直」以A3人群为轴心,通过星图、热推、搜索、直播,四大产品全新组合,构成了提升种收确定性的营销链路,大大降低种草成本。

第二波:做好预售(10.20-10.30)用好预售激励+推广,做好尾款追踪

预售期,是大促正式开启的阶段,抖音今年10月20日就开启预售环节,真正做到了抢跑全渠道,且针对预售做了能力升级:

(1)新增全款预售投放工具,包括千川短视频推广、商品卡推广、商品加热、随心推-商品购买在内的投放工具均支持全款预售;

(2)升级尾款催付能力,对消费者大促期间决策链路进行全方位锁定。

第三波:全域转化(10.31-11.11)三大场域,全周期“流量+红包补贴”

在第三阶段,巨量引擎鼓励商家联动货架场、内容场及站外三大场域,360度饱和覆盖用户在抖音的购买场景。

巨量千川、商城搜索、原生广告等各个产品均为商家提供全周期激励政策,让商家从抖音域内到域外,实现全域破峰。

势能2:货品分级打爆货品,领跑大促

在今年的双11大促中,巨量引擎主张针对不同的货品进行分层运营:商家可以根据自己商品的属性对应选择合适的权益体系,此次针对货品,抖音电商重点推出货品扶持计划,通过赛马制,从10000个品中优选出3500个,给到重磅四重资源扶持,为重点商品保驾护航。

在新品支持方面,不少商家期待借助双11大促契机打出爆款。为此,巨量引擎提出了“双11新品打爆方法论”,提供从新品企划、上新种草到转化爆发的完整周期全链路营销方案。

势能3:流量抓住新流量机会,加速大促

抓住新的流量,就等于有了新的机会。本次双11,巨量引擎也鼓励商家更多使用包含商品卡、随心推图文、短剧等在内的“新体裁、新流量和新内容”。

尤其是在挖掘自然流量的部分,巨量引擎全新推出全域推广产品,它能在更大的流量池中为直播间找到更高意向付费人群,让抖音的投放从局部最优升级到全局最优,持续带动品牌全渠道生意增长。

好生意,先人一步!

制胜双11,巨量引擎「星推搜直」全新种收链路、新品扶持计划、巨量千川双11激励等多样化工具和大促玩法,都将成为你的制胜法宝。

来源:业界供稿

好文章,需要你的鼓励

Allen AI团队推出SAGE:首个能像人类一样“想看多长就看多长“的智能视频分析系统

Allen AI研究所联合多家顶尖机构推出SAGE智能视频分析系统,首次实现类人化的"任意时长推理"能力。该系统能根据问题复杂程度灵活调整分析策略,配备六种智能工具进行协同分析,在处理10分钟以上视频时准确率提升8.2%。研究团队创建了包含1744个真实娱乐视频问题的SAGE-Bench评估平台,并采用创新的AI生成训练数据方法,为视频AI技术的实际应用开辟了新路径。

联想推出DE6600系列:更智能的存储解决方案

联想推出新一代NVMe存储解决方案DE6600系列,包含全闪存DE6600F和混合存储DE6600H两款型号。该系列产品延迟低于100微秒,支持多种连接协议,2U机架可容纳24块NVMe驱动器。容量可从367TB扩展至1.798PiB全闪存或7.741PiB混合配置,适用于AI、高性能计算、实时分析等场景,并配备双活控制器和XClarity统一管理平台。

AI视觉模型真的能看懂长篇文档吗?中科院团队首次揭开视觉文本压缩的真相

中科院团队首次系统评估了AI视觉模型在文本压缩环境下的理解能力,发现虽然AI能准确识别压缩图像中的文字,但在理解深层含义、建立关联推理方面表现不佳。研究通过VTCBench测试系统揭示了AI存在"位置偏差"等问题,为视觉文本压缩技术的改进指明方向。

数智时代,openGauss Summit 2025即将发布哪些技术创新破局

“算力+储能”深度融合:超智算发布分布式算力超级节点储能解决方案

联想推出DE6600系列:更智能的存储解决方案

创业公司如何在严格监管行业中实现生死攸关的创新

OpenAI发布GPT-5.2-Codex模型,软件工程自动化能力大幅提升

Waterfox浏览器宣布拒绝AI功能,瞄准Firefox忠实用户

TikTok美国业务出售交易将于下月完成

破局AI数据中心安全瓶颈:Fortinet联合NVIDIA引领隔离式加速新航向

智算中心进化论,科华数据如何做到“更懂”

更高负载、更快建设:2026年数据中心六大趋势

Snowflake数据库更新引发全球大规模服务中断

AI编程初创公司Lovable融资3.3亿美元,英伟达等科技巨头支持