HPE公布Alletra品牌:统驭旗下一切存储产品

HPE计划将众多存储产品和服务纳入六个品牌,借此简化自家产品组合。

这项计划将在未来三年内逐步实施落地,HPE公司执行副总裁兼首席营销官Jim Jackson已经在博文中给予确认。Jackson在HP/HPE拥有22年的资深工作经验,他也非常理解客户在面对纷繁复杂的产品与服务名称时那种困惑与无力感。

“在HPE,我们正努力通过单一集成平台交付高度一致的客户体验,全面统筹HPE和HPE GreenLake的边缘到云平台各品牌。”

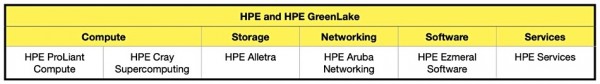

此次品牌结构调整将把如今的29个产品和服务品牌,简化成两个计算品牌,外加存储、网络、软件和服务品牌各一个。

HPE品牌调整计划

最终选定的品牌包括计算领域的ProLiant和Cray,存储领域的Alletra,网络领域的Aruba,软件领域的Ezmeral以及服务领域的HPE。除此之外的其他现有品牌都将做相应更名。

“为了最大限度减少品牌调中的干扰,我们将在未来三年左右内通过业务流程逐步实施这些变革。在推出新产品,或者改变现有产品的价值主张时,我们将应用新的品牌架构和命名策略。当现有产品达到使用寿命终点时,我们会淘汰其品牌名称。”

在存储领域,HPE目前拥有Alletra品牌、Simplivity HCI产品和Storeonce(配备InfoSight云管理工具的重复数据删除备份设备)。Simplivity和StoreOnce在各自产品领域都算不上市场领先,Jackson在博文中表示这些品牌名称的后续使用周期最多不会超过三年。

至于OEM形式生产的日立Vantara VSP 5000(作为高端XP8阵列销售,主要以PowerMAX为竞争对手)并不在HPE的关注范围之内。毕竟这款产品在HPE官网上存在感并不强,只在用户搜索后会显示相关条目。HPE于2021年10月发布了第二代XP8,而日立Vantara的VSP软件也已能够运行在公有云上。相信在日立发布第三代VSP 5000时,HPE才会最终决定XP8产品的未来命运。

Alletra品牌包含Alletra 9000、6000、5000、4000和dHCI等产品,具体又分为Primera(9000)、Nimble(6000、5000和dHCI)以及Apollo数据服务器(4000)等子品牌。

GreenLake存储服务同样囊括诸多品牌,包括HPE GreenLake旗下的文件存储、块存储、Alletra存储、HCI、灾难恢复、备份与恢复等多个子系列。其中文件存储和块存储服务实际运行在Alletra Storage MP硬件上。

Jackson明显不打算直接给Simplivity、StoreOnce和InfoSight等品牌直接安个Alletra前缀。从这个角度看,HPE似乎会继续使用当前名称,等待各产品的生命周期走向终点。

从某种意义上看,HPE此举似乎是在效法戴尔。在收购EMC之后,戴尔也简化了自己的存储品牌,用一块Power金字招牌囊括了一系列戴尔和EMC存储产品(包括VMAX、Data Domain和Isilon等)。如今大家所熟知的PowerMAX、PowerProtect和PowerScale等正是由此而生。IBM也曾对自家存储软件产品开展过品牌统一改革,将Spectrum品牌调整为IBM Storage。

Jackson总结称,“通过削减品牌数字并辅以描述性命名,我们将帮助客户更易了解哪些产品和服务更适合他们的需求,弄清哪些产品和服务之间可以搭配使用,还有其对应的自然升级路径是什么。”

好文章,需要你的鼓励

AI工作负载两年内将主导数据中心建设

Turner & Townsend发布的2025年数据中心建设成本指数报告显示,AI工作负载激增正推动高密度液冷数据中心需求。四分之三的受访者已在从事AI数据中心项目,47%预计AI数据中心将在两年内占据一半以上工作负载。预计到2027年,AI优化设施可能占全球数据中心市场28%。53%受访者认为液冷技术将主导未来高密度项目。电力可用性成为开发商面临的首要约束,48%的受访者认为电网连接延迟是主要障碍。

史丹佛团队让AI“法官“来挑选最佳素材:多模态嵌入学习的全新突破

MiroMind AI等机构联合研究团队提出了UniME-V2多模态嵌入学习新方法,通过让大型多模态语言模型充当"智能法官"来评估训练样本质量,解决了传统方法在负样本多样性和语义理解精度方面的问题。该方法引入软标签训练框架和困难负样本挖掘技术,在MMEB基准测试中取得显著性能提升,特别在组合式检索任务上表现出色,为多模态AI应用的准确性和用户体验改进提供了重要技术支撑。

AWS投资500亿美元为美国政府建设AI基础设施

亚马逊云服务宣布投资500亿美元,专门为美国政府构建AI高性能计算基础设施。该项目将新增1.3千兆瓦算力,扩大政府机构对AWS AI服务的访问,包括Amazon SageMaker、Amazon Bedrock和Claude聊天机器人等。预计2026年开工建设。AWS CEO表示此举将彻底改变联邦机构利用超级计算的方式,消除技术障碍,助力美国在AI时代保持领先地位。

南洋理工大学团队推出Uni-MMMU:让AI模型学会“边看边想边画“的全能基准测试

南洋理工大学团队开发了Uni-MMMU基准测试,专门评估AI模型的理解与生成协同能力。该基准包含八个精心设计的任务,要求AI像人类一样"边看边想边画"来解决复杂问题。研究发现当前AI模型在这种协同任务上表现不平衡,生成能力是主要瓶颈,但协同工作确实能提升问题解决效果,为开发更智能的AI助手指明了方向。

AI工作负载两年内将主导数据中心建设

AWS投资500亿美元为美国政府建设AI基础设施

微软发布Fara-7B智能体模型,可在PC端本地运行控制计算机

Monday.com:AI技术助力解决现代工作效率危机

Google联手Accel寻找印度下一代AI突破企业

数据价值化之上,东软目标做智能世界的“可靠伙伴”

微软CEO萨提亚:Excel为什么40年不倒?因为它是世界上最平易近人的编程环境,如果企业没有自己的模型,就不需要存在了

连接技术,赋能智能化与绿色化未来的“神经网络”

Anthropic发布Opus 4.5版本,集成Chrome和Excel新功能

Kneron发布新一代AI芯片,让大语言模型脱离云端运行于本地设备

CXL 4.0带宽翻倍并扩展内存池化至多机架配置

专家建议:云迁移前先验证应用架构和必要性

京东云与宝德计算战略签约,共绘分布式存储与智算新未来

性能狂飙70%!宝德 x 京东云AI存储一体机新品上市,重塑行业标杆

HPE Gen12:英特尔至强6加持,数据中心和边缘计算的“新宠”

Scality 推出面向 Veeam 备份的 ARTESCA 按量付费存储服务

据报道,慧与同埃隆.马斯克的X公司签署价值10亿美元的人工智能服务器大单

HPE谈2025年合作伙伴激励包:Alletra MP、Private Cloud AI、VM Essentials均属于最高倍薪酬类别

小型超算中心基础设施电气设计要点

HPE CEO谈超算优势、VM Essentials市场机会和财报业绩

AI崛起,存储重塑:从QLC到122TB大容量SSD

重磅!俄罗斯搞定了16nm芯片!