感受Power之力:IBM推出PCIe直连驱动器

IBM现为其Power服务器闪存驱动器提供无需经由交换机的直连访问,希望能让众多核心访问到更多具有更大数据传输带宽的驱动器。

Power服务器产品是IBM旗下的专有服务器,基本上也是目前市面上仍能与主导性x86处理器和新兴Arm及Risc-V处理器设计相抗衡的最后一种专有服务器CPU技术。这些处理器被用于蓝色巨人的Power服务器和i系列系统,其根源可以追溯到1988年的AS/400。如今,IBM正对其Power和i产品线做又一轮更新。

Steve Sibley

IBM Power产品管理副总裁Steve Sibley在帖子中写道,“借助业内首款已公开的PCIe直连24盘位NVme存储抽屉,IBM正着力扩展I/O容量。”

通过直连设计,IBM能够确保NVMe SSD与处理器核心的PCIe通道之间不再受到PCIe交换机或其他装置的阻隔,从而为NVMe驱动器和需要从中读取/写入数据的CPU核心之间提供完整的PCIe通道带宽。在传统设计中,PCIe交换机主要负责实现通道聚合,确保各驱动器只能获取总可用带宽中的一部分。

例如,Supermicro曾在2020年4月推出带有PCIe gen 3直连20驱动器设计的服务器2029UZ-TN20R25M。这款产品在处理器和驱动器之间设有80条PCIe gen 3带宽通道,对应每块驱动器4条通道。IBM此次宣称其推出了全球首款24抽屉PCIe直连系统确实没错,只是Supermicro在三年之前就已经推出了20块驱动器的版本。

根据蓝色巨人的介绍,与此前基于SAS的Power存储方案相比,PCIe直连选项将为Power服务器带来以下好处:

· 将直连IBM存储的每TB成本降低62%;

· 带来近10倍的I/O带宽(GBps)和高达3.7倍的每秒I/O操作(IOPS);

· 能够在单一E1080上直连最多1.2 PB的存储容量(单抽屉153 TB,最多可支持8个抽屉),并将每瓦容量提升超85%;

· 为大型关键数据库应用扩展必要的闪存系统容量;

· 本机引导最多可支持24个分区。

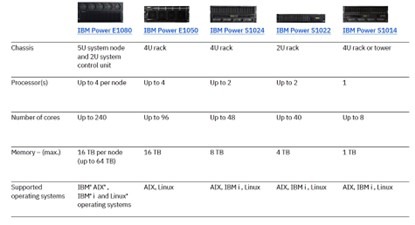

E1080是IBM推出的五款Power 10系列产品中的旗舰型号:

E1080提供8到32个PCIe gen 5适配器插槽(每节点8个),每个节点最多可支持4个扩展抽屉,可接入PCIe gen 4适配器。由此计算,每个系统(处理器)节点可支持6 x 16个PCIe gen 4,或者8个PCIe gen 5加2 x 8个PCIe gen 5 I/O薄型扩展槽(4节点系统中最多支持4 x 8即32个)。

IBM i产品线更新

IBM i产品线的技术更新将于今年5月发布,其中包括IBM Navigator for i改进,允许最终用户和系统管理员更好地访问、管理并监控自己的IBM i环境。由于SQL引擎能够利用Power 10的功能,因此运行复杂计划数据查询的客户将可借此实现性能提升。

IBM还为其Power 10 i环境提供磁带备份选项,包括:

· 新的4端口12 Gbps SAS适配器,速度至少相当于现有SAS适配器的2倍;

· 直连8 Gbps光纤通道磁带库或独立磁带存储设备;

· 支持LTO9磁带存储技术。

最后,IBM还与FalconStor Software合作,通过FalconStor提供的StorSafe虚拟磁带库(VTL)产品为Power工作负载提供企业级数据保护、灾难恢复、勒索软件保护和云迁移功能。该VTL能够为云和本地设施提供备份,因此用户可以将Power Systems工作负载迁移、备份和恢复至Power Virtual Server。它与备份软件配套使用,借助集成的重复数据删除技术清理冗余数据副本,借此降低容量要求并最大限度缩短复制时间。

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。

稚晖君发布全球最小全身力控人形机器人,上纬启元开启个人机器人时代

2026年软件定价大洗牌:IT领导者必须知道的关键变化

Linux 在 2026 年将势不可挡,但一个开源传奇可能难以为继

CES 2026趋势展望:全球最大科技展五大热门话题预测

人工智能时代为何编程技能比以往更重要

AI颠覆云优先战略:混合计算成为唯一出路

谷歌发布JAX-Privacy 1.0:大规模差分隐私机器学习工具库

谷歌量子AI发布新型优化算法DQI:量子计算优化领域的重大突破

缓解电动汽车里程焦虑:简单AI模型如何预测充电桩可用性

Titans + MIRAS:让AI拥有长期记忆能力

Gemini为STOC 2026大会理论计算机科学家提供自动化反馈

夸克AI眼镜持续升级:首次OTA,支持89种语言翻译

IBM将自家Power云打包为本地运行的“pod”形式

IBM称Power 10服务器将非常适合用于人工智能

开启AI存储时代慧荣企业级SM8366主控亮相CFMS2024

IBM Power Systems总经理给合作伙伴指明三大增长动力

合见工软发布首款自研全国产PCIe Gen5 IP解决方案,应对更复杂应用需求

PCI-EXPRESS:请务必匹配计算引擎与网络的发展节奏

感受Power之力:IBM推出PCIe直连驱动器

IBM打造24核Power芯片,方便客户使用Oracle数据库许可

IBM POWER10:综合效能力压ICE LAKE至强核心

IBM将ITaaS纳入System I及Power 10服务器套件