基于合作伙伴产品,戴尔构建Data Lakehouse智能湖仓

戴尔使用第三方合作伙伴的软件,配合自家服务器、存储和网络硬件/软件,共同构建起一套数据湖/智能湖仓参考架构设计方案。

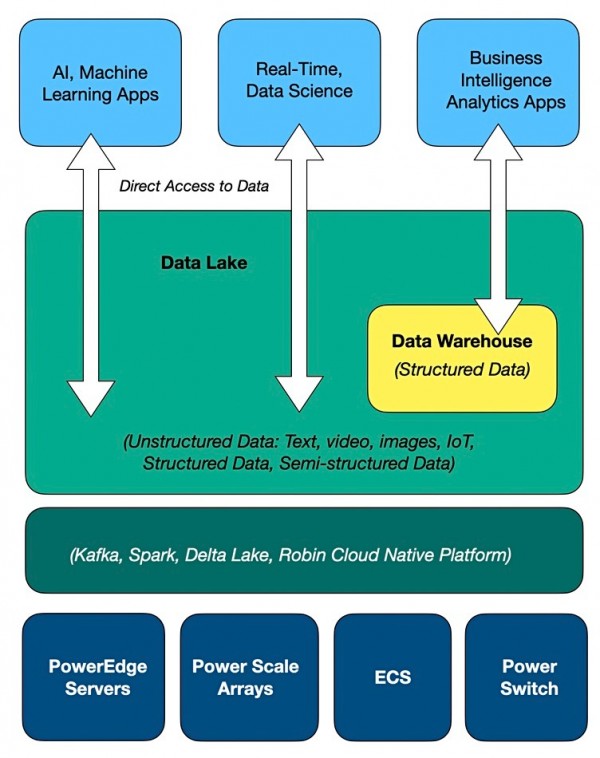

与Databricks、Dremio、SingleStore和Snowflake等同类厂商一样,戴尔建立的也是统一的智能湖仓架构。其中的基本思路,就是提供一套统一的通用存储,无需运行提取、转换和加载(ETL)流程就能选择原始数据,再以合适的形式存储在数据仓库内以方便使用。总体来看,这就像是在数据湖内又建立了一个虚拟数据仓库。

戴尔ISG解决方案营销总监Chhandomay Mandal还专门为此撰写博文,表示“传统数据管理系统,例如数据仓库,几十年来一直负责存储结构化数据以供分析使用。但数据仓库在设计上无法承载体量愈发庞大的数据集合。戴尔此次设计的参考架构使用第三方合作伙伴的软件,配合自家服务器、存储和网络硬件/软件,共同建立起数据湖/智能湖仓。这套方案能够直接支持文本、图像、视频、物联网等多种数据,还支持需要直接访问数据的人工智能与机器学习算法。”

他提到,“如今,很多组织已经将数据湖与数据仓库结合使用——将数据存储在湖内,之后再复制到仓库里以降低访问难度。但这无疑增加了分析环境的复杂性和使用成本。”

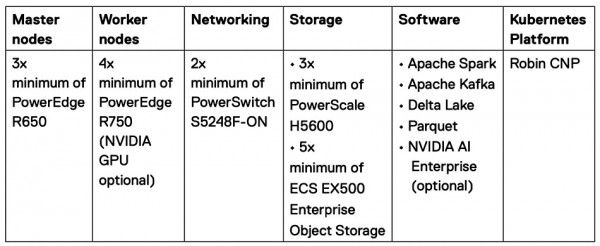

最好能在单一平台上解决所有需求。而戴尔Data Lakehouse提供的分析验证设计能够直接支持商务智能(BI)、分析、实时数据应用、数据科学及机器学习。这套方案基于PowerEdge服务器、PowerScale块/文件统一存储阵列、ECS对象存储及PowerSwitch网络。该系统可以安装在本地或托管设施当中。

块/文件存储示意图

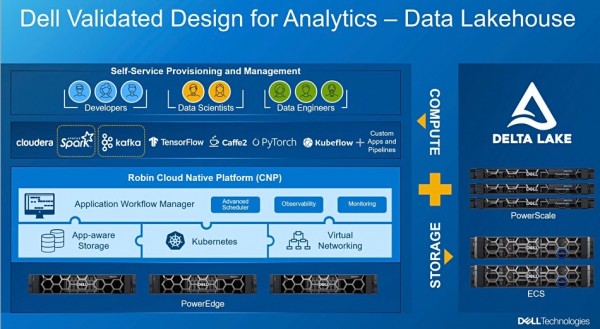

其中采用的软件技术包括Robin Cloud Native Platform、Apache Spark(开源分析引擎)、Kafka(开源分布式事件流平台)以及Delta Lake技术。Databricks的开源Delta Lake软件以Apache Spark为基础,戴尔之前就一直在内部智能湖仓中使用。

戴尔最近还与乐天集团收购的Roin.IO及其开源Kubernetes平台开展合作。

戴尔最近宣布与Snowflake达成外部表访问协议,并表示此次Data Lakehouse智能湖仓的设计概念也用到了这一协议。据推测,未来Snowflake外部表将可以直接引用戴尔智能湖仓中的数据。

戴尔还发布了上面这张演示文稿,看起来是相当复杂。该解决方案的具体信息参见下表:

很明显,这不是那种能拿来即用的系统。在跟戴尔签订协议之前,客户还认真研究自己到底要使用哪些组件和选型。

有趣的是,HPE也推出了颇为相似的产品Ezmeral Unified Analytics,其中同样使用到Databrick的Delta Lake技术、Apache Spark和Kubernetes。HPE本周将举办Discover活动,预计届时将发布更多消息。从这个角度看,戴尔好像是故意要抢先一步。

来源:至顶网存储频道

好文章,需要你的鼓励

至顶AI实验室硬核评测:HP Z2 Mini G1a工作站,仅30分钟还原毛利侦探事务所

真相只有一个:在AI与创意的交汇点上,HP Z2 Mini G1a确实是一台值得推荐的灵感引擎。

德国图宾根大学团队让2D材质预测瞬间“立体化“:MatSpray技术重新定义3D物体重光照

德国图宾根大学研究团队开发了MatSpray技术,能将2D照片中的材质信息准确转换为3D模型的物理属性。该技术结合了2D扩散模型的材质识别能力和3D高斯重建技术,通过创新的神经融合器解决多视角预测不一致问题,实现了高质量的材质重建和真实的重光照效果,处理速度比现有方法提升3.5倍。

我们希望AI有多智能?世界模型可能比我们更懂世界

近年来,AI学会了写作、生成图像、创建视频甚至编写代码。随着这些能力成为主流,研究重点转向更深层问题:机器能否真正理解世界运作方式?世界模型应运而生,从1950年代概念到2024年OpenAI的Sora、2025年英伟达Cosmos等突破性应用。与语言模型基于文本预测不同,世界模型专注预测环境变化,通过学习因果关系实现推理规划。在机器人、自动驾驶等物理AI领域前景广阔,但面临计算资源需求高、数据收集困难等挑战。

纽约大学发明“大脑翻译器“:让机器人读懂人类思维,精准操控语言AI

纽约大学研究团队开发出革命性"大脑翻译器"技术,首次实现用人类大脑活动模式精确控制AI语言行为。通过MEG脑磁图技术构建大脑语言地图,提取20个关键坐标轴,训练轻量级适配器让AI按人脑思维方式工作。实验证明该方法不仅能精确引导AI生成特定类型文本,还显著提升语言自然度,在多个AI模型中表现出良好通用性,为人机交互和AI可控性研究开辟全新路径。

至顶AI实验室硬核评测:HP Z2 Mini G1a工作站,仅30分钟还原毛利侦探事务所

冷板式液冷CDU系统

开箱 NVIDIA DGX Spark: 把一千万亿次算力,“塞进”ipad mini大小的盒子里

我们希望AI有多智能?世界模型可能比我们更懂世界

首席信息官角色将在2026年扩展的四种方式

Waymo正在测试Gemini在无人驾驶出租车中的车载AI助手功能

数据中心从幕后走向台前的转折之年

意大利要求Meta暂停禁止竞争对手AI聊天机器人使用WhatsApp的政策

让老旧Windows和macOS系统延续生命力

微软计划到2030年用Rust语言替换所有C和C++代码

2026年创客工具迎来重大升级,这些新技术值得期待

2025年十大网络故事盘点