新华三徐润安:面向未来十年,新华三全闪存Alletra为存储“即服务”做智能准备 原创

在生机盎然的7月,新华三在北京召开“2021新华三存储新品发布会”,重磅推出云智原生的新一代端到端NVMe闪存存储H3C/HPE Alletra、分布式融合存储H3C UniStor X10000,以及全新升级的智慧中枢数据平台。

在会后采访中,新华三集团计算存储产品线副总裁、存储产品线总经理兼首席产品经理徐润安表示,新华三此次发布的系列产品,希望真正打通AI与数据的关系,在为企业提供更高存储性能产品的同时,也借助智慧中枢平台让企业更加智能的管理数据,让用户获得极致的速度、智能的应用和云一般的体验。

面对智能世界的到来,面对海量数据的分析,新华三希望此次的新品能够为未来十年存储“即服务”做好基础准备。“在Alletra的平台上我们提供“即服务”的体验,不需要关心下面到底是Nimble还是Primera,希望10年以后让大家忘掉存储本身用户不用再去关心存储的技术,仅仅关注提供的存储服务即可。” 徐润安表示。

面向未来,智能中枢是关键

基于端到端NVMe架构的Alletra系列全闪存将CASL、数十项缓存优化专利算法与SCM结合,带来读写时延的进一步降低,让性能提升最高300%,充分释放存储性能。业内首款分布式存储全闪节点H3C UniStor X10000,利用SCM存储级内存和NVMe协议的组合,提供极致的性能,以及全场景存储解决方案,通过复制、双活提供全面的同城和异地容灾方案,保证数据可靠性和业务连续性。

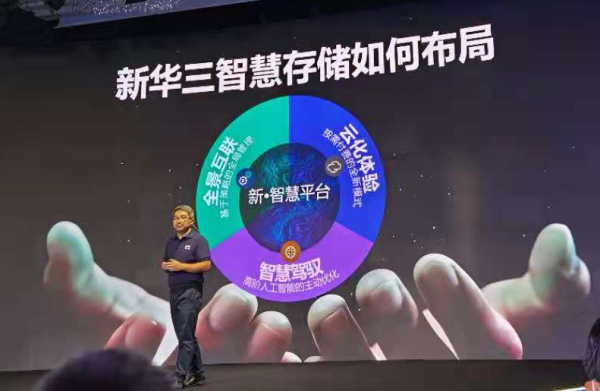

面向未来存储,新华三的智能中枢是关键。因为在万物互联时代,用户对存储性能、可用性、使用体验提出了全新要求。只有通过一个智慧中枢数据平台,才能将更大、更广义的智能赋予存储运维管理,有效支撑用户在业务不同阶段的技术创新。

智慧中枢数据平台希望通过提供监测、管理、分发、部署、升级等服务,并针对业务风险提前发出预警,构建全局化、可视化的管理模式,实现接入存储业务能力的全面提升来构建全局智能,主动感知全球每一台接入存储的状态。

智能中枢一个亮点是,用户不会再为底层硬件所困扰,只需关注自身需求。

“智慧中枢引用的是像手机APP的概念模式,任何一个管理模块都可以看成是一款手机APP,你需要一个管理模块的时候可以灵活在智慧中枢里添加。比如说要管理Alletra的话,添加一个APP就实现了,我想在Alletra阵列之间去移动数据、需要添加其他的APP,这些管理工具看着是独立的APP,但底层是互通的。”新华三集团首席存储架构师张楠介绍到。

“更多是从上往下的业务逻辑,而不是像搭积木一样从下往上的思考问题,底层需要配置多少硬盘?数据存储在哪里?你不需要考虑这个,从上往下做这个事情。” 徐润安补充到,这样做的好处是是随着业务的变化,用户可以像使用、管理公有云一般,灵活增加或者减少存储资源的使用量,提升不同场景下的存储利用率,让存储资源的价值得到最大化。用户可以以商业许可的形式获取存储资源。

存储智能也适合二八原则

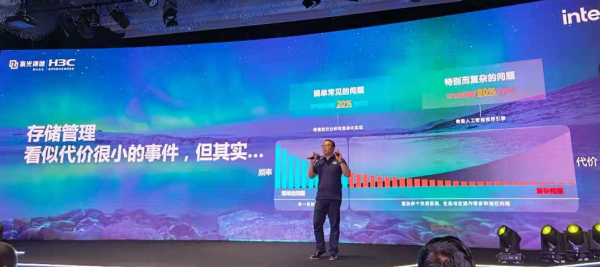

人工智能应用到存储的一个优势是,存储不再“背锅”。存储管理,看似代价很小的事件,但其实影响很大,新华三集团存储产品管理部部长张颖表示,目前80%的问题简单常见的问题仅需要20%的代价就能完成,而剩余20%的特别而且复杂的问题,需要80%的代价来完成。如何让AI引擎来分析和自动化助力20%的复杂问题,将大大释放运维时间和成本。

徐润安在采访中表示,新华三所做的是真正把智能应用于业务的核心,真正地找到问题所在,才能节约人们80%的时间,去解决那20%的复杂问题。“最花时间的是20%的复杂问题,要花掉用户80%的时间。这些问题不是那么容易解决的,我们的人工智能聚焦的是那20%的问题,但往往是这类问题需要花费客户80%的时间。”徐润安补充到。

在采访最后,张楠分享了新产品Alletra起名的趣事,首先是琅琅上口,其次希腊语中与electric-电有些相似。电闸一开一关,屋子就变亮了,就像新华三智慧中枢。通过一个开关,智慧中枢就帮你解决了,主要目的是让用户能记住这个名字。

好文章,需要你的鼓励

Plaud推出新款AI可穿戴设备,有望取代Otter.ai

Plaud在CES上推出两款AI笔记新品。NotePin S延续简约设计,可作为手环、项链或胸针使用,新增即时高亮按钮功能,售价179美元。同时发布的Plaud Desktop可录制在线会议,支持Zoom、Google Meet等平台,采用原生录制方式而非机器人参会。两款产品均可通过Plaud生态系统统一管理录音内容。

ByteDance联手顶尖学府重新定义AI思考:当机器学会分层理解世界

ByteDance等机构联合提出DLCM模型,通过学习语义边界动态分配计算资源,将AI从统一令牌处理转向层次化概念推理。该模型引入压缩感知缩放定律,在12项零样本测试中平均提升2.69%准确率,为构建更智能高效的AI系统开辟新路径。

Instagram负责人:你的眼睛已经不能分辨什么是真实的了

Instagram负责人亚当·莫塞里发布深度分析,指出我们正进入"无限合成内容"新时代,AI生成的照片和视频与真实内容越来越难以区分。他表示,人们需要从默认相信眼见转向保持怀疑态度,关注内容发布者身份和动机。莫塞里认为相机公司发展方向错误,过度追求完美效果。平台需要构建更好的创作工具,标记AI生成内容,验证真实内容,并提供发布者可信度信号。

香港中文大学团队突破:让AI有了“超级记忆“,多步推理能力飙升!

香港中文大学团队突破AI记忆瓶颈,提出HGMEM超图记忆机制。该技术让AI具备类似人类的联想思维,能将分散信息整合成高阶理解。通过动态记忆演化和智能检索,显著提升了复杂推理能力,在长文本理解任务中全面超越现有方法,为AI向"知识理解者"转变开辟新路径。

Instagram负责人:你的眼睛已经不能分辨什么是真实的了

派拓网络安全官:智能体将成2026年最大内部威胁

Subtle发布搭载降噪模型的无线耳机

Xreal发布新款AR眼镜和电源集线器,革新工作娱乐体验

纳瓦尔Flow 2扫地机器人问世:配备AI识别技术能找到丢失物品

7个家庭AI技巧让智能聊天机器人相形见绌

Mac成为企业环境中最可持续设备的原因调查显示

首次独居必备的10款实用智能设备推荐

OpenAI重组团队开发语音AI硬件产品,2026年推出新模型

AI重塑工作格局:Mercor如何连接人才与智能体训练

科技巨头在股价飙升中套现160亿美元

联想问天 WR5215 G5服务器重磅发布:以能效和性能树立单路服务器新标准