Infortrend推出AI存储EonStor GSi ——高度集成的超融合存储

当前AI市场炒得火热,越来越多的企业加入到人工智能的行列,让智能化应用提升企业与用户的竞争力,开拓更广阔的业务领域,例如:智能监控、人脸识别、智慧小区、智慧校园等等,可以说 AI智能化的大潮已经极速来袭。

Infortrend 根据市场需求推出了AI与存储融合一体化设备-GSi系列存储,GSi一套系统集成了文件存储、块存储,打通云端。并与机器学习硬件以及相关套件融合,不需要再单独购买计算节点,一台GSi就可以满足用户对于海量数据的存储管理需求,同时也满足AI机器学习中所需的超强计算能力。

高度集成的架构设计,无缝对接存储与机器学习应用程序。在Infortrend GSi存储的centOS 操作系统之上配有Docker 的设计,将深度学习软件(例如:TensorFlow, Caffe, Caffe2, Theano等)通过Docker的方式部署在GSi存储上,满足AI 所需的机器学习框架。并且内置NVIDIA GPU 卡支持CUDA 计算加速,来提供超强的浮点计算。

高度集成的架构设计,无缝对接存储与机器学习应用程序。在Infortrend GSi存储的centOS 操作系统之上配有Docker 的设计,将深度学习软件(例如:TensorFlow, Caffe, Caffe2, Theano等)通过Docker的方式部署在GSi存储上,满足AI 所需的机器学习框架。并且内置NVIDIA GPU 卡支持CUDA 计算加速,来提供超强的浮点计算。

由于架构的高度集成,所以磁盘阵列的数据传输到计算单元进行计算时,我们不需要担心网络的延迟。对于传统的网络架构而言,存储中的数据需要通过网络交换机传输到计算节点或者计算服务器进行计算,在这中间必然会存在一些网络延迟,而EonStor GSi 是通过内部的PCI-E总线进行数据传输,所有的传输过程都在一个设备当中进行,不会出现网络延迟的情况,而影响用户业务的正常运转。

另外Infortrend EonStor GSi也对接云存储,通过内部独有的智能算法,数据可以在infortrend GSi 与云端之间合理分配, 将该系列存储的高性能和安全性发挥到极致,使本地存储与云完全融合,有效弥补了独立的本地存储与独立云存储的不足,广泛支持各种OpenStack与公有云服务(例如,阿里云、Amazon,Azure,Google等),不仅可以应对后期因业务增长带来的空间需求,也可以利用云计算处理更深层面的数据分析。

具备全方位的云集成功能,通过数据压缩、重复数据删除等功能来减少数据对云空间以及传输带宽的占用。其中,云同步功能在实现跨站点文件共享与同步的同时,可以作为理想的备份与灾难恢复方案;云缓存模式提供访问云端如本地端一样快捷的体验。

具备全方位的云集成功能,通过数据压缩、重复数据删除等功能来减少数据对云空间以及传输带宽的占用。其中,云同步功能在实现跨站点文件共享与同步的同时,可以作为理想的备份与灾难恢复方案;云缓存模式提供访问云端如本地端一样快捷的体验。

全方位的数据保护功能,通过快照、卷复制、镜像、云集成等方式实现数据的备份。通过256位AES 加密保护,防止数据外泄;SSL 加密技术可以保证敏感数据向云端传送过程中的安全。

伴随着云计算、大数据等技术的趋于成熟,几乎所有的行业都在尝试通过人工智能AI 的方法来改变传统的工作方式,提高工作效率。下面Infortrend列举了几类可应用GSi的场景:

智慧小区

我们通过Docker 轻量级的虚拟化技术将人脸识别系统部署在我们的存储上,而Infortrend GSi 本身内置强大的NVIDIA GPU 卡为人脸识别分析以及身份验证提供超强的计算能力,以便完成实时数据分析,有效解决刷卡进门的麻烦。当然,还可以通过Infortrend GSi 设备集成的云功能共享数据,即便我们身处异地,可以在手机APP上实时查看小区内部情况。实现社区安防系统的升级,提高小区内部的安全性,减少社区安全管理对人员的依赖,提升物业管理水平和服务效率,建设一个安全、和谐、信息管理智能化的高端小区。

广电行业

加入AI人工智能后,能够对视频、图片等媒资文件进行数据分析、辨识,我们只要对视频、图片中的某一个物体进行搜索即可快速定位到目标文件。使查找变得更轻松、更高效。

医疗影片的智能分析

依靠海量医疗数据与AI算法发现病症规律,从而为医生诊断和治疗提供参考意见;也可以利用算法对基因数据进行分析,对疾病风险进行预测。

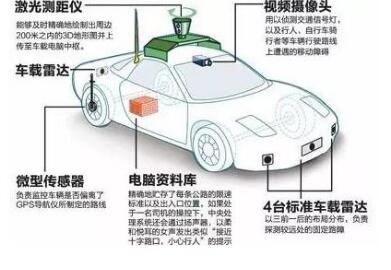

自动驾驶

在汽车行业AI的焦点莫过于自动驾驶,通过嵌入AI机器学习的算法,通过大量的交通与行驶数据不断地自我学习,修复并提高安全性和效率。

在学校以及科研单位中运行的应用程序通常需要高性能计算,例如基于MATLAB 建模、矩阵运算、信号处理,以及深度学习的训练等等。针对这些应用,Infortrend GSi 不仅可以提供高性能计算,也为大量的计算数据提供存储空间,不需要复杂的网络架构,部署起来简单、高效。

通过AI智能机器分析客户数据,提高审批效率,把控金融风险。例如银行审核企业贷款或者个人消费贷款时,可以利用人工智能对贷款的风险进行控制、决策。人工智能也可以广泛快速地收集信息,在海量数据中筛选有用信息,并综合判断被审核人的信用情况和还款能力。另外,在投资领域,通过人工智能系统分析大量的股票交易数据,让机器帮助人选择更优的投资股票。

来源:业界供稿

好文章,需要你的鼓励

谷歌智能体开发套件架构深度解析:从核心组件到实践应用

谷歌Agent Development Kit(ADK)革新了AI应用开发模式,采用事件驱动的运行时架构,将代理、工具和持久化状态整合为统一应用。ADK以Runner为核心,通过事件循环处理用户请求、模型调用和外部工具执行。执行逻辑层管理LLM调用和工具回调,服务层提供会话、文件存储等持久化能力。这种架构支持多步推理、实时反馈和状态管理,为构建超越简单聊天界面的生产级AI应用提供了完整框架。

上海AI实验室让机器人“睁眼看世界“:用视觉身份提示技术让机械臂学会多角度观察

上海AI实验室联合团队开发RoboVIP系统,通过视觉身份提示技术解决机器人训练数据稀缺问题。该系统能生成多视角、时间连贯的机器人操作视频,利用夹爪状态信号精确识别交互物体,构建百万级视觉身份数据库。实验显示,RoboVIP显著提升机器人在复杂环境中的操作成功率,为机器人智能化发展提供重要技术突破。

iOS 18新增游戏应用正式上线,专为iPhone游戏体验而生

苹果在iOS 26中推出全新游戏应用,为iPhone、iPad和Mac用户提供个性化的游戏中心。该应用包含五个主要版块:主页展示最近游戏和推荐内容,Arcade专区提供超过200款无广告游戏,好友功能显示Game Center动态并支持游戏挑战,资料库可浏览已安装游戏并提供筛选选项,搜索功能支持按类别浏览。iOS 26.2版本还增加了游戏手柄导航支持,为游戏玩家提供更便捷的操作体验。

英伟达团队突破AI训练瓶颈:让机器人同时学会多种技能不再“顾此失彼“

英伟达研究团队提出GDPO方法,解决AI多目标训练中的"奖励信号坍缩"问题。该方法通过分别评估各技能再综合考量,避免了传统GRPO方法简单相加导致的信息丢失。在工具调用、数学推理、代码编程三大场景测试中,GDPO均显著优于传统方法,准确率提升最高达6.3%,且训练过程更稳定。该技术已开源并支持主流AI框架。

谷歌智能体开发套件架构深度解析:从核心组件到实践应用

iOS 18新增游戏应用正式上线,专为iPhone游戏体验而生

Sleepbuds制造商Ozlo如何构建睡眠数据平台

CES 2026推出AI伴侣机器人Emily

苹果2026年将发布四款新iPhone机型预览

AGI-Next峰会全记录解读:Kimi、Qwen、智谱、腾讯同台,2026年有新范式是共识,中国引领AI概率最低预测2成

Anthropic推出医疗健康功能助力患者理解病历记录

Google推出通用商务协议,推动智能体购物自动化

核电初创公司携小型反应堆回归,面临重大挑战

谷歌针对部分医疗查询移除AI概览功能

Motional采用AI优先策略重启无人驾驶出租车计划

新年存储升级:三星SSD优惠最高减免100美元