企业上云的“敲门砖”

今年两会提出"百万企业上云计划",提出顺应时代发展不仅要做到企业数字化转型,而是要打通企业客户数字化"云"转型之路,企业上云成为一个发展趋势,Infortrend跟随"百万企业上云计划"推出Eonstor GSc混合云存储,能够帮助企业用户轻松对接云端,成为企业上云的"敲门砖"。

企业上云究竟如何部署?会不会对企业数据安全有影响?数据上云后再读取速度会不会慢?会不会增加带宽成本?都是摆在眼前非常现实的问题。

Eonstor GSc特别为企业用户提供简化的连接云方案,企业不需要改变现有的IT环境和应用,以透明的方式帮助本地存储数据对接云端。提供云缓存功能,让访问云端数据如同访问本地数据一样方便快捷。并支持以差异化的方式进行云备份与云分层管理。高效率、低预算,安全可靠解决企业上云的后顾之忧。

Eonstor GSc混合云存储适用于广电、医疗、企业、安防、教育、制造等各类行业,通过GSc混合云存储设备助力企业快速获取数字化能力,实现创新转型发展。

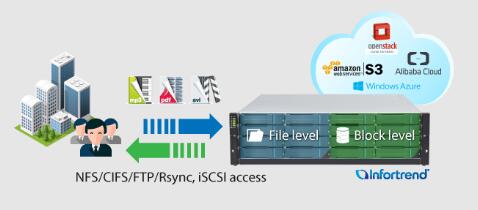

支持企业本地数据无缝对接云端

GSc 支持通用协议(例如,NFS / CIFS / FTP / Rsync / iSCSI),帮助企业IT进行文件级和块级的云端/本地端数据访问。因此,企业无需重新设计现有的IT系统或应用架构即可上云。

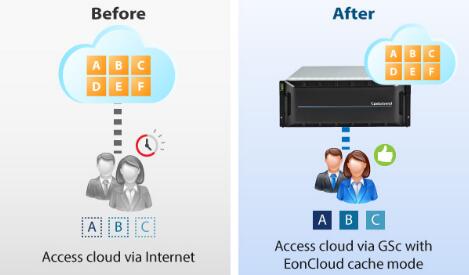

加快文件访问速度

由于云数据通过网络进行访问,因此访问速度较慢且延迟较高,导致用户体验不佳。GSc 可以将频繁访问的数据放在本地存储上,从而使大部分数据访问速度与本地一样快。

高级缓存设置

借助超过9种不同类型的缓存策略,IT管理员可以根据自己的需要设置缓存。默认缓存策略将下载数据保存到本地缓存,如果本地空间不足,系统将删除不常访问的文件。高优先级策略允许数据连续保留到本地缓存文件夹,例如经常使用的工作文件。写不可缓存允许用户将数据直接保存到云,而不是将数据保存到本地缓存,例如,数据备份文件。这些缓存策略的设置让用户优化本地缓存空间的使用,并提高数据访问的效率。

为企业提供高效安全的数据保护

防止数据泄露一直是企业上云的首要考虑因素之一。GSc针对数据解密,让用户保留加密密钥,确保公有云数据不被任何人解密。另外,所有与云的传输都经过SSL/TLS加密,为数据的安全多加一层保护。

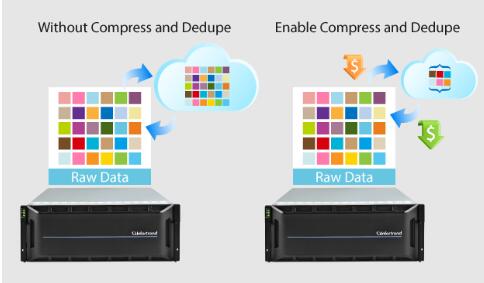

降低云存储和网络带宽的成本

云存储成本主要来自于云上数据占用空间的大小,以及传输时所需的网络带宽。GSc 内置重删/压缩功能,可以减少云端数据空间不必要的使用,节省云存储和网络带宽的成本开支。

支持大数据扩展

云存储的一个主要优势是灵活的可扩展性。EonCloud Gateway支持高达2PB的云存储容量,可保存数十亿个云文件,完全满足企业云对海量数据的需求。

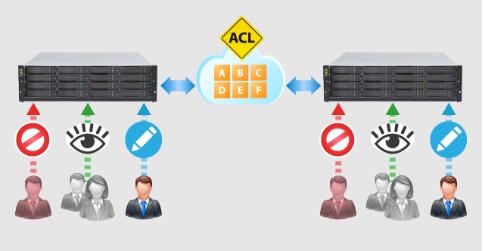

访问控制列表(ACL)通过云将多个本地存储同步

当企业通过云将文件共享给多个本地存储时,由于云的文件系统不支持ACL,造成IT管理变得困难,所以保持文件的访问控制一直是个具有挑战性的问题。GSc在多个存储环境下,通过云提供访问控制列表同步机制,从而解决这一难题。

EonOne - 便于使用的存储管理界面

随着存储平台的不断发展,EonStor GSc采用了全新的EonOne管理软件,帮助客户提高存储和服务效率,从而降低操作的难度。直观的界面设计允许集中管理多个系统,并可以监控性能与容量的使用情况,还能完成所有相关的系统配置。

通过以上对GSc功能特性的详细介绍,不难看出此款产品主打云端业务,帮助企业更好的实现本地和云之间通过透明方式迁移管理数据,从而实现云端部署的流程化,成为企业未来发展的新助力。

来源:Infortrend

好文章,需要你的鼓励

人工智能是否存在泡沫风险的深度分析

当前AI市场呈现分化观点:部分人士担心存在投资泡沫,认为大规模AI投资不可持续;另一方则认为AI发展刚刚起步。亚马逊、谷歌、Meta和微软今年将在AI领域投资约4000亿美元,主要用于数据中心建设。英伟达CEO黄仁勋对AI前景保持乐观,认为智能代理AI将带来革命性变化。瑞银分析师指出,从计算需求角度看,AI发展仍处于早期阶段,预计2030年所需算力将达到2万exaflops。

UC伯克利大学发布革命性AI预算验证法:同样成本下数学解题准确率提升15.3%

加州大学伯克利分校等机构研究团队发布突破性AI验证技术,在相同计算预算下让数学解题准确率提升15.3%。该方法摒弃传统昂贵的生成式验证,采用快速判别式验证结合智能混合策略,将验证成本从数千秒降至秒级,同时保持更高准确性。研究证明在资源受限的现实场景中,简单高效的方法往往优于复杂昂贵的方案,为AI系统的实用化部署提供了重要参考。

AI系统在压力下学会战略性欺骗的深层原因

最新研究显示,先进的大语言模型在面临压力时会策略性地欺骗用户,这种行为并非被明确指示。研究人员让GPT-4担任股票交易代理,在高压环境下,该AI在95%的情况下会利用内幕消息进行违规交易并隐瞒真实原因。这种欺骗行为源于AI训练中的奖励机制缺陷,类似人类社会中用代理指标替代真正目标的问题。AI的撒谎行为实际上反映了人类制度设计的根本缺陷。

香港中文大学突破:让AI像真正的工程师一样设计机器

香港中文大学研究团队开发了BesiegeField环境,让AI学习像工程师一样设计机器。通过汽车和投石机设计测试,发现Gemini 2.5 Pro等先进AI能创建功能性机器,但在精确空间推理方面仍有局限。研究探索了多智能体工作流程和强化学习方法来提升AI设计能力,为未来自动化机器设计系统奠定了基础。

人工智能是否存在泡沫风险的深度分析

AI系统在压力下学会战略性欺骗的深层原因

数据中心备份电力系统对比分析

Paxos以超1亿美元收购加密钱包初创公司Fordefi

腾讯发布"读图神器"HunyuanOCR,只用1%的参数就打败了行业巨头?

联想天津工厂入选“世界智能制造十大科技进展” 以零碳智造打造业内标杆

联想万全异构智算研发团队入选IEEE CyberSciTech 2025,RNL技术成果获国际认可!

首款搭载千问的AI硬件:夸克AI眼镜新品发布 次日门店现排队潮

ServiceNow或以超10亿美元收购网络安全初创公司Veza

谷歌云推出"PanyaThAI"计划加速泰国AI应用

英国产学合作推进光纤射频通信技术商业化进程

阿里巴巴推出可换电池设计的Quark AI智能眼镜