IBM Storage Scale被采用于Blue Vela AI超级计算机

IBM的Vela AI超级计算机功能已经不足以满足IBM研究院的AI训练需求。于是2023年开始研发的Blue Vela旨在满足GPU计算能力方面的重大扩展,用以支持AI模型训练需求。截至目前,Blue Vela正被积极用于运行Granite模型训练作业。

IBM Blue Vela示意图。

Blue Vela基于英伟达的SuperPod概念打造,并采用IBM自家的Storage Scale设备。

Vela被托管在IBM Cloud之上,但Blue Vela集群则托管在IBM研究院的本地数据中心当中。这意味着IBM研究院拥有全部系统组件的所有权及责任,涵盖从基础设施层到软件技术栈的整个体系。

Blue Vela系统中的各层。

随着训练体量更大、连接更紧密的模型所需要的GPU数量的增长,通信延迟成为影响结果的关键瓶颈。因此,Blue Vela的设计从网络起步,围绕四种不同专用网络构建而成。

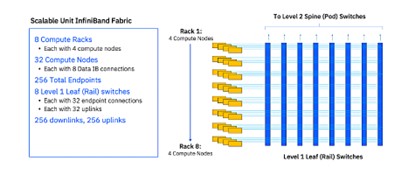

- 计算InfiniBand结构,促进GPU到GPU之间的通信,如下所示;

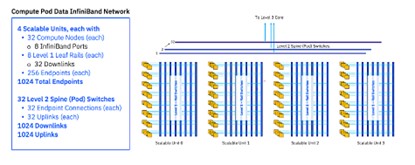

- 存储InfiniBand结构,提供对各存储子系统的访问,如下所示;

- 带内以太网主机网络,用于计算结构外部各节点间的通信;

- 带外网络(也称管理网络),提供对服务器和交换机上的管理接口的访问。

Blue Vela基于英伟达的SuperPod参考架构。其采用128节点计算Pod,其中包含4个可扩展单元,每单元又包含32个节点。这些节点均采用英伟达H100 GPU。英伟达的Unified Fabric Manager统一结构管理器(FCM)则用于管理由计算和存储结构组成的InfiniBand网络。该管理器有助于识别并解决单个GPU限流或者不可用问题,而且无法兼容以太网网络。

各计算节点基于戴尔PowerEdge XE9680服务器,具体组成包括:

- 双48核第四代Gen英特尔至强Scalable处理器;

- 八英伟达H100 GPU加80 GB高带宽内存(HBM);

- 2 TB RAM;

- 十英伟达ConnectX-7 NDR 400 Gbps InfiniBand主机通信适配器(HCA);

-其中八个专用于计算结构;

-两个专用于存储结构

- 八块4 TB Enterprise NVMe U.2 Gen4 SSD;

- 双25G以太网主机链路;

- 1G管理以太网端口。

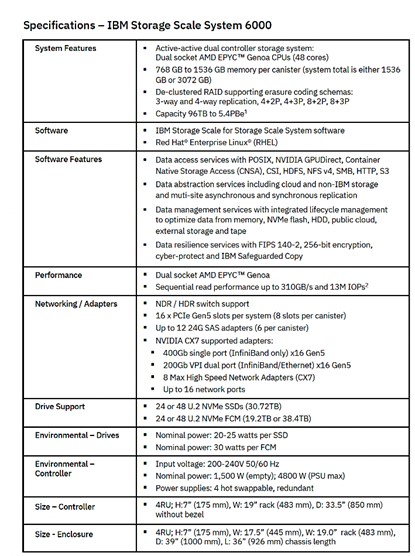

IBM“修改了标准存储结构配置,旨在集成IBM新的Storage Scale System(SSS)6000,我们自己也成为首家部署该系统的公司。”

这些SSS设备属于集成化的纵向/横向扩展存储系统,可容纳1000台设备,且安装有Storage Scale。其支持自动、透明的数据缓存以加快查询速度。

每个SSS 6000设备均可通过其InfiniBand和PCI Gen 5互连提供高达310 GBps的读取吞吐量及155 GBps的写入吞吐量。Blue Vela最初拥有两个满配SSS 6000机箱,每机箱配备48 x 30 TB U.2 G4 NVMe驱动器,可提供近3 PB的原始存储容量。每台SSS设备最多可额外再容纳七个外部JBOD机箱,每机箱最多可提供22 TB的容量扩展。此外,Blue Vela结构最多可容纳32台SSS 6000设备。

IBM表示,基于FCM驱动器及3:1压缩比率,其最大有效容量可高达5.4 PB,具体取决于存储在FCM当中的数据特性。

Blue Vela使用戴尔PowerEdge R760XS服务器以建立单独的管理节点,可用于运行身份验证与授权、工作负载调度、可观察性及安全性等服务。

在性能方面,论文作者表示“从一开始,这套基础设施也表现出了良好的吞吐量潜力。与同等配置的其他环境相比,其开箱即用性能提高了5%。”

“集群的当前性能显示出良好的吞吐量水平(每天90至321B,具体取决于训练设置与实际训练的模型)。”

Blue Vela性能统计。

IBM研究论文中列出了关于Blue Vela数据中心设计、管理功能以及软件堆栈的更多详细信息,感兴趣的朋友可以点击此处(https://arxiv.org/abs/2407.05467)查看。

来源:至顶网存储频道

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。

稚晖君发布全球最小全身力控人形机器人,上纬启元开启个人机器人时代

2026年软件定价大洗牌:IT领导者必须知道的关键变化

Linux 在 2026 年将势不可挡,但一个开源传奇可能难以为继

CES 2026趋势展望:全球最大科技展五大热门话题预测

人工智能时代为何编程技能比以往更重要

AI颠覆云优先战略:混合计算成为唯一出路

谷歌发布JAX-Privacy 1.0:大规模差分隐私机器学习工具库

谷歌量子AI发布新型优化算法DQI:量子计算优化领域的重大突破

缓解电动汽车里程焦虑:简单AI模型如何预测充电桩可用性

Titans + MIRAS:让AI拥有长期记忆能力

Gemini为STOC 2026大会理论计算机科学家提供自动化反馈

夸克AI眼镜持续升级:首次OTA,支持89种语言翻译