华为云芜湖数据中心开服 全面满足中东部市场多样算力需求

6月14日,华为云华东(芜湖)数据中心正式开服,这标志着华为云全国存算网的枢纽节点布局全面完成。而这一芜湖数据中心集群首个开服的项目,也意味着东数西算的长三角枢纽节点可面向华东及中部区域提供超大规模算力服务,将有力推动相关区域的AI产业发展。

华为公司副董事长、轮值董事长徐直军表示,华为云华东(芜湖)数据中心是华为云版图的重要组成部分,能帮助企业使用云上算力,随取随用,技术永新。企业则不必建设数据中心,可以聚焦在自身业务发展上。

华为公司副董事长、轮值董事长徐直军

华为公司常务董事、华为云CEO张平安表示,华为云以系统性创新,重新定义了云基础设施,未来通过全球存算网和昇腾AI云服务,推动“百模千态”的应用创新,并加速千行万业的智能化转型进程。

华为公司常务董事、华为云CEO张平安

多元算力对等池化架构首次应用 可满足超大规模算力需求

张平安介绍,华为云芜湖数据中心规划占地约6000亩,规划了300万台服务器,秉承华为云在节能、AI集群、液冷机房的丰富经验,芜湖数据中心构筑了绿色低碳、安全可靠等技术优势。

同时,为满足超大规模算力需求,芜湖数据中心首次采用了华为云全新研发的多元算力对等池化架构:通过分布式擎天架构实现CPU、NPU、GPU、内存等多样资源统一抽象、池化,从单体算力架构演进到矩阵算力架构,使算力提升50倍;通过超高带宽的Scale Up网络,将资源对等连接起来,打破了单体算力性能和集群线性度瓶颈,可有效提升了大模型的训练效率;此外,通过瑶光智慧云脑可将多种池化资源统一调度管理,实现灵活按需组合,提供百亿到万亿参数模型的最优算力配比。

在绿色低碳方面,芜湖数据中心引入AI技术精准控制温度,采集了数据中心、IT基础设施、云服务的全栈数据集进行训练,首创了云服务感知能效调优技术,有效降低PUE,达到液冷年均PUE低至1.1,低于行业水平,让每100 万台服务器每年节省 10 亿度电,在华东区域能效领先。

此外,芜湖数据中心基于全生命周期高可用设计,包括全球首创机房产品化交付模式、首次引入IoT 技术、应用AI技术主动识别供电、制冷、电池等设备风险,保障业务连续性;并通过了等保4+认证,可保障全生命周期数据安全。

最低2ms时延 高效算力助推中东部打造AI产业高地

芜湖具备良好的数据中心大规模集群条件,光纤网络可直达华东和中部热点城市,网络时延在10ms以内,其中上海、杭州时延在5ms左右,南京更低至2ms,既能满足对时延不敏感的业务,还能满足对时延要求非常高的AI推理、电商、游戏等业务,是长三角汽车、工业、生物医药、高科技等高计算资源消耗企业的优先选择。

中国工程院院士杨善林在华为云芜湖数据中心开服仪式上表示,芜湖数据中心集群建设有了华为公司的全力支持,一定能够促进我国智算产业及其科技战略供应链的高质量发展,为智算产业卓越人才的发现和成长提供肥沃的土壤,为智算产业生态系统的形成和发展提供巨大的动力,为实现“东数西算”战略和培育新质生产力贡献强大的力量。

中国工程院院士杨善林

长久以来,华为云一直努力打造AI算力基础设施,支持百模千态的创新,使能千行万业智能化升级。据透露,华为云已与奇瑞、科大讯飞、信义玻璃、海螺水泥、江淮、大众、亳州医药等一众企业开展了数智化转型、大模型应用的合作,并且打造了一系列领先的“人工智能+”应用标杆。

“中国的产业界非常自豪,华为能够在真正的硬科技算力层面上给世界第二种选择。我们特别需要在国产上更大规模的算力支撑,现在业界能够量产做大模型训练除了英伟达只有华为一家,在推理上已经做到完全对标英伟达。”科大讯飞董事长刘庆峰表示,华为云芜湖数据中心的全球开服,将对通用人工智能和智算发展起到重要的支撑和引领作用。

科大讯飞董事长刘庆峰

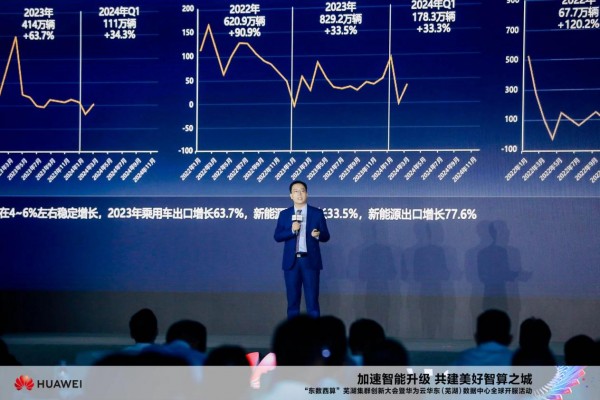

奇瑞汽车股份有限公司副总经理戴闯在大会现场表示,华为云全球站点的布局正好和奇瑞基础设施规划相匹配,华为云作为奇瑞最重要的合作伙伴,从智能算力、计算框架再到开发等等都提供了持续演进AI的能力,我们相信华为与奇瑞的强强联合,必将为中国汽车行业谱写新的篇章。

奇瑞汽车股份有限公司副总经理戴闯

以AI全栈能力 加速人工智能+千行万业

基于全国算力一张网,华为云通过即开即用的昇腾云服务,覆盖了全国的“用数”地区,支撑了智能时代大模型训推不断增长的算力需求,有力推动了智能产业发展。

值得一提的是,昇腾云以独有的多级恢复机制和完备的工具链实现了千卡训练连续30天不中断,任务恢复时长小于30分钟,为大模型和AI应用的开发运行提供了资源获取快、模型迁移快、故障修复快、云上推理投资优、就近服务时延优、云上性能优的底座支撑能力。

此外,华为云还通过盘古大模型赋能各行各业,已经原生孵化了30多个行业大模型。

自2023年起,华为正式启动全面智能化战略,持续打造坚实的算力底座,满足各行各业多样性的AI算力需求,做厚“黑土地”,为世界构建第二选择。

“依托华为云构筑的全栈AI能力,通过全球存算网、昇腾AI云服务、盘古大模型等创新技术,我们将为千行万业创新发展注入数智活力,推动中国智能产业蓬勃发展,加速培育具有创新性和竞争力的新质生产力。”张平安说。

好文章,需要你的鼓励

让AI记住房间每个角落:悉尼大学团队如何让视频生成拥有“空间记忆“

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

西班牙病毒如何将谷歌带到马拉加

33年后,贝尔纳多·金特罗决定寻找改变他人生的那个人——创造马拉加病毒的匿名程序员。这个相对无害的病毒激发了金特罗对网络安全的热情,促使他创立了VirusTotal公司,该公司于2012年被谷歌收购。这次收购将谷歌的欧洲网络安全中心带到了马拉加,使这座西班牙城市转变为科技中心。通过深入研究病毒代码和媒体寻人,金特罗最终发现病毒创造者是已故的安东尼奥·恩里克·阿斯托尔加。

马里兰大学突破性发现:AI推理过程终于有了“身体检查“——ThinkARM框架揭开大型语言模型思维奥秘

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。

生命科学计算测试专委会正式成立,BioProfile框架引领行业标准建设

超智算完成北京核心智算中心资产收购,加速构筑“3+X”全国算力网络新格局

走出“参数崇拜”:联想用“一体多端”重塑“人的尺度”

从“单点突破”到“一体多端”:拆解天禧AI 3.5进化背后三年的进化哲学

openGauss Summit 2025在京召开,加速行业智能化变革,共建繁荣数据库生态

2025联想天禧AI生态伙伴大会:天禧AI一体多端,与开发者共建个人AI生态

西班牙病毒如何将谷歌带到马拉加

LangChain核心库曝出严重漏洞,AI智能体机密信息面临泄露风险

Mill如何与亚马逊和全食超市达成合作协议

TechCrunch创业大赛中的9家顶尖生物技术初创公司

2025年印度科技领域十大重要发展

中科大发布Live Avatar:AI数字人无限聊天不翻车