HPE推出面向HPC及AI用例的经济高效型存储系统

HPE为入门级与中端HPC及AI计算集群,专门打造了小型ClusterStor超级计算机存储阵列。

ClusterStor系列属于HPE在2019年收购Cray时获得的资产,采用SSD加HDD以及Lustre文件系统软件的并行架构。其中XE E1000型可跨越数百个机架提供60 TB至数十PB的存储容量,每机架最高容量可达6.8 PB,并可提供最高1.6 TBps及5000万IOPS/机架。HPE将ClusterStor定位为运行Cray EX超级计算机的百亿亿级算力(Frontier、Aurora、El Capitan)、准百亿亿级算力(LUMI、Perlmutter、Adastra)及国家级AI超级计算机(Isambard-AI、AIps、Shaheen III)配套存储方案。

Ulrich Plechschmidt

HPE并行HPC与AI存储产品营销部门的Ulrich Plechschmidt表示,新的Cray Storage Systems C500将“以远低于以往入门价格的水平提供E1000领先级存储技术,同时提高其易用性。”

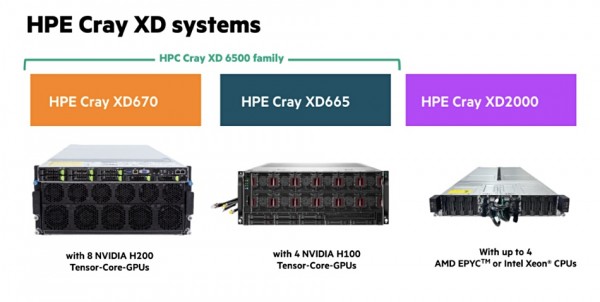

Plechschmidt解释称,C500基于E1000,主要面向希望在较小计算集群上运行建模、仿真及AI工作负载的客户。这类计算集群通常使用Cray XD系统构建而成。

Cray EX系统是一款液冷、机架规模的高端超级计算机,而配置较低的XD系列则提供风冷与液冷两种选项,并采用2RU机柜。EX与XD系列均支持AMD及英特尔x86 CPU外加英伟达Hopper GPU。

其中定位中端的XD665支持Slingshot 11、Infiniband NDR及以太网网络,并在其调整结构、GPU、NVMe驱动器及CPU之间提供直接可切换连接。据我们掌握的消息,其并不支持英伟达的GPUDirect协议。

Plechschmidt还不忘挖苦英伟达,表示C500系统的买家“可以放心使用,因为您宝贵数据存放所在的文件系统来自一个充满活力的社区,而非单一企业巨头。”

C500运行与E1000相同的Lustre软件,采用相同的2RU x 24驱动器存储控制器与5RU x 84 HDD机箱,但在具体设计上融合度更高、成本更为低廉。

带有控制器及存储机箱的入门级C500

C500配置细节:

- ProLiant DL325服务器比E1000的系统管理单元(SMU)存储控制器更便宜。

- 组合元数据单元(MDU)及可扩展存储单元闪存(SSU-F)机箱,可容纳2RU x24 NVMe SSD。

- 支持特定配置中的半填充及满填充存储机柜。

- 配备2RU x24 NVMe驱动器或5U x 84 HDD的C500扩展机箱,可将文件系统的可用容量提升至2.6 PB全闪存或4 PB混合(SSD/HDD)容量。

入门级C500可通过24个NVMe SSD提供22 TB至513 TB的可用容量,为计算节点提供高达80 GBps的聚合读取性能与60 GBps的写入性能。相比之下,IBM支持GPUDirect的ES3500使用Storage Scale并行文件系统为英伟达GPU提供126 GBps读取带宽与60 GBps写入带宽。而DDN采用Lustre的A1400X2 Turbo则能够为英伟达GPU提供120 GBps读取带宽与75 GBps写入带宽。

Plechschmidt指出,HPE即将“发布重大软件改进与新功能,使得存储系统更易于部署和管理。”但奇怪的是,详细信息隐藏在HPE QuickSpecs网页之后,需要授权合作伙伴或HPE员工方可登录。普通用户根本无从了解。

HPE QuickSpecs网页(https://psnow.ext.hpe.com/#/?url=https://psnow.ext.hpe.com/doc/a50007029enw)

HPE QuickSpecs网页(https://psnow.ext.hpe.com/#/?url=https://psnow.ext.hpe.com/doc/a50007029enw)

但HPE已经修复了此问题,并表示“QuickSpecs文档上线时发生了内部断线,目前尚未彻底解决,特此说明。

好文章,需要你的鼓励

至顶AI实验室硬核评测:戴尔Precision 5690移动工作站,部署DeepSeek+LobeChat打造个人超级智能体

本次评测的主角是戴尔Precision 5690移动工作站,这台设备搭载了英伟达RTX 3500 Ada显卡,强大的GPU算力为本地部署大语言模型提供了坚实的硬件基础。相比传统的云端AI服务,本地部署方案不仅保证了数据隐私安全,更重要的是响应速度快、使用成本可控,特别适合需要频繁使用AI工具的专业用户。

UCSD团队打造终极仿真世界:让AI智能体在虚拟城市中自立更生的惊人实验

SimWorld是由UCSD等多所顶尖院校联合开发的革命性AI仿真平台,基于虚幻引擎5构建了具备真实物理规律的虚拟城市环境。该平台支持无限扩展的程序化世界生成和自然语言交互,让AI智能体能够在复杂环境中学会生存、合作和竞争,为通用人工智能的发展提供了前所未有的训练平台。

浙江大学团队提出C2DLM:让AI推理更像人类思维的全新语言模型

浙江大学联合华为提出C2DLM,这是一种因果概念引导的扩散语言模型,通过自动提取因果关系并融入注意力机制来增强AI推理能力。相比传统方法,C2DLM在推理任务上平均提升1.31%-12%,训练效率提高3.2倍,为解决语言模型推理能力不足开辟了新路径。

让AI自己教自己写代码,会发生什么?

看得见的未来:2026年AI数据中心的革新之路

AI智能宠物健康监测站:竟说我是生病的猫

CES 2026最佳科技产品盘点:三折手机与超薄电视

亚马逊Alexa+向公众开放早期体验网站

Infinidat创始人破产问题影响联想收购进程

苹果Journal应用登陆iPadOS 26,iPad用户迎来完整日记体验

MacBook Pro即将迎来重大改版,超薄设计引发争议

AWS悄然上调GPU价格15%,云计算定价逻辑生变

六成美国成年人用ChatGPT问诊,OpenAI嗅到商机

第三代英特尔酷睿Ultra处理器,CES 2026正式发布

CES 2026 | 撕碎“显存墙”,重塑“光追梦”,打通“生态路” AMD开启全新“统治力”

VDURA 推出 V5000 全闪存节点,提升海量数据访问速度

HPE Alletra X10000 重新定义横向扩展存储硬件

HPE Gen12:英特尔至强6加持,数据中心和边缘计算的“新宠”

据报道,慧与同埃隆.马斯克的X公司签署价值10亿美元的人工智能服务器大单

HPE谈2025年合作伙伴激励包:Alletra MP、Private Cloud AI、VM Essentials均属于最高倍薪酬类别

Werner Vogels:20年架构设计,仅道六句箴言!

HPE CEO谈超算优势、VM Essentials市场机会和财报业绩

HPE计划在2025年全面升级超级计算机阵容

英伟达继续努力,希望推动AI融入包括HPC在内的一切领域

HPE发布用于AI和高性能计算的新超级计算机平台和服务器