产业丨价格暴涨500%,高阶HBM市场来临

与传统的DRAM相比,HBM拥有更高的数据容量和更低的功耗,使其成为需要高性能和高效率的人工智能应用程序的理想选择。

一位业内人士表示,在人工智能计算系统领域,目前没有其他内存芯片可以取代HBM。

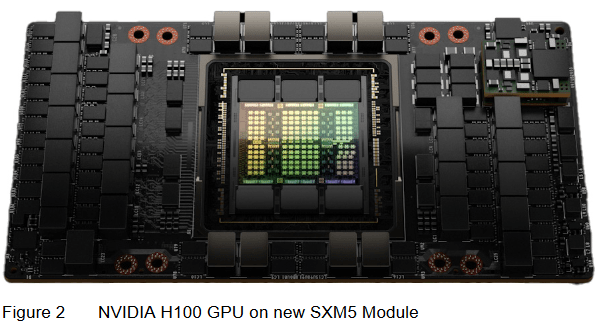

英伟达的产能上不来,很大程度上是因为HBM不够用了。每一块H100芯片,都会用到6颗HBM。

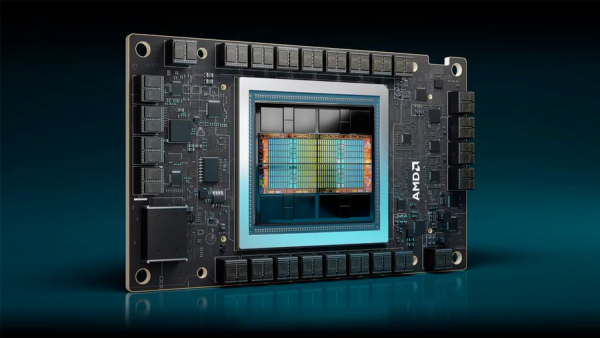

由于英伟达和AMD等AI芯片制造商的需求激增,HBM的价格正在飙升。

当前,AI服务器GPU市场以英伟达 H100、A100、A800以及AMD的MI250、MI250X系列为主,这些GPU基本都配备了HBM。

从去年到2028年,HBM供应将以45%的复合年增长速度增长。

尽管增长强劲,但考虑到扩大HBM生产以满足需求的困难,HBM价格预计将在一段时间内保持高位。

三星电子和SK海力士,通过增加HBM产量并分配资本支出来应对日益增长的需求。

这些公司对HBM的销售抱有很高的期望,因为HBM的利润率是传统DRAM芯片的5倍。

SK海力士无疑是这波内存热潮中的最大受益者,截至去年12月31日,SK海力士在去财年和第四季度的营收取得了显著增长。

特别是其主力产品DDR5 DRAM和HBM3,在这一年的收入较去年上涨了4倍以上。

TrendForce预估,今年全球HBM的位元供给有望增长105%;HBM市场规模也有望于今年达89亿美元,同比增长127%;

预计至2026年市场规模将达127.4亿美元,对应CAGR约37%。

SK海力士公司预测,在2027年之前,HBM市场将以82%的复合增长率保持增长。

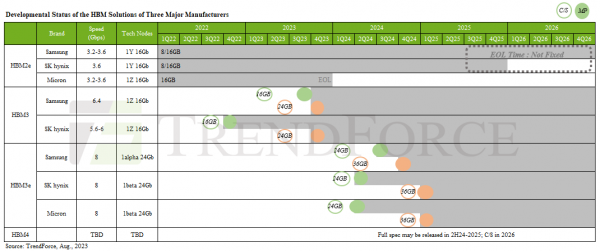

当前,HBM即将迈入第四代,然而市场格局仍未形成四足鼎立之势。据资料显示,截至去年,具备生产HBM能力的厂商仅有三家:SK海力士、三星、美光。而这种局面很可能将持续一段时间。

去年6月,媒体报道称SK海力士正筹备投资后段工艺设备,以扩充封装HBM3的产能,预计今年年末,该厂后段工艺设备规模将增长近一倍。

公司计划在今年第四季度前,将HBM的最高月产量提升至15万至17万件,以争夺今年HBM市场。

SK海力士还计划在上半年开始量产下一代HBM3E,巩固其在全球半导体高附加值产品市场的领导地位。

该公司已决定在今年预留约10万亿韩元(约合76亿美元)的资本支出,用于扩建设施,聚焦高附加值DRAM芯片生产,包括HBM3、DDR5及LPDDR5,以及升级HBM的TSV先进封装技术。

SK海力士首席执行官Jeong-ho Park表示,预计到2030年,公司HBM出货量将实现每年1亿颗。

此外,SK海力士在年度高层改组中,新成立的AI基础设施部门将整合公司内部的HBM资源。

据悉,三星电子已打破SK海力士在英伟达独家供应HBM3的局面,从今年1月开始向英伟达供应HBM3。

三星电子自去年第四季度起扩大第四代HBM3供应,目前正步入过渡期,相关销售额开始在其业绩中显现。

此前,三星电子斥资105亿韩元收购了三星显示位于韩国天安市的工厂和设备,以扩大HBM产能,同时还计划投资7000亿至1万亿韩元新建封装线。

三星目前已投入8层、12层HBM3量产,并开始供应8层HBM3E样品。

公司计划在今年第四季度前,将HBM的最高产量提升至每月15万至17万件,以争夺今年HBM市场。

但三星电子预计将大规模开展设备投资,以提升整体生产能力,加速追赶。

美光科技对下一代产品HBM3E寄予厚望,以缩小与领先者的差距。

为改变在HBM市场的被动地位,美光选择跳过第四代HBM,即HBM3,直接升级至第五代HBM4。

据悉,英伟达正致力于扩大HBM供应商阵容,以优化和强化其供应链管理。

届时,英伟达及其他CSP(云端服务提供商)在产品应用方面将实现规格与性能的提升。

HBM4堆栈将在现有12层基础上,进一步发展到16层,更高层数有望催生新堆栈方式的需求增长。

据预测,HBM412hi产品将于2026年面世,16hi产品或于2027年亮相。

SK海力士正计划为下一代HBM技术采用[2.5D扇出]封装,以提升性能、降低封装成本。

为了彻底杀死比赛,SK海力士准备直接颠覆HBM的设计思路。

它计划于2026年量产HBM 4,准备把HBM直接安在GPU顶部,走向真正的3D架构。

也就是说,SK海力士准备直接将仓库建在后厨楼上。

这一技术在内存行业尚属首次应用,但在先进半导体制造领域已颇为常见。SK海力士有望于明年公布相关研究成果。

现有HBM堆栈位于GPU附近并与芯片连接,SK海力士旨在消除中间层,将HBM4直接置于英伟达、AMD等公司GPU上,并选择台积电作为代工厂。

相较之下,三星采取光子技术在HBM中间层的应用研究,以解决与热量和晶体管密度相关的挑战。

三星计划于2025年推出HBM4,包括针对高温特性优化的非导电粘合膜(NCF)组装技术和混合键合(HCB)技术,以在人工智能芯片领域抢占主导地位。

三星高管Jaejune Kim透露,该公司的HBM产量的一半以上已经由专业产品组成。定制HBM解决方案的趋势预计将加剧。

通过逻辑集成,量身定制的选项对于满足个性化客户需求至关重要,从而巩固了市场地位。

与SK海力士和三星不同,美光并未计划将HBM与逻辑芯片整合至单一芯片,而是在下一代HBM发展上,韩系和美系内存厂商呈现出截然不同的路线。

美光可能向AMD、英特尔和英伟达建议,通过HBM-GPU组合芯片实现更快的内存访问速度,但单独依赖某一厂商芯片或带来更大风险。

在尚未确定的HBM4标准上,美光似乎试图实现[突袭]。

根据美光的信息,与前几代HBM相比,HBM4将采用更广泛的2048位接口。导致每个堆栈的理论峰值内存带宽超过1.5 TB/s。

这种更宽的接口和更快的速度将使HBM4能够突破内存带宽的界限,满足日益增长的高性能计算和AI工作负载需求。

毫无疑问,HBM对所有内存制造商而言,都是一个重要的发展机遇。

只要人工智能热潮尚未减退,英伟达的GPU产品继续保持畅销,内存制造商便能够继续凭借HBM实现丰厚利润,并呈现较为理想的业绩。

目前,两家韩国制造商不仅在市场竞争中展开激烈争夺,还在产能扩张和技术路线方面互相竞争,力求在下一代标准中掌握主导权。预计今年各大制造商在HBM领域将会有更多举措。

部分资料参考:远川科技评论:《存储,战火重燃》,半导体产业纵横:《价格暴涨500%,HBM市场彻底被引爆》,浪哥财经:《订单排到3年后,HBM国内最大黑马,背靠海力士、三星,被500家机构看中》,慧博资讯:《HBM行业深度:驱动因素、市场现状》,DoNews:《HBM[狂飙],算力突围》,半导体行业观察:《HBM,新混战》

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元

最热门的 AI 模型:它们的功能和使用方法

这款古怪的 AI 智能手机可以创建你的数字分身

Faireez 获 750 万美元融资,为租赁市场提供 AI 驱动的酒店式管家服务

Broadcom 大获全胜:70% 大型 VMware 客户购买其最全面解决方案

Peer 获得1050万美元元宇宙引擎投资,推出3D个人星球功能

获 3000 万美元融资,Crogl 发布面向安全分析师的全新 AI "钢铁侠战衣"

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

Tavus 推出系列 AI 模型,实现实时人脸交互技术突破

Welevel 获得 570 万美元融资,革新程序化游戏开发

AI 驱动的卓越运营:企业如何通过人人可及的流程智能提升成功