移动云COCA创新成果发布,助力构建未来开放式算力架构

10月12日下午,2023中国移动全球合作伙伴大会“算网融百业 数智赢未来”政企分论坛开幕,移动云重磅发布COCA创新成果、OpenCOCA开源项目和《OpenCOCA白皮书》,助力构建未来开放式算力架构。

论坛上,围绕“创新引领”“应用绽放”“生态共赢”三大主题,众多业界专家展开深入探讨与分享,为中国数字新基建出谋划策。中国移动集团总经理董昕表示,深入贯彻党和国家的重要指示,中国移动系统构建新型信息基础设施,创新打造新型信息服务体系,加速各行各业数智化转型,促进智能化、绿色化、融合化发展,为做强做优做大我国数字经济、以信息化助力中国式现代化贡献更大力量。

中国移动政企事业部总经理陈怀达发表题为《数智引领启新篇,行业创新赢未来》的主题演讲。他指出,践行“为国建云”使命,移动云近年来取得了跨越式的发展,正加速朝一流云服务商迈进。未来,作为中国移动创新发展的关键引擎,移动云将继续以高起点建设云基础设施、高标准研发云全栈产品,筑牢一流信创云底座,推进算网服务走深走实,助力实现创新发展新高度。

为践行“为国建云”使命,解决关键技术卡脖子问题,移动云发力算力网络的底层技术,于今年4月推出COCA(Compute on chip Architecture)软硬一体片上计算架构(以下简称COCA)。COCA由DPU、GPU、HPN三大核心模块构成,旨在重塑计算架构、融通算力生态、提供海量AI算力,打造高性能算力基础设施。

本次政企论坛,移动云重磅发布了COCA的多项阶段性成果,以更宏大的算力、更高效的链接、更可靠的能力,赋能千行百业数智化转型升级。

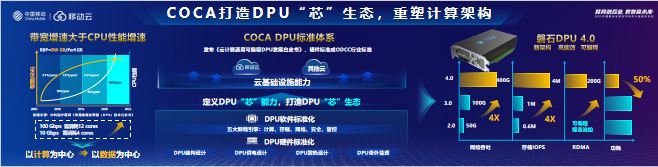

打造DPU“芯”生态,重塑计算架构

在DPU方面,移动云自研磐石DPU,重新定义DPU硬件和软件标准体系。会上发布的磐石DPU4.0网络吞吐能力提升至400Gbps,存储IO能力提升至400万,新增可编程的RDMA能力,支持带宽达到200Gbps,同时功耗降低50%,整体达到业界领先水平。

繁荣GPU生态,融通算力生态

在GPU方面,移动云打造COCA AI算力融通平台,并牵头建设“一云多芯”信创实验室。目前,该平台可提供200余个标准的核心算子接口,与多家合作伙伴开展深度适配。用户可实现一次编码在多家GPU平台上执行,大大降低研发和迁移成本。

目前,COCA AI算力融通平台已实现AI算力资源池化、具备CPU与GPU解耦订购能力,推理场景下用户成本可降低50%以上。

突破智算互联瓶颈,提供海量AI算力

在HPN方面,移动云推出面向RoCE的“乌蒙”高性能网络(COCA-HPN),原创“乌蒙”拥塞流控协议,实现了高精度的拥塞信号检测能力,可降低拥塞时延,提升集群算效。在智算中心的典型“中长流”场景下,集群网络性能可提升48%,还可支持万卡级智算集群组网能力。

移动云希望与更多合作伙伴一起以COCA-HPN为平台,联合创新端网协同的高性能网络技术,攻克业界“卡脖子”的大规模集群互联难题。

秉承共赢理念,构建OpenCOCA开放技术生态

秉承“开放+共赢”的理念,移动云开放COCA核心成果。论坛现场,移动云举行了OpenCOCA开源项目暨《OpenCOCA白皮书》发布仪式,并倡议国内云产业相关企业、机构加入OpenCOCA,联创高性能算力技术,形成产业联盟,共筑高性能算力基础设施,共促数字产业及技术生态成熟,共助中国数字经济繁荣昌盛。

论坛上,移动云还为技术生态优秀合作伙伴代表举行了颁奖仪式,进一步牵引产业能力汇聚,共创云端合作新局面,共攀产业发展新高峰。

作为网络强国、数字中国、智慧社会建设的主力军,移动云将继续加快算力网络基础设施建设与关键核心技术自主可控,促进软硬生态架构逐步走向开放,助力打造国家级自主可控的算网基础设施,迈向中国式现代化建设的新征程。

来源:业界供稿

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元