英特尔退出傲腾存储业务,传统金字塔架构不灵了? 原创

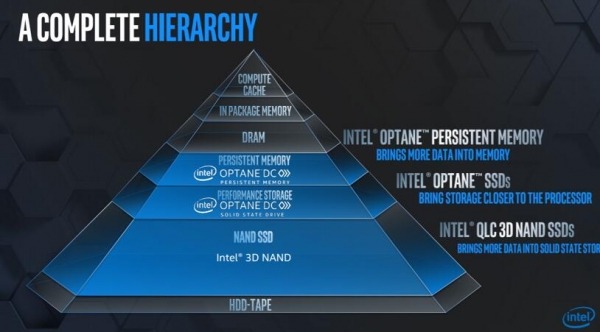

在2017年英特尔推出傲腾产品的时候,有一张金字塔状的架构图就频频出现在业界。

简单来说,从计算系统诞生以来,CPU的内部缓存、DRAM、内存和HDD之间就存在着性能差异。缓存和内存能够最快速的处理数据,但是不能保留数据,HDD能够长久存储数据,但是存在读写性能和时延等问题。

因此一个理想的计算平台,存储之间需要分层,来达到与CPU和内存之间的容量和性能的平衡。把频繁访问的数据向上移动靠近内存、不经常访问的数据向下移动靠近SSD甚至于HDD。如果每个层级的容量能够达到上一层级的10倍,这样每一层级都(自下而上)逐渐保留“更热”的数据,使处理器可以快速访问这些数据。

过去几年,英特尔推出傲腾技术和英特尔3D NAND技术来填补内存和SSD之间的缺口。

如果把存储介质看做一个金字塔最高层的是DRAM,价格较高,延时也最低,主要作为缓存;

DRAM往下是就是3D XPoint基于DIMM的存储产品;3D XPoint和DRAM还是有区别,第一个容量可以做得更大,大概在10倍左右,延迟参数比DRAM差一些;

再往下是3D NAND SSD产品,在性能,密度,成本等方面都有很大区别。

但是今天Intel确认,将逐步结束Optane存储业务,不再开发未来新产品。而是转向CXL架构。

CXL(Compute Express Link),是由英特尔于2019年3月在InterconnectDay 2019上推出的一种开放性互联协议,能够让CPU与GPU、FPGA或其他加速器之间实现高速高效的互联,从而满足高性能异构计算的要求。

CXL标准有一个较大优势就是内存一致性。通俗而言就是能够添加更多的内存,来构建一个更大的内存池,而当前计算平台而言,大内存容量决定了大容量工作负载的性能,从这方面看,CXL 架构的发展对上图金字塔架构会进行重构,甚至变革。

因此在CXL 标准面前,作为并不是必须存在的傲腾存储只能退出历史舞台。

好文章,需要你的鼓励

五家光学存储初创公司追逐百年级存档存储

五家光学存储初创公司正在开发长期存储技术,旨在用超过100年寿命的光学介质替代只有5-7年寿命的磁带。这些公司包括Cerabyte、Ewigbyte、HoloMem、Optera和SPhotonix,它们的技术类似微软Project Silica项目。光学存储介质具有更强的化学、冲击、辐射、水和热抗性,同时保持低能耗和高容量特性。

北大学者带你拖拽3D物体,像玩拼图一样让虚拟世界动起来

北京大学团队开发的DragMesh系统通过简单拖拽操作实现3D物体的物理真实交互。该系统采用分工合作架构,结合语义理解、几何预测和动画生成三个模块,在保证运动精度的同时将计算开销降至现有方法的五分之一。系统支持实时交互,无需重新训练即可处理新物体,为虚拟现实和游戏开发提供了高效解决方案。

Nutanix推出分布式主权云服务 强化多云环境安全运营

Nutanix发布分布式主权云产品组合更新,为多云环境提供更安全的运营和管理功能。该解决方案支持企业在分布式环境中灵活部署和治理基础设施,运行传统虚拟机、现代云原生和AI应用。新功能包括支持完全断网环境的暗站点管理、政府云集群正式发布、Kubernetes平台增强安全合规性、企业AI平台集成NVIDIA微服务,以及云平台新增跨站点灾难恢复能力,为用户提供统一管理和运营简化体验。

达尔豪斯大学团队重磅研究:为什么AI社会模拟需要从“沙盒游戏“升级为“开放世界“?

达尔豪斯大学研究团队系统性批判了当前AI多智能体模拟的静态框架局限,提出以"动态场景演化、智能体-环境共同演化、生成式智能体架构"为核心的开放式模拟范式。该研究突破传统任务导向模式,强调AI智能体应具备自主探索、社会学习和环境重塑能力,为政策制定、教育创新和社会治理提供前所未有的模拟工具。