浪潮获中国移动咪咕AI亿元大单过半份额

近日,浪潮成为中国移动子公司咪咕文化科技有限公司(简称咪咕)2018年GPU服务器采购项目的最大供应商,获得亿元采购订单一半份额。浪潮将为咪咕提供涵盖创新AI服务器AGX-2、高效深度学习并行计算框架Caffe-MPI和人工智能深度学习管理系统AIStation在内的全球领先的AI计算基础架构。此次成功中标中国移动子公司咪咕,标志着浪潮在AI赋能运营商领域取得重要突破,将成为运营商AI应用的示范标杆。

咪咕是中国移动面向移动互联网领域设立的,负责数字内容领域产品提供、运营、服务的一体化专业子公司。目前, 咪咕已成为国内领先的全场景品牌沉浸平台,汇聚超过1700万+首歌曲、430万条视频、1200+路音视频直播、50万+册书刊、3万+款游戏、47万集动漫画。基于如此庞大而海量的数据,咪咕承载着中国移动大部分的人工智能业务。而为了更好的开展人工智能技术的研发与应用,咪咕投入巨资建设超大规模的人工智能线下训练平台、线上推理平台及相应的云计算平台,重点研发适用于通信行业的人脸识别、智能客服、舆情分析等AI技术和应用。

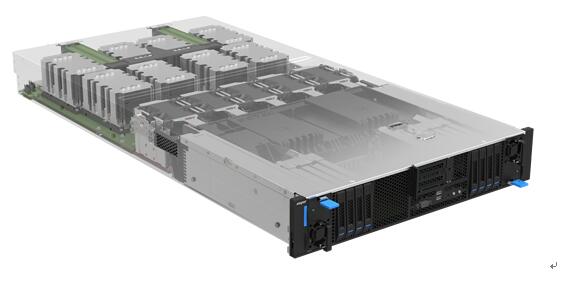

浪潮为咪咕提供了涵盖创新AI服务器AGX-2、高效深度学习并行计算框架Caffe-MPI和人工智能深度学习管理系统AIStation在内的全球领先的AI计算基础架构。AGX-2是全球首款在2U空间内高速互联集成8颗最高性能GPU加速器的服务器,在2U空间内支持部署8块NVLink或PCI-E 接口的NVIDIA Tesla P100 GPU,并在业界率先支持NVLink 2.0和NVIDIA Tesla 16GB/32GB V100。同时,AGX-2具备拓扑的灵活性可支持NVIDIA NVLink和PCIe两种GPU互联方案,采用NVIDIA NVLink时可提供GPU间高带宽低延迟互联以及高达300GB/s的吞吐量。AGX-2具备良好的I/O扩展能力,提供8块NVMe/SAS/SATA热插拔硬盘,可支持最多4块100Gbps的EDR InfiniBand接口卡的高速集群互联;AGX-2不仅支持通常的风冷散热方式,还可支持片上水冷以提供更高的计算能效比。

浪潮AI服务器AGX-2

浪潮开发的深度学习并行计算框架Caffe-MPI和人工智能深度学习管理系统AIStation,使得深度学习框架的并行效率更高,并有效降低AI集群的管理复杂度。其中,在基于国际通行的Imagenet数据集进行深度学习模型训练时,浪潮Caffe-MPI表现出良好的并行扩展性,其性能是Google最新深度学习框架TensorFlow的近两倍。而浪潮AIStation可以提供从数据准备到分析训练结果的完整深度学习业务流程,支持Caffe、TensorFlow、CNTK等多种计算框架和GoogleNet、VGG、ResNet等多种模型,支持对训练过程实时监控并可视化训练过程,支持打印每一步的损失函数值的日志、训练误差或测试误差等,支持动态分配GPU资源实现资源合理共享,实现了"一键式"部署深度学习计算环境、快速启动训练任务,实时监控集群的使用情况,合理安排训练任务,可及时发现运行中的问题,提高集群的可靠性。

此外,深入理解咪咕的AI应用、联合开展相应的POC测试、协助搭建AI训练模型、不断提出优化建议,无疑是浪潮此次成功中标咪咕的"加分项"。这些无形的"软实力"让咪咕能够更加快速的开展AI模型训练的相关研究,并为应用加速提供了良好的服务支撑。

凭借着对产品技术创新能力的重视、对AI赋能行业的深刻洞察、以及对生态建设持之以恒的投入,浪潮在AI计算市场上取得了突飞猛进的发展。现在,浪潮在中国AI计算产品领域市场份额第一,是百度、阿里和腾讯等领先科技公司AI服务器的最主要供应商,占有率达到90%。 同时,浪潮与科大讯飞、今日头条、Face++、网易、东方网力等公司在AI系统与应用方面,一直保持着深入持续的合作,帮助客户在语音、视频、图像、搜索、网络等各方面取得数量级的应用性能与计算力的大幅提升。

好文章,需要你的鼓励

CIO总结2025年人工智能实用化的十大关键启示

2025年人工智能在企业中实现突破性应用,从实验阶段转向实用阶段。八位代表性CIO分享核心经验:AI工具快速进化、需保持快节奏实验思维、重视工作流程而非组织架构、数据质量成为新挑战、采用前瞻性指标管理项目、无需等待完美时机、AI既是技术也是社会文化现象、需严格项目管理、变革重在人员而非技术、多智能体架构成未来趋势。

加州伯克利分校联合多所高校推出MomaGraph:让机器人像人类一样理解空间和功能的突破性研究

这项由加州伯克利分校等机构联合完成的研究开发了MomaGraph系统,首次实现了机器人对空间关系和功能关系的统一理解。该系统通过强化学习训练,能够同时识别物品位置和操作方法,并具备状态感知能力。在综合测试中达到71.6%准确率,超越同类开源系统11.4%,在真实机器人平台上验证了实用性,为智能家庭机器人的发展奠定重要基础。

软银竭力筹措225亿美元资金支持OpenAI

日本科技投资巨头软银需要在年底前筹集225亿美元,以履行对AI合作伙伴OpenAI的资金承诺。软银是OpenAI价值5000亿美元Stargate数据中心计划的主要资助者之一。为筹集资金,软银CEO孙正义可能动用多种手段,包括利用其持有的英国芯片设计公司Arm股份作为抵押贷款。软银已清仓英伟达股份为该项目提供资金,目前可通过Arm股份借贷115亿美元,还持有价值110亿美元的T-Mobile股份及270亿美元现金储备。

MIT团队重新定义生成模型:用学会的“逆向“替代精确逆向,速度提升697倍!

MIT研究团队提出了突破性的双向归一化流(BiFlow)技术,通过训练独立的逆向模型替代传统的精确逆向过程,解决了归一化流方法架构受限和推理缓慢的核心问题。该方法采用创新的隐藏对齐策略,让逆向模型学习高效的生成路径,在ImageNet数据集上实现了高达697倍的速度提升,同时将图像质量提升到新的技术水平,为生成模型领域带来了重要的思路突破。

这款古怪的 AI 智能手机可以创建你的数字分身

Hugging Face 首席科学官担忧 AI 正在成为"服务器上的应声虫"

AI 公司效仿 DeepSeek,通过"蒸馏"技术打造低成本模型

物理 AI 如何通过嵌入式智能改变行业格局

Sergey Brin 表示:如果谷歌员工每周工作 60 小时,AGI 指日可待

Tencent 发布新 AI 模型,称速度快于 DeepSeek-R1

IBM 发布新的 Granite 3.2 系列模型,实现按需推理能力

Anthropic 的 Claude 3.7 Sonnet 推理模型可以按需延长思考时间

DeepSeek 超越"开放权重"AI,计划发布源代码

iPhone 16E 证明苹果急切希望用户使用其 AI 功能