IDC:2017年中国AI基础架构市场增速235%,浪潮占比57%居第一

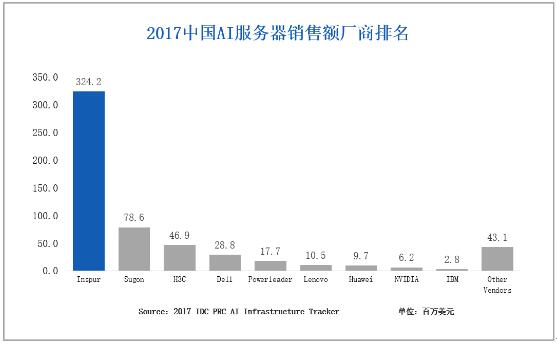

日前IDC公布2017年中国AI基础架构市场调查报告,报告显示,2017年中国AI服务器整体销售额5.68亿美元,出货量27863台;从竞争格局层面,浪潮份额明显领先其他厂商,居市场第一,出货量达到14,674台,销售额达3.24亿美元,占比分别为52.7%和57%,超过其他厂商份额的总和。

AI仍是台风中心 未来五年GPU服务器占比16.6%

原引IDC报告,AI"仍然处于台风中心",2017年AI市场的整体投入达到8.65亿美元,同比增长240%,未来5年复合增长率将超过50%,AI市场包括了硬件、软件和服务三大细分领域。

硬件系统部署对于AI发展至关重要,也是AI市场主要构成,2017年AI硬件销售额同比增长235%,在AI整体市场占比72.4%,预计到2022年市场容量将达到37.7亿美元,其中GPU服务器采购将达34亿美元,占整体x86服务器市场的16.6%。

AI进入新纪元 互联网是主要推动力

互联网运营商仍然是AI发展的力量主体,采购额为4.07亿美元,占整体市场的71.7%。

2017年是AI发展转折性的一年。此前腾讯、阿里巴巴、百度投资构建的专业AI基础架构,以支持行为分析、搜索、广告点击预测等运营商内部业务系统为主,到2017年,几乎所有互联网运营商都开始加大AI业务投资,加快AI基础设施建设,一些大型CSP开始对外提供AIaaS云服务。

IDC数据显示,浪潮市场优势核心来自于互联网行业,市占率达68%。百度、阿里巴巴、腾讯TOP级运营商90%以上AI服务器来自浪潮,今日头条、科大讯飞、网易、平安等Tier2、Tier3互联网运营商和行业用户也在大批量采购浪潮的各类AI基础架构的系统方案及产品。

4GPU和8GPU出货占比提高

AI基础架构在实际应用驱动下快速更迭。以GPU服务器为例,由于GPU跨节点通信瓶颈问题,服务器支持的GPU数量越来越大。根据IDC报告,2017年4GPU和8GPU服务器出货比例提高,销售额占比分别为36.9%和25.8%。

浪潮是目前GPU服务器产品线最齐全的厂商之一,2017年相继发布了SR-AI 整机柜服务器、AGX-2超算服务器、GX4 AI加速扩展Box等AI新品。SR-AI是全球首个采用PCIe Fabric互联架构设计的AI方案,可实现支持16个GPU的超大扩展性节点,该方案最大支持64块GPU,并且很好的解决了供电与散热问题,这款产品符合天蝎2.5标准,适合于超大规模云数据中心部署。AGX-2是全球首款在2U空间内高速互联集成8颗最高性能GPU加速器的服务器,是目前性能密度最高的AI基础架构方案,适合于各种数据中心环境。

传统行业不可忽视

虽然当前AI发展和应用主体力量是互联网运营商,但是传统行业将是AI未来更大的发展空间,尤其是金融、电信、零售、医疗健康等行业的AI应用将会更快,制约AI在传统行业应用的主要问题是用户技术能力缺乏,尤其是AI系统方案的部署运维。

在不断巩固互联网优势的同时,浪潮构建了完整的AI系统平台,即计算平台、管理套件、框架优化、应用加速四个层次,包含GPU、FPGA等AI服务器系列、深度学习训练集群管理软件AIStation、AI性能调优工具Teye以及集群版开源深度学习框架Caffe-MPI等完整解决方案。

浪潮集团副总裁彭震表示,浪潮正在构建深入行业场景的AI产业生态,和伙伴一起为用户提供端到端的AI整体方案,推进AI更广泛的商业化场景。

新时代塑造新格局

彭震表示,数据中心层面的云计算变革和应用层面的AI变革将推动基础架构产业的创新与重构,浪潮业绩的高速增长得益四大动力,创新的JDM业务模式、智能工厂投产、开放计算推进及AI市场的提前布局,深耕AI仍将是2018年浪潮的核心策略之一。

在刚刚结束的IPF18浪潮云数据中心合作伙伴大会上,浪潮发布全新AI品牌--TensorServer,同时启动T计划。浪潮希望抓住新时代下的两大发展机遇,在5年内成为全球最大的计算方案供应商。

好文章,需要你的鼓励

SanDisk重塑经典SSD品牌:WD Black和Blue正式更名为Optimus系列

西部数据闪存业务分拆后,SanDisk宣布将停用广受欢迎的WD Black和Blue品牌,推出全新的SanDisk Optimus系列NVMe产品线。WD Blue驱动器将更名为SanDisk Optimus,而高端WD Black驱动器将分别更名为Optimus GX和GX Pro。尽管品牌变更,底层硬件和供应链保持不变。然而受全球内存短缺影响,预计2026年第一季度客户端SSD价格可能上涨超过40%。

上海AI实验室研究者想出妙招:让AI像优秀学生一样高效思考,告别“想太多“毛病

上海AI实验室开发RePro训练方法,通过将AI推理过程类比为优化问题,教会AI避免过度思考。该方法通过评估推理步骤的进步幅度和稳定性,显著提升了模型在数学、科学和编程任务上的表现,准确率提升5-6个百分点,同时大幅减少无效推理,为高效AI系统发展提供新思路。

福特汽车准备在车载系统中引入AI智能助手

福特汽车在2026年消费电子展上宣布将在车辆中引入AI助手技术。该AI助手最初将在福特和林肯智能手机应用中推出,从2027年开始成为新车型的原生功能。福特希望通过AI技术实现车辆个性化体验,提供基于位置、行为和车辆能力的智能服务。同时,福特将采用软件定义车辆架构,推出自研的高性能计算中心,提升信息娱乐、驾驶辅助等功能。

MIT团队让机器人终于不再“卡顿“:一种让机器人像人一样流畅反应的突破性技术

MIT团队开发的VLASH技术首次解决了机器人动作断续、反应迟缓的根本问题。通过"未来状态感知"让机器人边执行边思考,实现了最高2.03倍的速度提升和17.4倍的反应延迟改善,成功展示了机器人打乒乓球等高难度任务,为机器人在动态环境中的应用开辟了新可能性。

智能体驱动全球创新浪潮,微软携手前沿伙伴迈进消费电子新未来

达索系统在CES 2026上展示AI驱动的医疗创新, 重塑精准、可预测与个性化医疗

Arm 发布 20 项技术预测:洞见 2026 年及未来发

美光推出全球首款面向客户端计算的 PCIe 5.0 QLC SSD

SanDisk重塑经典SSD品牌:WD Black和Blue正式更名为Optimus系列

福特汽车准备在车载系统中引入AI智能助手

ChatGPT推出健康模式:结合医疗数据提供个性化建议

福特推出AI数字助理及新一代BlueCruise自动驾驶技术

联想Legion Pro可卷曲概念机展现移动大屏游戏新体验

印度和新加坡在智能体AI采用方面超越全球同行

华硕CES 2026新品:更小巧的ProArt GoPro笔记本和升级版Zenbook Duo

n8n警告CVSS满分漏洞影响自托管和云版本