如果你有100万美元AI预算:来看看Pure和Nvidia联手打造的AIRI系统吧

Pure Storage和Nvidia打造了一个融合的机器学习系统,以使用数百万个数据点训练人工智能模型。

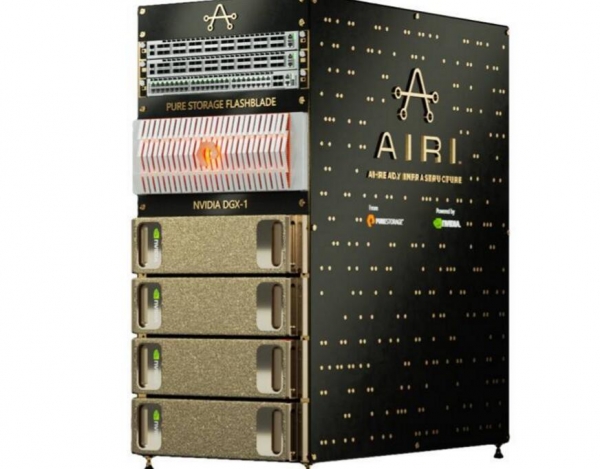

这个被称为AIRI(AIRI-AI-Ready Infrastructure)的系统将Pure FlashBlade全闪存阵列与4个Nvidia DGX-1 GPU加速系统以及一对100GbitE交换机结合在一起。

该系统由Pure和Nvidia共同设计,据说在购买、部署和操作方面要比单独购买和集成组件更容易更简单,是标准化的融合基础设施。

AIRI是你数据中心所需要的

FlashBlade是Pure Storage的全固态存储阵列,可快速访问非结构化数据,这个4U系统包含15个垂直安装的刀片或对象节点服务器,每个刀片都有一个多核英特尔至强CPU和17TB闪存,总共255TB容量,或者数据缩减后523TB有效容量。每个刀片还包含一对ARM核心、一个FPGA、NVRAM和基于PCIe的网络。这绝对不是基于SSD的商用系统。

这是一个强大的并行访问闪存阵列,在AIRI中必须配置超过160,000个GPU核心。

AIRI将数据提供给4台基于英特尔至强处理器、配有8个Tesla V100 GPU(与NVlink相连)的DGX-1系统。这些都是性能强大的GPU,每个配有5,120个CUDA核心,640个Tensor核心,16MB缓存和带宽为900GB/s的16GB HBM2内存组。V100使用64位浮点运算的最大输出功率为7.5TFLOPS,32位浮点运算为15TFLOPS。

除了32个V100之外,AIRI还有163,840个CUDA核心和20,480个Tensor核心。我们得知,AIRI提供了4个Tensor PFLOPS,一个方面是应用(机器学习任务)必须在容器中运行。

为了连接到外部世界,采用了若干个支持GPUDirect RDMA的Arista 100GbE交换机,这为使用PCIe的GPU和FlashBlades之间数据传输提供了直接快速的路径。FlashBlade和DGX-1之间的接口是基于文件的:NFS over ROCE (RDMA Over Converged Ethernet)。

这里使用了具体哪款Arista产品并未对外透露。

有两个包含的软件项目:

- Nvidia的GPU Cloud Deep Learning Stack。

- AIRI扩展工具包,它是一个配置验证器和多节点训练管理系统。

Pure表示,这款软件将可以帮助数据科学家在几个小时内——而不是数天或数周——启动并运行机器学习项目。

在机器学习领域,AIRI的竞争对手包括HPE的Apollo 6500 gen-10系统和增强采用GPU的IBM AC922服务器,AIRI看起来更强大一些。

HPE的Apollo 6500 gen-10使用单精度浮点数学运算的性能高达125 TFLOPS。同样条件下单个V100大约可以达到15 TFLOPS,这意味着一个DGX-1的性能就可以达到大约120 TFLOPS,而AIRI则可以达到480 TFLOPS,不是一个量级的。

IBM的AC922支持多达6个Tesla V100 GPU,比单个DGX-1少2个,而AIRI有4个DGX-1,同样地,和IBM系统不是一个量级的。

Pure表示,多个训练任务可以并行运行,并且在AIRI上比其他系统完成地更快,运行时间减少到原来的1/4。

价格怎么样? Pure没有提供价格信息,称这取决于渠道供应商,但会一定程度上反映组件的成本。

计算一下,4个DGX-1大约是60万美元。Arista交换机的成本在3,000美元以上,而FlashBlade的成本低于1美元/ GB,这意味着523TB的有效容量的成本将低于523,000美元。

所以这可能是一个百万美元量级的系统,适合大型企业或专有客户购买。该系统支持4个DGX-1,但可以从1个-2个DGX-1开始部署,降低前期成本。

目标客户是那些需要运行大量大型机器学习任务、对数百万数据项目进行模型训练的组织。

每个DGX-1的功耗为3.2kW,因此在考虑存储和网络以及英特尔计算芯片等因素之前,你的功耗已经接近13kW。

目前Pure已经通过特定经销商合作伙伴提供AIRI,包括ePlus Technology、FusionStorm、GroupWare Technology、PNY、Trace3、World Wide Technology和Xenon等。

来源:The Register

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。

稚晖君发布全球最小全身力控人形机器人,上纬启元开启个人机器人时代

2026年软件定价大洗牌:IT领导者必须知道的关键变化

Linux 在 2026 年将势不可挡,但一个开源传奇可能难以为继

CES 2026趋势展望:全球最大科技展五大热门话题预测

人工智能时代为何编程技能比以往更重要

AI颠覆云优先战略:混合计算成为唯一出路

谷歌发布JAX-Privacy 1.0:大规模差分隐私机器学习工具库

谷歌量子AI发布新型优化算法DQI:量子计算优化领域的重大突破

缓解电动汽车里程焦虑:简单AI模型如何预测充电桩可用性

Titans + MIRAS:让AI拥有长期记忆能力

Gemini为STOC 2026大会理论计算机科学家提供自动化反馈

夸克AI眼镜持续升级:首次OTA,支持89种语言翻译

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币